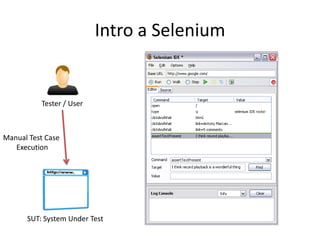

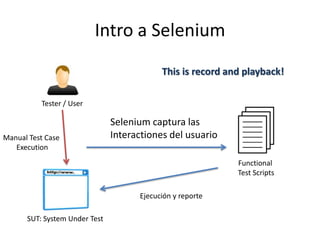

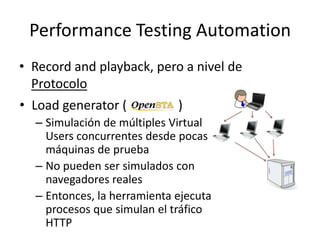

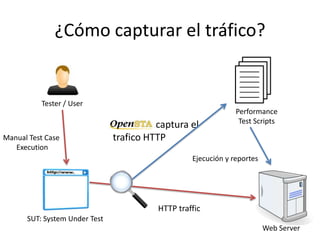

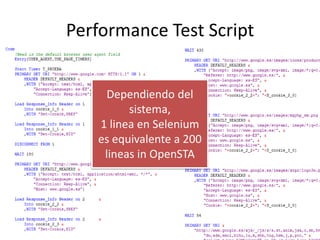

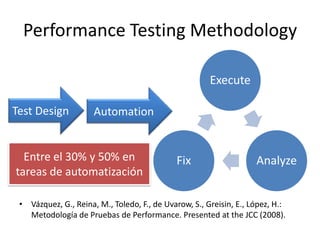

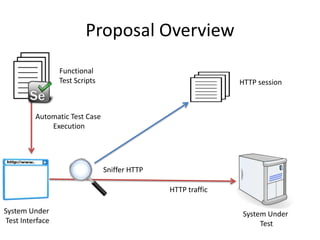

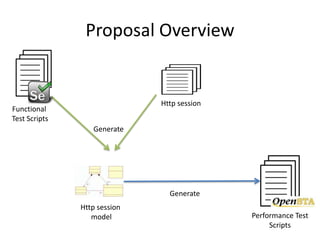

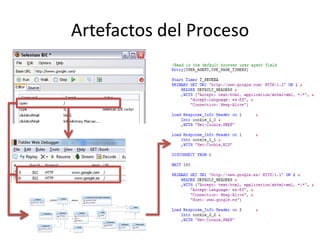

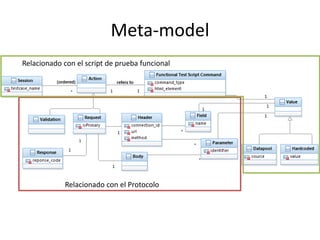

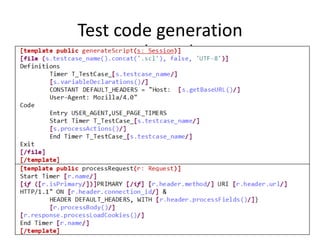

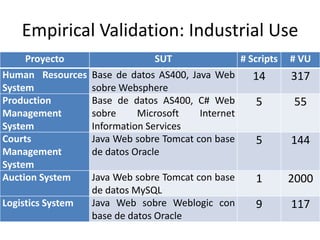

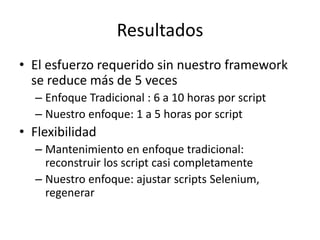

El documento presenta una metodología para la automatización de pruebas funcionales y de rendimiento en sistemas web, enfatizando la reducción de costos y la mejora de la flexibilidad en la generación de scripts de prueba. Se propone un enfoque que utiliza scripts de Selenium para facilitar la creación de pruebas de rendimiento, logrando una disminución significativa en el esfuerzo requerido para su implementación. Además, se discuten trabajos relacionados y se plantean direcciones futuras para el desarrollo de generadores de carga.