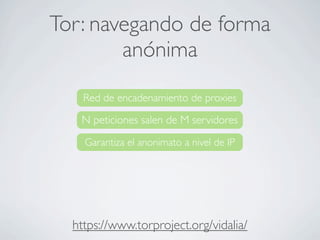

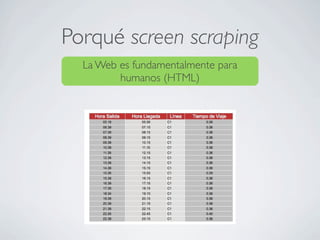

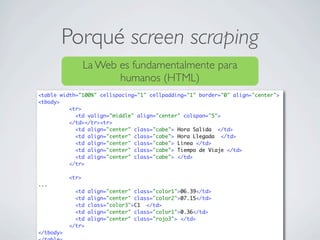

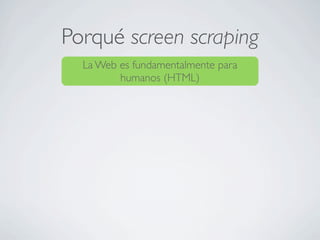

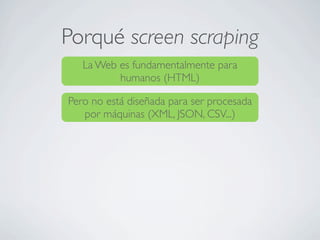

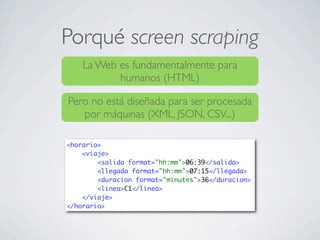

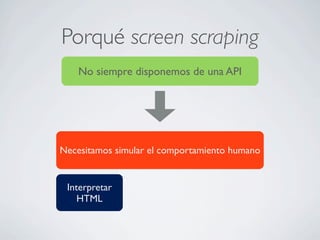

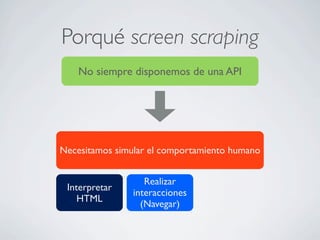

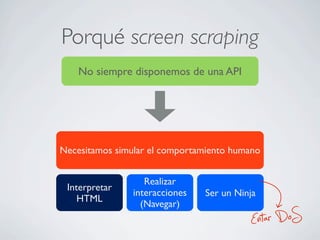

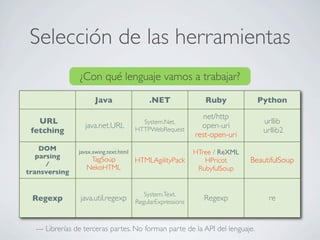

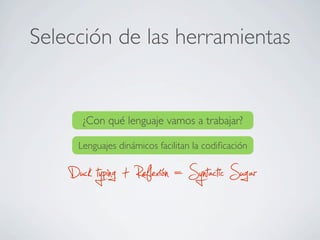

El documento aborda el screen scraping en el desarrollo de aplicaciones, destacando la dificultad de trabajar con HTML, que está diseñado para humanos y no para máquinas. Se discuten diversas herramientas y lenguajes de programación para realizar scraping, como Java, Ruby y sus respectivas bibliotecas, además de mencionar el uso de proxies y técnicas para navegar de forma anónima. También se presentan ejemplos prácticos de cómo extraer información de sitios web y simular interacciones humanas.

![import javax.swing.text.html.*;

import javax.swing.text.Element;

import javax.swing.text.ElementIterator;

import java.net.URL;

import java.io.InputStreamReader;

import java.io.Reader;

public class HTMLParser

{

public static void main( String[] argv ) throws Exception

{

URL url = new URL( "http://java.sun.com" );

HTMLEditorKit kit = new HTMLEditorKit();

HTMLDocument doc = (HTMLDocument) kit.createDefaultDocument();

doc.putProperty("IgnoreCharsetDirective", Boolean.TRUE);

Reader HTMLReader = new InputStreamReader(url.openConnection().getInputStream());

kit.read(HTMLReader, doc, 0);

ElementIterator it = new ElementIterator(doc);

Element elem;

while( elem = it.next() != null )

{

if( elem.getName().equals( "img") )

{

String s = (String) elem.getAttributes().getAttribute(HTML.Attribute.SRC);

if( s != null )

System.out.println (s );

}

}

System.exit(0);

}

}

Java](https://image.slidesharecdn.com/screenscraping-101102103433-phpapp01/85/Screen-scraping-17-320.jpg)

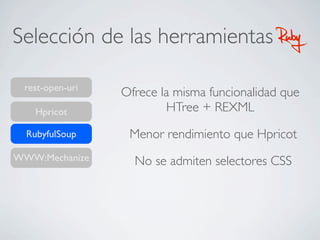

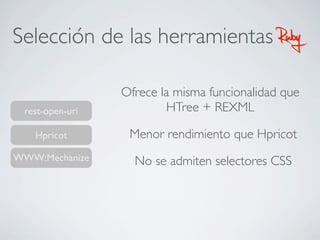

![HTree+REXML

require 'rubygems'

require 'open-uri'

require 'htree'

require 'rexml/document'

open("http://www.google.es/search?q=ruby",:proxy=>"http://localhost:8080") do |page|

page_content = page.read()

doc = HTree(page_content).to_rexml

doc.root.each_element('//a[@class=l]') {|elem| puts elem.attribute('href').value }

end

Runtime: 7.06s.](https://image.slidesharecdn.com/screenscraping-101102103433-phpapp01/85/Screen-scraping-21-320.jpg)

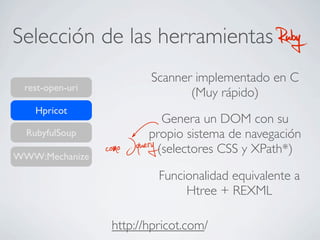

![HPricot

require 'rubygems'

require 'hpricot'

require 'open-uri'

doc = Hpricot(open('http://www.google.com/search?q=ruby',:proxy=>'http://localhost:8080'))

links = doc/"//a[@class=l]"

links.map.each {|link| puts link.attributes['href']}

Runtime: 3.71s](https://image.slidesharecdn.com/screenscraping-101102103433-phpapp01/85/Screen-scraping-23-320.jpg)

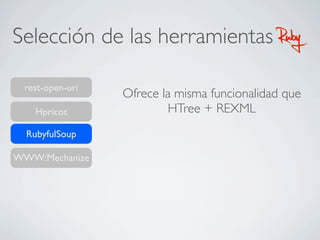

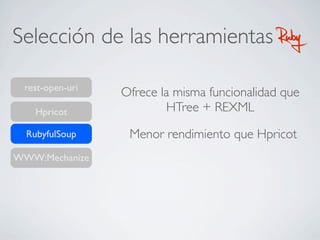

![Rubyful Soup

Runtime: 4.71s

require 'rubygems'

require 'rubyful_soup'

require 'open-uri'

open("http://www.google.com/search?q=ruby",:proxy=>"http://localhost:8080") do |page|

page_content = page.read()

soup = BeautifulSoup.new(page_content)

result = soup.find_all('a', :attrs => {'class' => 'l'})

result.each { |tag| puts tag['href'] }

end](https://image.slidesharecdn.com/screenscraping-101102103433-phpapp01/85/Screen-scraping-27-320.jpg)

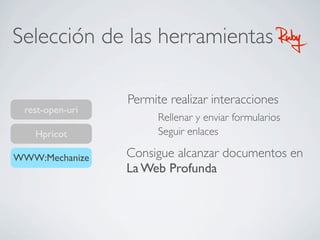

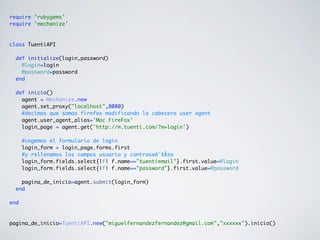

![WWW::Mechanize

Runtime: 5.23s

require 'rubygems'

require 'mechanize'

agent = Mechanize.new

agent.set_proxy("localhost",8080)

page = agent.get('http://www.google.com')

search_form = page.forms.select{|f| f.name=="f"}.first

search_form.fields.select {|f| f.name=='q'}.first.value="ruby"

search_results = agent.submit(search_form)

search_results.links.each { |link| puts link.href if link.attributes["class"] == "l" }](https://image.slidesharecdn.com/screenscraping-101102103433-phpapp01/85/Screen-scraping-33-320.jpg)

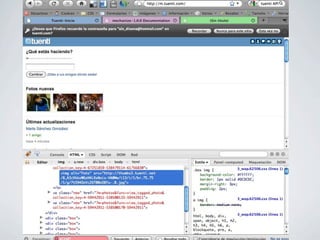

![Paso 2: Obtener las fotos

class TuentiAPI

...

def fotos_nuevas()

tree=Hpricot(inicio().content)

fotos = tree / "//a//img[@alt=Foto]"

fotos.map!{|foto| foto.attributes["src"]}

Set.new(fotos).to_a

end

private

def inicio()

...

end

end](https://image.slidesharecdn.com/screenscraping-101102103433-phpapp01/85/Screen-scraping-45-320.jpg)