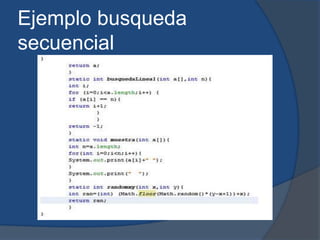

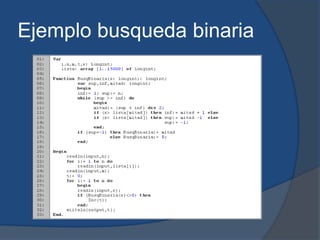

Los spiders son programas que recorren las páginas web recopilando información sobre su contenido. Se dividen en tres partes: programas exploradores, constructores de bases de datos y programas de usuario. Algunos ejemplos son Googlebot y Bingbot. Los algoritmos de búsqueda como el secuencial y el binario buscan elementos dentro de una estructura de datos. Google usa algoritmos como PageRank, de relevancia y Panda para clasificar los resultados. Las bases de datos organizan y relacionan datos para su posterior uso; algunos tipos son jerárquicas,