Calidad de datos (data quality)

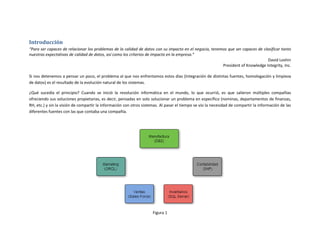

- 1. Introducción “Para ser capaces de relacionar los problemas de la calidad de datos con su impacto en el negocio, tenemos que ser capaces de clasificar tanto nuestras expectativas de calidad de datos, así como los criterios de impacto en la empresa.” David Loshin President of Knowledge Integrity, Inc. Si nos detenemos a pensar un poco, el problema al que nos enfrentamos estos días (Integración de distintas fuentes, homologación y limpieza de datos) es el resultado de la evolución natural de los sistemas. ¿Qué sucedía el principio? Cuando se inició la revolución informática en el mundo, lo que ocurrió, es que salieron múltiples compañías ofreciendo sus soluciones propietarias, es decir, pensadas en solo solucionar un problema en específico (nominas, departamentos de finanzas, RH, etc.) y sin la visión de compartir la información con otros sistemas. Al pasar el tiempo se vio la necesidad de compartir la información de las diferentes fuentes con las que contaba una compañía. Figura 1

- 2. Para resolver este tema, la solución fue generar conectores entre los diferentes sistemas, lo cual funcionaba de una manera limitada ya que había que generar un conector por cada sistema con el cual se querían comunicar, provocando esto un difícil mantenimiento para soportar las diferentes comunicaciones entre sistemas. Figura II Con esta conectividad nació el problema de comunicación entre los diferentes sistemas, es decir, como ya mencionamos, cada sistema tenía su propio formato para almacenar la información, por lo que, al interactuar con otros sistemas, los desarrolladores se vieron forzados a homologar y estandarizar dicha información por cada conector para poderla interpretarla y así se pudiera comunicar con las demás. El siguiente paso en esta evolución fue buscar la manera de evitar múltiples conectores, buscando con esto la manera de tener todo centralizado dando como resultado un mantenimiento más fácil; así nació la integración de la información.

- 3. Figura 3 Con esta integración también se logró la centralización de los procesos para limpieza y calidad de datos, dándole más forma y peso a estas tecnologías. Un buen ejemplo de esto son los DataWareHouse, en donde tenemos que integrar, homologar, estandarizar y limpiar la información (Data Quality) antes de poblar los modelos. Lo que nos lleva a nuestra siguiente pregunta. ¿Qué es la calidad de datos? La calidad de datos se refiere a los procesos y técnicas enfocados a mejorar la eficacia de los datos existentes en nuestras bases de datos. Para que un proceso de calidad de datos sea realmente eficaz, este deberá ser repetible y fácil de entender de manera que permita generar un proceso que se vuelva un ciclo de mejora y que cada vez que sea ejecutado genere datos con mayor calidad. Este proceso deberá de incluir perfilamiento, normalización, correspondencia (match) y consolidación, los cuales generarán reportes para dar seguimiento a los progresos y permitir la mejora continua de la calidad de los datos. Algunos de los beneficios de la calidad de datos son:

- 4. Ahorrar costos directos: evitando tener información duplicada. Supervisar y limpiar de forma proactiva los datos de todas las aplicaciones, y mantener limpios esos datos. Permitir al negocio compartir la responsabilidad de la calidad y del gobierno de datos. Impulsar mejores resultados con unos datos empresariales fiables. Proceso de la calidad de datos Lo primero que necesitamos saber para implementar los procesos de limpieza y calidad de datos, es ¿Qué tan bien o mal están mis datos?, es decir, debemos de tener un punto de partida (métrica), que me indique el estado de los datos que estoy utilizando. Para lograr esto, se lleva a cabo un perfilamiento de los datos, el cual me indica cómo se encuentran estos y a partir de ahí, detectar que es lo que necesito corregir. Para llevar a cabo estas correcciones, también debo de contar con unos parámetros de control que me ayuden a medir el avance en mis procesos de calidad. Estos parámetros son conocidos como, las seis dimensiones de calidad de datos. Las seis dimensiones de la calidad de datos Estas son consideradas como los puntos clave que debe de cubrir la calidad de los datos, para asegurar nuestros procesos de limpieza y calidad; dichos puntos se enumeran a continuación: DIMENSIONES PARA LA CALIDAD DE DATOS Completitud En una tabla o conjunto de datos (dataset), ¿tenemos campos en blanco, o fueron llenados con valores por default? ¿Los datos son utilizables? En algunos casos, los datos que no están, son irrelevantes, pero cuando se vuelven necesarios para un proceso del negocio, estos se vuelven críticos. Conformidad Los datos que están en los campos de la tabla, ¿están en un formato estándar y legible? Consistencia Al hacer el cruce de información con los registros, ¿existe información contradictoria?

- 5. DIMENSIONES PARA LA CALIDAD DE DATOS Precisión / Exactitud Si los datos no son precisos, estos no pueden ser utilizados. Para detectar si estos son precisos, se compara el dato con una fuente de referencia. Duplicación ¿Tenemos la misma información en formatos iguales o similares dentro de la tabla? Integridad ¿Toda la información relevante de un registro está presente de forma que se pueda utilizar? El entendimiento de estas seis claves es el primer paso para la mejora de la calidad de datos. Ser capaz de separar los defectos de los datos clasificándolos por estas dimensiones, nos permite aplicar las técnicas adecuadas para mejorar tanto la información como los procesos que crean y manipulan la información. ID Nombre_Cliente Tipo_person a Ultima_fecha _facturacion Estatus _client e Direccion_1 Direccion_2 Direccion_3 541 Juan Luis Valdez Persona 23-Jan-12 Activo Av. Del Corral #45 Col. San Juan Monterrey, N.L. 542 IBM Empresa 11-Jul-12 Activo Periferico Sur 39 Int.41 Col. Chapultepec Mexico, D.F. 543 Andrea Sanchez Persona Activo Av. Hidalgo No. 129 Col. Chapulin Gdl. 544 Jose Luis Rosas Persona 23-May-12 Baja 24F Del. Juarez Taxco 545 Coca-Cola Corp. Empresa 6-Feb-13 Activo Juan Polainas 253 Col. Alta Mata Veracruz 546 Baby Crazy Persona 23-Mar-12 Activo Calle 4 No. 78 Del. Alvaro Obregon Mexico, D.F. 547 Emilio Contreras Chavez Empresa 18-Apr-12 Activo Av. Insurgentes 31 Col. Escutia Puebla 548 Felipe Calderon del Rio Persona 11-Jun-13 Activo C/O Juan de la Barrera Col. Pedrito San Luis 549 Maria del Corral de Garduno Persona 30-Sep-12 Activo Av. 7 #428 Col. San Sergio Chalco, Edo. Mexico 550 OXXO Empresa 4-Oct-12 Activo Paseo de la Reforma No. 32 Col. Cuahutemoc Mexico, D.F. 551 Karina Salgado Marmolejo Persona 3-Dec-12 Baja Tollocan 52 Diamante Acapulco, Guerrero 552 Julian Garduno Flores Persona 1-Feb-13 Activo Xochitecatl 295 Del. Xochimilco Mexico, D.F. 553 Juan Valdes Persona 23-Nov-12 Activo Av. Del Corral #45 Col. San Juan Monterrey, N.L.

- 6. Completitud: Falta la fecha para Andrea Sanchez. Conformidad: Las direcciones no estan de acuerdo a los estandadres Consistencia: Baby Crazy es empresa y Emilio contreras es persona. Duplicacion. Integridad: Puede existir en la misma tabla o cruzando con otras, en este caso no se determnina que pueden ser familiarees. Precision/ Exactitud: No siempre se obtiene de la misma tabla, se puede validar con catalogos.

- 7. Pasos a seguir Perfilamiento Como primer paso en la calidad de datos, se necesita generar un perfil acerca de los mismos, el cual ofrece una completa investigación del contenido de cada uno de los datos del cliente que son críticos para la organización. El objetivo es identificar los problemas que podrían impedir el correcto uso de los datos. El perfilamiento de los datos le permite a las organizaciones responder los siguientes puntos sobre la información calve de sus datos. ¿Cuáles son los campos adecuados a utilizar para los procesos de coincidencia (mach)? ¿cuáles campos cuentan con la integridad suficiente? Ejemplo: si el campo edad es llenado o poblado el 25% de las veces, este no será un campo con suficiente integridad. ¿Cuántos campos contienen valores válidos y coherentes o consistentes? Ejemplo: el campo que almacena la fecha de nacimiento puede contener el 20% con el valor pre-establecido 01/01/1901 ¿Qué procesos de estandarización/limpieza requiere cada campo para ser utilizados de forma correcta? ¿Cuáles reglas son eficaces? Ejemplo: campos incompletos o inválidos pueden ser utilizados en los diferentes procesos, pero se deben de definir las reglas para que sean utilizados solo cuando la salida del proceso sea válida. El perfilamiento consiste en aplicar algoritmos especializados para investigar el contenido de los diferentes tipos de campos: • Perfiles de texto para nombre, dirección, correo electrónico y otros campos de texto libre. • Perfiles de carácter para los campos de código de fecha, números de teléfono y otros. • Contadores de frecuencia para valores definidos como: genero, ocupación, estado civil, etc. Durante la fase de perfilamiento se debe de revisar que los valores utilizados sean reales o patrones de datos obtenidos en las tablas de búsqueda (lookup). Los resultados obtenidos de esta fase serán una serie de reportes que identifican los problemas de calidad de datos para cada atributo seleccionado. Estandarización / normalización El objetivo de la fase de normalización de un proceso de gestión de calidad de los datos es eliminar o etiquetar los problemas detectados antes de pasar a la siguiente fase. En la fase de normalización cada uno de los campos clave se pasan a través de una serie de reglas definidas por el

- 8. usuario para eliminar inconsistencias y discordancias identificadas durante la etapa de perfilado de datos. La salida es una gama de nuevos campos de datos que contienen datos normalizados y mejorados. Durante la estandarización las tareas a realizar son: Eliminación de ruido, ejemplo: comentarios en campo de texto libre tales como “Dirección invalida”, los cuales podrían causar conflictos en el procesamiento de datos. Análisis de datos; ejemplo, nombre, dirección, descripción. Estandarización de términos; ejemplo, la utilización de diccionarios para corregir faltas de ortografía comunes, o el uso de funciones para estandarizar formatos como números telefónicos Obtener valores faltantes; ejemplo: obtener género a partir del nombre. Generación de indicadores de calidad de datos para su uso en las reglas de coincidencia (match); por ejemplo, registros con múltiples valores incompletos o no válidos pueden ser marcados. Los nuevos campos de datos creados durante la fase de normalización pueden ser utilizados únicamente para el proceso de coincidencia (match). También se pueden escribir al archivo fuente original para remplazar los datos originales con baja calidad de datos. Correspondencia/Match La correspondencia o match, identifica aquellos registros equivalentes, duplicados y relacionados dentro de una tabla o conjunto de datos (pueden ser más de dos tablas). De la misma manera, se puede identificar los datos inexactos mediante la comparación del conjunto de datos actual con un conjunto de datos de referencia. La búsqueda de coincidencia de identidad se puede utilizar para los datos de identidad y es particularmente efectiva en los datos no normalizados o sucios. La búsqueda de coincidencias, se hace sobre uno o varios atributos. Por ejemplo, se busca la coincidencia de personas utilizando su nombre, apellidos, fecha de nacimiento, teléfonos, etc. Estos elementos deberán de ser parte del atributo del elemento a buscar, en este caso, personas.

- 9. Consolidación La consolidación es el último paso en el proceso de calidad de los datos a pesar de que su salida puede formar parte de la base de datos que se utilizara para una iteración subsiguiente del ciclo de vida de calidad de los datos. La consolidación de datos administra el proceso de integración o vinculación de registros duplicados o relacionados. Facilitando la consolidación de los registros de una base de datos única o varias bases de datos. También se pueden añadir los datos consolidados a tablas de referencia o sobrescribir datos inexactos. http://sesa78.wordpress.com/