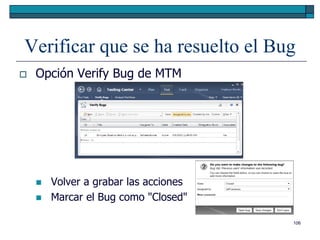

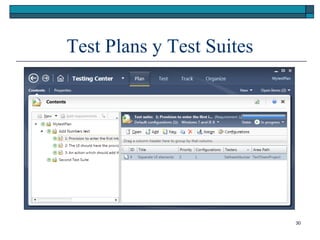

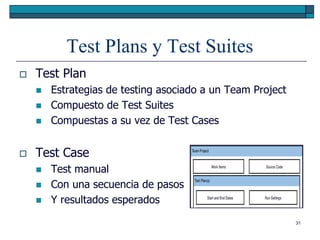

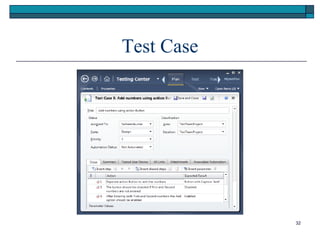

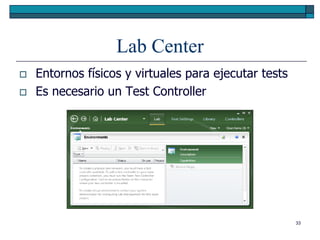

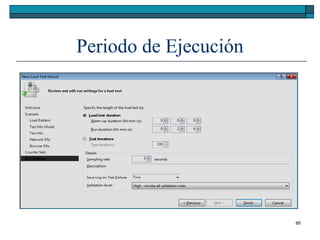

Este documento proporciona una introducción a Microsoft Test Manager 2010. Incluye temas como los tipos de pruebas (manuales, automatizadas, exploratorias), la planificación de pruebas, la ejecución de pruebas automatizadas y manuales, y la generación de informes. También explica cómo crear planes de pruebas, conjuntos de pruebas y casos de prueba en Microsoft Test Manager, y cómo configurar entornos de prueba.

![Microsoft Test Manager 2010

[Software Testing with Visual Studio 2010, Jeff Levinson]

1](https://image.slidesharecdn.com/testmanager2010mododecompatibilidad-130305124138-phpapp01/75/Microsoft-Test-Manager-2010-1-2048.jpg)

![Test en Visual Studio 2010

Unit test

Invoca a un método con parámetros determinados

Valida el retorno

Atributos

[TestClass]

[TestMethod]

21](https://image.slidesharecdn.com/testmanager2010mododecompatibilidad-130305124138-phpapp01/85/Microsoft-Test-Manager-2010-21-320.jpg)

![Test en Visual Studio 2010

Coded UI test

Tests de interfaz de usuario

A partir de una interacción grabada

UIMap

[CodedUITest]

[TestMethod]

22](https://image.slidesharecdn.com/testmanager2010mododecompatibilidad-130305124138-phpapp01/85/Microsoft-Test-Manager-2010-22-320.jpg)

![Ciclo de Vida de un Test Unitario

1. [TestClass]

2. [ClassInitialize]

3. [TestInitialize]

4. [TestMethod]

5. [TestCleanup]

6. [ClassCleanup]

44](https://image.slidesharecdn.com/testmanager2010mododecompatibilidad-130305124138-phpapp01/85/Microsoft-Test-Manager-2010-44-320.jpg)

![Asertos

Clase de validación de los resultados de un test

Assert

AreEqual(x, y, [mensaje])

AreSame(x, y, [mensaje])

Fail([mensaje])

Inconclusive([mensaje])

IsTrue(condición, [mensaje])

IsNull(x, [mensaje])

IsInstanceOfType(x, t, [mensaje])

45](https://image.slidesharecdn.com/testmanager2010mododecompatibilidad-130305124138-phpapp01/85/Microsoft-Test-Manager-2010-45-320.jpg)

![Asertos

StringAssert

Contains(cadena, subcadena, [mensaje])

Matches(cadena, regexp, [mensaje])

DoesNotMatch(cadena, regexp, [mensaje])

StartsWith(cadena, subcadena, [mensaje])

EndsWith(cadena, subcadena, [mensaje])

46](https://image.slidesharecdn.com/testmanager2010mododecompatibilidad-130305124138-phpapp01/85/Microsoft-Test-Manager-2010-46-320.jpg)

![Asertos

CollectionAssert

Contains(coleccion, item, [mensaje])

DoesNotContain(coleccion, item, [mensaje])

AllItemsAreNotNull(colección, [mensaje])

AreEquivalent(col1, col2, [mensaje])

IsSubsetOf(colPeque, colGrande, [mensaje])

AllItemsAreUnique(col, [mensaje])

AllItemsAreInstancesOfType(col, t, [mensaje])

47](https://image.slidesharecdn.com/testmanager2010mododecompatibilidad-130305124138-phpapp01/85/Microsoft-Test-Manager-2010-47-320.jpg)

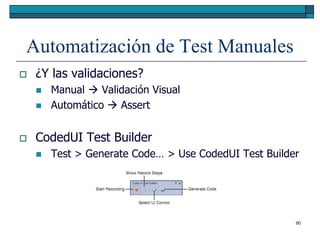

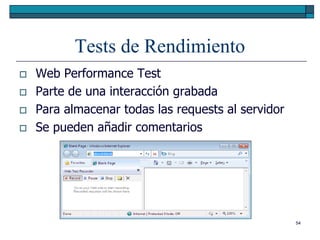

![Automatización de Test Manuales

Para regresión

CodedUI

Generado a partir de un test manual grabado

Ejercicio 6.1 página 142

Automatizar un test manual

Examinar el [TestMethod] generado

Examinar el UIMap generado y sus parámetros

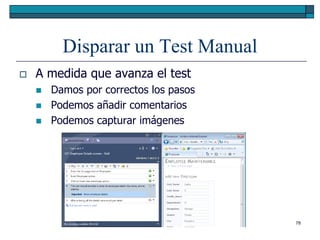

89](https://image.slidesharecdn.com/testmanager2010mododecompatibilidad-130305124138-phpapp01/85/Microsoft-Test-Manager-2010-89-320.jpg)