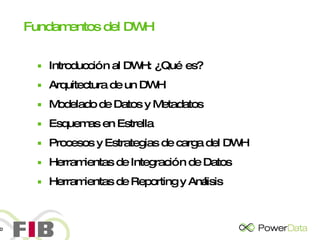

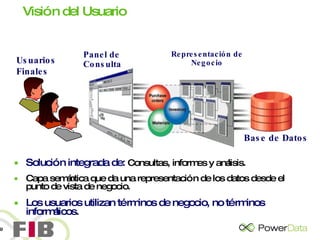

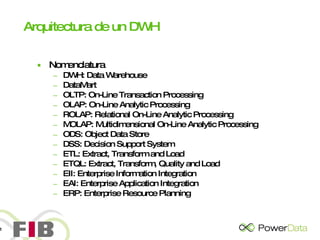

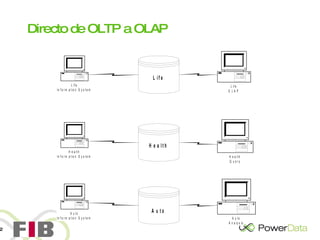

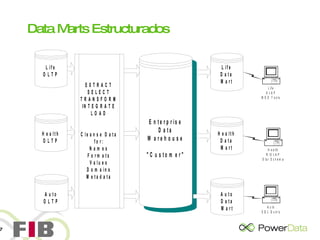

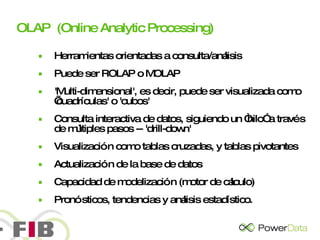

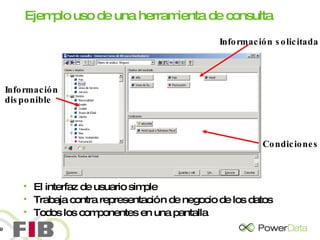

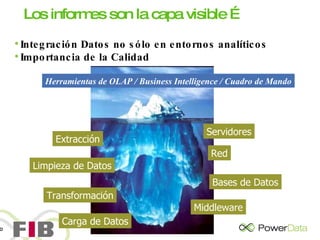

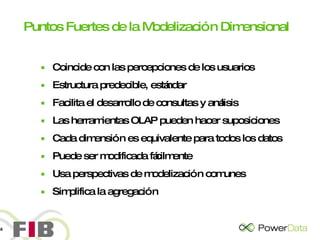

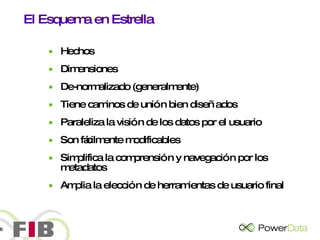

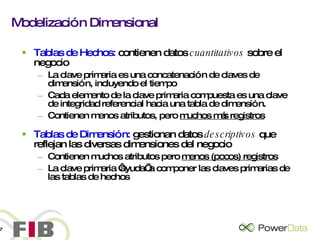

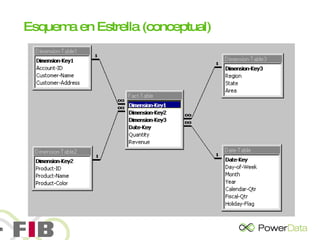

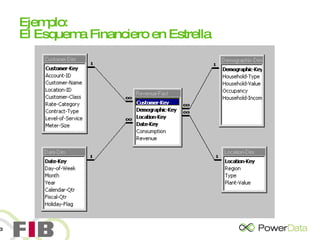

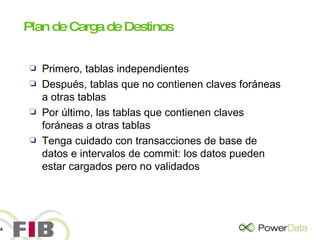

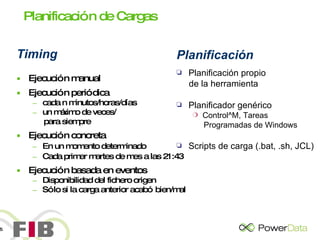

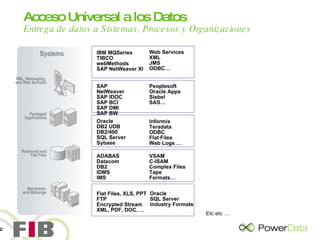

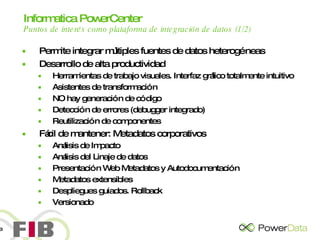

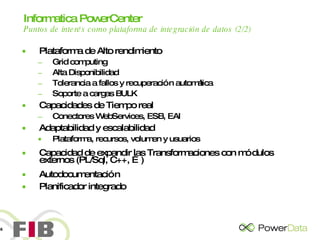

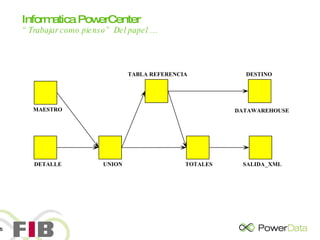

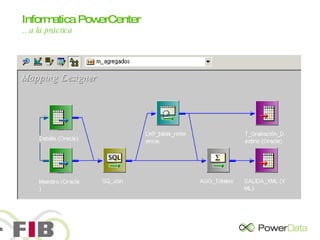

El documento presenta una agenda para una sesión sobre los fundamentos de un data warehouse. La sesión incluye introducciones, una discusión sobre los conocimientos y expectativas de los asistentes, y presentaciones sobre los fundamentos de un DWH como su arquitectura, modelado de datos, esquemas en estrella, procesos de carga y herramientas de integración y reporting.