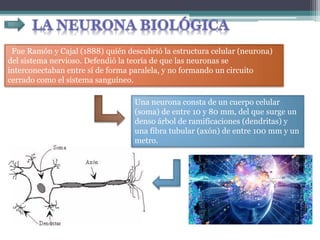

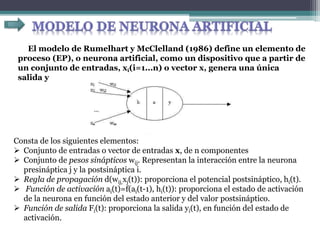

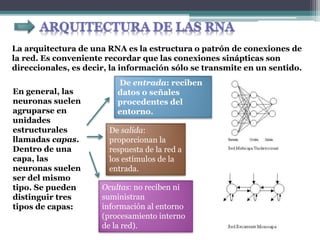

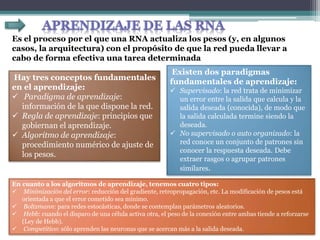

Este documento describe los fundamentos de las redes neuronales artificiales, incluyendo su inspiración en el sistema nervioso biológico, su arquitectura basada en neuronas interconectadas, y los algoritmos de aprendizaje como la retropropagación del error que permiten a las redes neuronales resolver problemas complejos.