Aproximacion de Funciones

•Descargar como PPT, PDF•

0 recomendaciones•444 vistas

Denunciar

Compartir

Denunciar

Compartir

Recomendados

Implementacion de la funcion logica xor, mediante un modelo neuronal y el alg...

Implementacion de la funcion logica xor, mediante un modelo neuronal y el alg...Tribunal Electoral Provincia de Misiones

Recomendados

Implementacion de la funcion logica xor, mediante un modelo neuronal y el alg...

Implementacion de la funcion logica xor, mediante un modelo neuronal y el alg...Tribunal Electoral Provincia de Misiones

Más contenido relacionado

La actualidad más candente

La actualidad más candente (14)

Redes de propagación hacia delante y aprendizaje supervisado

Redes de propagación hacia delante y aprendizaje supervisado

Similar a Aproximacion de Funciones

Similar a Aproximacion de Funciones (20)

Metodos Numericos para Integracion Y Derivadas.pdf

Metodos Numericos para Integracion Y Derivadas.pdf

Los 20 algoritmos matematicos mas importantes de la historia

Los 20 algoritmos matematicos mas importantes de la historia

Aproximacion de Funciones

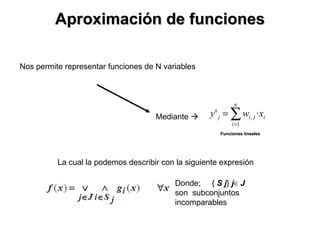

- 1. Aproximación de funciones Nos permite representar funciones de N variables Donde; { S j } j ∈ J son subconjuntos incomparables Mediante Funciones lineales La cual la podemos describir con la siguiente expresión