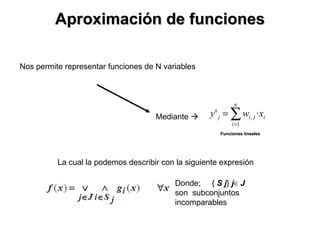

Este documento resume varios métodos de aprendizaje automático y redes neuronales, incluyendo aproximación de funciones, retropropagación con tasa de aprendizaje variable, el método del gradiente conjugado y el algoritmo de Levenberg-Marquardt. Explica que estos métodos permiten representar funciones mediante subconjuntos, modificar el algoritmo de retropropagación tradicional, minimizar funciones de error y converger hacia una solución optima.