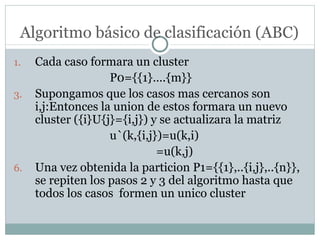

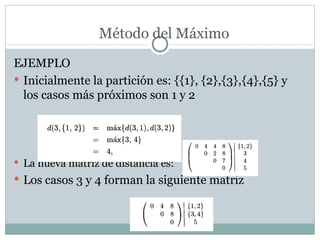

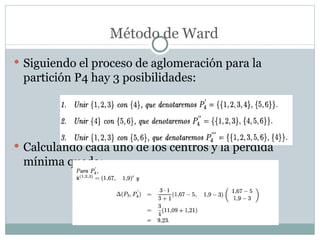

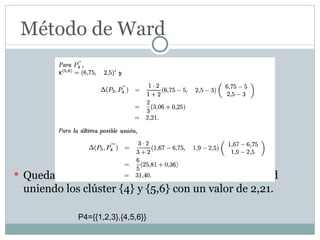

Este documento describe diferentes métodos de análisis de clusters como técnica de clasificación no supervisada. Explica las etapas de un análisis de clusters, incluyendo la selección de variables, métrica de distancia y técnica de clustering. Luego describe métodos jerárquicos como el método de enlace simple y métodos no jerárquicos como k-medias. Finalmente, ofrece ejemplos para ilustrar los diferentes métodos.