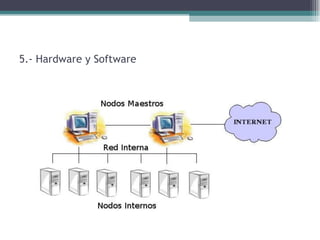

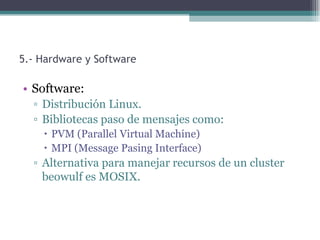

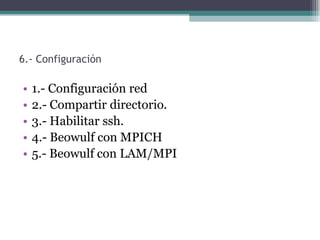

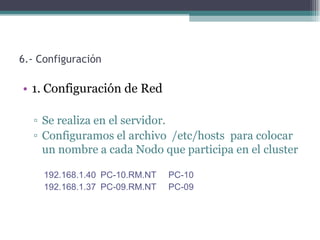

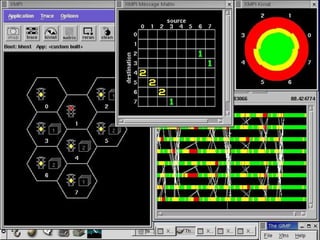

Un cluster Beowulf es un tipo de cluster computacional de bajo costo formado por nodos estándar conectados en red. Ofrece beneficios como mayor velocidad de procesamiento, confiabilidad y escalabilidad. Se pueden configurar usando software libre como Linux, MPI o LAM/MPI para ejecutar aplicaciones de forma paralela. Los clusters Beowulf son útiles para simulaciones, biotecnología y otros usos que requieren gran potencia de cómputo.