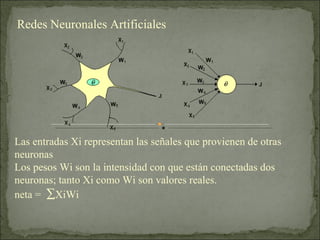

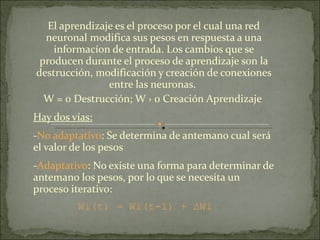

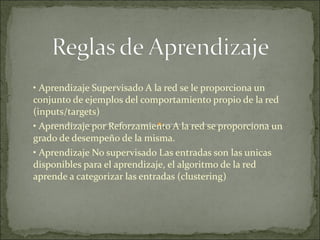

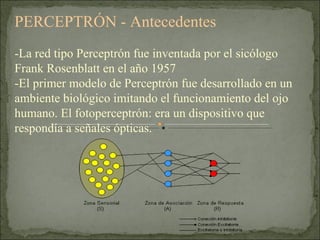

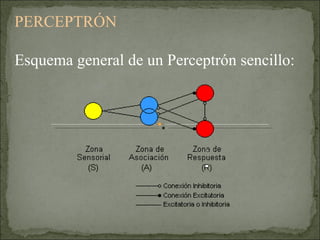

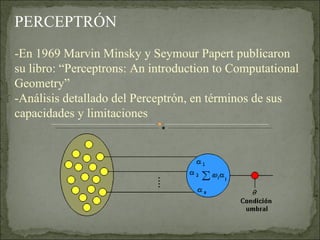

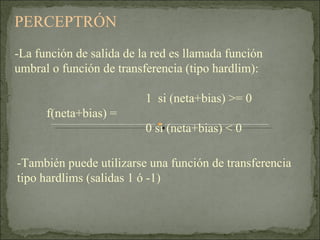

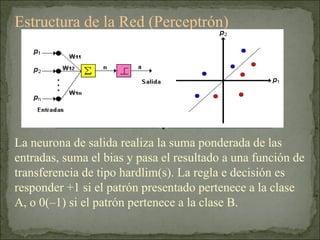

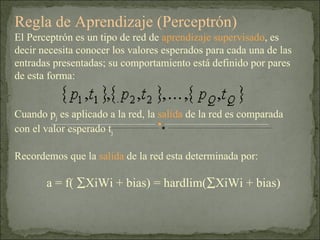

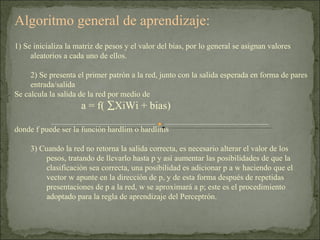

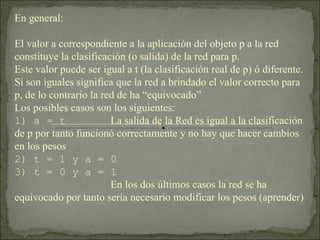

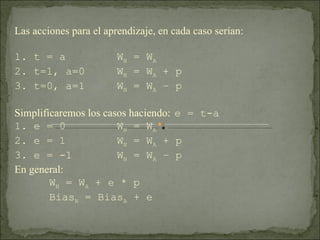

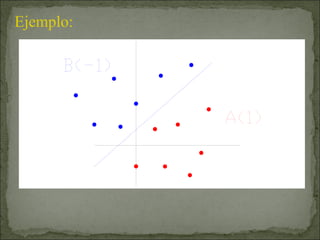

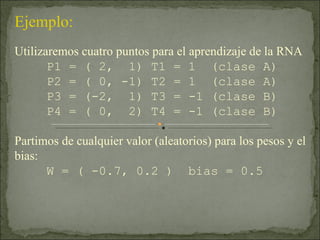

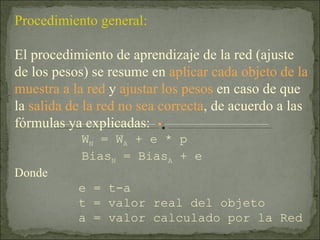

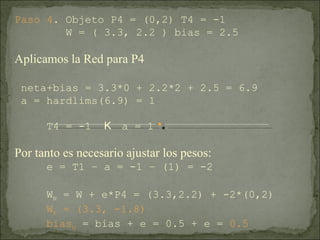

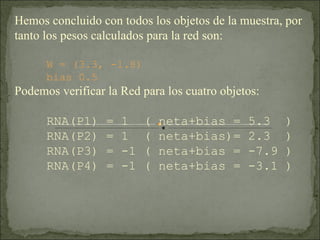

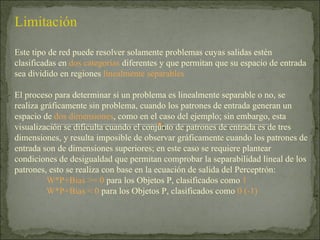

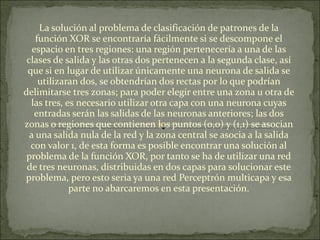

Las redes neuronales artificiales aprenden a modificar sus pesos en función de las entradas y salidas mediante procesos como el aprendizaje supervisado, no supervisado y por refuerzo. La red tipo perceptrón, desarrollada en la década de 1950, utiliza un algoritmo para ajustar sus pesos con base en la comparación de salidas esperadas y reales, permitiendo la clasificación de patrones en dos categorías. Sin embargo, su limitación radica en que solo puede resolver problemas que sean linealmente separables, complicándose con conjuntos de datos de mayor dimensión.