El documento describe el perceptrón, la primera red neuronal artificial desarrollada por Rosenblatt en 1958. Consiste en una capa de entrada y una capa de salida unidireccional conectadas. El perceptrón calcula la salida de cada unidad de procesamiento como una función del peso sináptico y la entrada, más un umbral. Se entrena mediante una regla de aprendizaje que ajusta los pesos para minimizar el error entre la salida deseada y la obtenida.

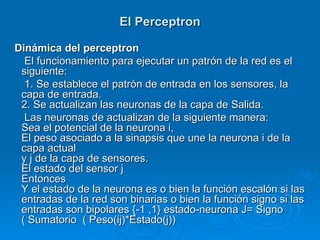

![El Perceptron - Algoritmo

Leer Numero_de_Patrones:

Numero_de_Entradas;

Inicializar Pesos( i );

Numero de Iteraciones;

1. Repita Hasta hay_error=Falso o Numero de iteraciones>500

Hay_Error=Falso

Repita desde patron=1 Hasta Numero_de_Patrones

Leer Entradas, Leer Salida_Esperada, Neta=0

Repita desde patron =1 Hasta Numero _de_Entradas

Neta=Neta+( Pesos( I )* Entradas( I ) ) [Suma Ponderada]

Neta=Neta+Umbral

Si Neta ≥0 entonces Salida=1 [Funcion Escalon]

Sino Salida=0

Error=Salida_Esperada – Salida

Si Error<>0 Entonces

Pesos (i)= Pesos(i) + (Error*Entradas(i))

Hay_Error=Verdadero

Umbral=Umbral + Error

Numero_de_Iteraciones = Numero_de_Iteraciones +1](https://image.slidesharecdn.com/perceptronparte1-120718193217-phpapp01/85/Perceptron-parte-1-10-320.jpg)