Modelo lineal genaral eco0

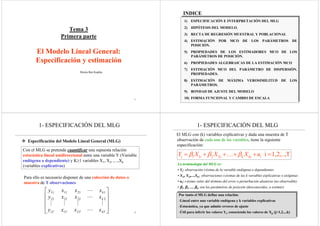

- 1. 1 Tema 3 Primera parte El Modelo Lineal General: Especificación y estimación Monia Ben Kaabia 2 1) ESPECIFICACIÓN E INTERPRETACIÓN DEL MLG 2) HIPÓTESIS DEL MODELO. 3) RECTA DE REGRESIÓN MUESTRAL Y POBLACIONAL 4) ESTIMACIÓN POR MCO DE LOS PARÁMETROS DE POSICIÓN. 5) PROPIEDADES DE LOS ESTIMADORES MCO DE LOS PARÁMETROS DE POSICIÓN. 6) PROPIEDADES ALGEBRAICAS DE LA ESTIMACIÓN MCO 7) ESTIMACIÓN MCO DEL PARÁMETRO DE DISPERSIÓN. PROPIEDADES. 8) ESTIMACIÓN DE MÁXIMA VEROSIMILITUD DE LOS PARÁMETROS. 9) BONDAD DE AJUSTE DEL MODELO 10) FORMA FUNCIONAL Y CAMBIO DE ESCALA INDICE 3 Especificación del Modelo Lineal General (MLG) Con el MLG se pretende cuantificar una supuesta relación estocástica lineal unidireccional entre una variable Y (Variable endógena o dependiente) y K≥1 variables X1, X2, ,...,Xk (variables explicativas) Para ello es necesario disponer de una colección de datos o muestra de T observaciones 211 2221212 1211111 ⎥ ⎥ ⎥ ⎦ ⎤ ⎢ ⎢ ⎢ ⎣ ⎡ kTTTT k k xxxy xxxy xxxy L MMMM L L 1- ESPECIFICACIÓN DEL MLG 4 1- ESPECIFICACIÓN DEL MLG El MLG con (k) variables explicativas y dada una muestra de T observación de cada una de las variables, tiene la siguiente especificación: T1,2,..,i2211 =++++= ikikiii uXXXY βββ K La terminología del MLG es: • Yi: observación i-ésima de la variable endógena o dependientes • X1i, X2i,...,Xki: observaciones i-ésimas de las k variables explicativas o exógenas • ui: i-ésimo valor del término del error o perturbación aleatoria (no observable) • β1, β2, ..., βk, son los parámetros de posición (desconocidos, a estimar) Por tanto el MLG define una relación: -Lineal entre una variable endógena y k variables explicativas -Estocástica, ya que admite errores de ajuste -Útil para inferir los valores Yi, conociendo los valores de Xji (j=1,2,..,k)

- 2. 5 1- ESPECIFICACIÓN DEL MLG El MLG tiene término constante cuando X1i=1 para todo i=1,...,T. En este caso, El MLG con (k-1) variables explicativas y una constante tiene la siguiente especificación: T1,2,..,i221 =++++= ikikii uXXY βββ K β1 es el término constante y β2, β3,...,βk las pendientes del modelo Muy importante: El MLG es Lineal porque los parámetros que figuran en su lado derecho lo hacen de forma lineal ( a lo sumo, están multiplicados por un término que no depende de ningún parámetro del modelo) 6 1- ESPECIFICACIÓN DEL MLG • Ejemplos: - Análisis de los determinantes de las ventas anuales de una empresa tttt uecioGpubventas +++= Pr321 βββ • Venta son las ventas anuales de la empresa en miles de euros • Gpub son los gatos anuales en publicidad realizados por la empresa en miles de euros • Precio es el precio de ventas del productos en euros por unidad - Análisis de los determinantes de los salarios de los trabajadores iiii uExpEduSalario +++= 321 βββ • Salario del individuo en euros por hora • Edu es su nivel de educación en años • Exp es el número de años que lleva trabajando 7 Especificación: representación matricial del MLG -La información asociada a la variable endógene se almacena en un vector columna Y de tamaño Tx1) -La información (datos) asociada a las variables explicativas se recoge en una matriz X de tamaño (Txk) -Las perturbaciones en un vector U de tamaño (Tx1) y los parámetros en un vector B de tamaño (kx1) ⎟ ⎟ ⎟ ⎟ ⎟ ⎠ ⎞ ⎜ ⎜ ⎜ ⎜ ⎜ ⎝ ⎛ = Ty y y Y M 2 1 1 1 1 2 222 121 ⎟ ⎟ ⎟ ⎟ ⎟ ⎠ ⎞ ⎜ ⎜ ⎜ ⎜ ⎜ ⎝ ⎛ kTT k k xx xx xx K MOMM L L U 2 1 2 1 ⎟ ⎟ ⎟ ⎟ ⎟ ⎠ ⎞ ⎜ ⎜ ⎜ ⎜ ⎜ ⎝ ⎛ = ⎟ ⎟ ⎟ ⎟ ⎟ ⎠ ⎞ ⎜ ⎜ ⎜ ⎜ ⎜ ⎝ ⎛ = Tk u u u MM β β β β 1- ESPECIFICACIÓN DEL MLG 8 1- Especificación: Representación Matricial del MLG UXY += β 1T1kkT1T 2 1 2 1 21 22212 12111 2 1 ×××× ⎟ ⎟ ⎟ ⎟ ⎟ ⎠ ⎞ ⎜ ⎜ ⎜ ⎜ ⎜ ⎝ ⎛ + ⎟ ⎟ ⎟ ⎟ ⎟ ⎠ ⎞ ⎜ ⎜ ⎜ ⎜ ⎜ ⎝ ⎛ ⎟ ⎟ ⎟ ⎟ ⎟ ⎠ ⎞ ⎜ ⎜ ⎜ ⎜ ⎜ ⎝ ⎛ = ⎟ ⎟ ⎟ ⎟ ⎟ ⎠ ⎞ ⎜ ⎜ ⎜ ⎜ ⎜ ⎝ ⎛ = TkkTTT k k T u u u xxx xxx xxx y y y Y MM K MOMM L L M β β β (Observaciones Vble. Endógena) Observaciones en periodo t=1 de todas las variables Observaciones variable x1 X Observaciones Vbles. Exp. Parámetros Perturbaciones

- 3. 9 1- Especificación: MLG con término constante UXY += β Y = X β + U 1T1kkT1T 1 1 1 2 1 2 1 2 222 121 2 1 ×××× ⎟⎟ ⎟ ⎟ ⎠ ⎞ ⎜⎜ ⎜ ⎜ ⎝ ⎛ + ⎟⎟ ⎟ ⎟ ⎠ ⎞ ⎜⎜ ⎜ ⎜ ⎝ ⎛ ⎟⎟ ⎟ ⎟ ⎠ ⎞ ⎜⎜ ⎜ ⎜ ⎝ ⎛ = ⎟⎟ ⎟ ⎟ ⎠ ⎞ ⎜⎜ ⎜ ⎜ ⎝ ⎛ TkkTT k k T u u u xx xx xx y y y MM K MOMM L L M β β β (Observaciones Vble. Endógena) Observaciones en periodo t=1 de todas las variables Observaciones variable x1=1 para i=1,...,T 10 1- Especificación: MLG con término constante obs ventas publicidad precio 1 120 8 100 2 115 9 102 3 130 10 95 4 142 14 90 5 148 12 92 6 144 16 94 7 165 20 88 8 160 22 86 9 175 26 90 10 180 24 86 Ejemplo: ventas de una empresa de aspiradores tttt uecioGpubventas +++= Pr321 βββ Tabla de datos para la estimación del modelo T=1,2,...,10 Especificación en forma matricial ⎟ ⎟ ⎟ ⎟ ⎟ ⎟ ⎟ ⎟ ⎟ ⎠ ⎞ ⎜ ⎜ ⎜ ⎜ ⎜ ⎜ ⎜ ⎜ ⎜ ⎝ ⎛ = 180 175 160 165 144 148 142 130 115 120 VENTAS ⎟ ⎟ ⎟ ⎟ ⎟ ⎟ ⎟ ⎟ ⎟ ⎠ ⎞ ⎜ ⎜ ⎜ ⎜ ⎜ ⎜ ⎜ ⎜ ⎜ ⎝ ⎛ = 86241 90261 86221 88201 94161 92121 90141 95101 10291 10081 X UXVENTAS += β ⎟ ⎟ ⎠ ⎞ ⎜ ⎜ ⎝ ⎛ = 3 2 1 β β β β 11 1.2- Interpretación gráfica del MLG: Gráfico de nube de puntos iii uxy ++= 121 ββ i=1,2,..,T * * * * * * * * * * * ** * xi yi Pdte = β2 Ord. Origen * ui β1 Interpretación de β1 -Gráfica: Ordenada en el origen Interpretación de β2 - Gráfica: pendiente de la recta de regresión - Económica: Efecto parcial - Matemática: Derivada parcial 1- Especificación y interpretación del MLG 12 1-2) Interpretación Económica y matemática del del MLG Cuando las variables explicativas son continuas (Cuantitativas), los parámetros del MLG pueden interpretarse como: Matemáticamente: derivadas (parciales) de la variable endógena con respecto a las variables explicativas. Económicamente: Efecto parcial de las variables explicativas sobre la endógena iii uxy ++= 110 ββ i i i i X Y dx dy 11 1 Δ Δ ==β β1 representa la variación absoluta en la variable endógena ante una variación de 1 unidad en la variable X1

- 4. 13 1.2) Interpretación Económica y matemática del del MLG Importante. Cuando en el MLG hay mas de una variables explicativas, en la interpretación de los parámetros hay que añadir la coletilla ceteris paribus . T1,2,..,i221 =+β++β+β= ikikii uXXY K βi representa la variación absoluta de la endógena (y) debido a una variación en una unidad de la explicativa (xi), suponiendo que los demás factores en (2) se mantienen constantes. 14 β0: es la constante o el término independiente β1:mide el cambio absoluto en Y ante un cambio en una unidad en la variable X1, manteniendo X2 constante (efecto ceteris paribus): β2: mide el cambio en Y ante un cambio en una unidad en la variable X2, manteniendo X1 constante (efecto ceteris paribus) iiii uxxy +++= 22110 βββ uxxy Δ+Δ+Δ=Δ 2211 ββ 02 =Δx 11 xy Δ=Δ β 01 =Δx 22 xy Δ=Δ β 1-2) Interpretación Económica y matemática del del MLG 15 Ejemplos del MLG: iiii uExpLEducSal +β+β+β= 210 β1: mide el efecto ceteris paribus del nivel de educación en el salario percibido. Es decir, representa la variación absoluta en el salario de cualquier trabajador debido a un año adicional de educación, suponiendo que los demás factores se mantienen constantes β2: mide el efecto ceteris paribus de los años de experiencia en el salario, es decir, representa la variación absoluta en el salario de cualquier trabajador debido a un año adicional de experiencia, suponiendo que los demás factores se mantienen constantes 1-2) Interpretación Económica del del MLG 16 2- Hipótesis del MLG La especificación completa del MLG no incluye solamente la forma de la relación entre Y y las k variables explicativas; Sino también la especificación de la distribución de probabilidad de la perturbación así como de la forma en que se han generado los valores de las explicativas Hace falta establecer una serie de hipótesis básica sobre la parte aleatoria y la parte sistemática del modelo

- 5. 17 2- Hipótesis del modelo • Supuesto 1: Muestreo aleatorio: {(yi, xi1, x2i,…xki); i=1, …, T} muestra aleatoria del modelo poblacional de tamaño T • Supuesto 2: Ausencia de error de especificación - Lineal - No se omiten variables relevantes - No se incluyen variables irrelevantes • Supuesto 3: Hipótesis de linealidad en los parámetros. Establece la linealidad en los parámetros en la relación entre la variable endógena y las explicativas. Es decir, en la función de consumo tendremos: ttt uRC ++= 21 ββ 18 2- Hipótesis del modelo • Supuesto 4: Grados de libertad suficientes:Tenemos mucho mas observaciones en la muestra que parámetros a estimar. Es decir, T-k>0. • Supuesto 5: Hipótesis de parámetros constantes. Esta hipótesis supone que los parámetros β1, β2, …,βk son constantes en el tiempo • Supuesto 6. Las variables explicativas son linealmente independientes Ausencia de multicolinealidad exacta 1 )( 0||)()( − ′∃⇒ ≠′⇒=′⇒= XX XXkXXrkXr 19 Supuesto 7. Regresores no estocaticos. Esta hipótesis implica que los datos de las variables explicativas son fijos en muestras repetitivas. Es decir: la parte sistemática y aleatoria son independientes: Cov(X,u)=0 Supuesto 8: Hipótesis de convergencia 2- Hipótesis del modelo xx T T XX Σ= ′ ∞→ lim Una matriz de constantes 20 2- Hipótesis del modelo Hipótesis referentes a las perturbaciones aleatorias • Supuesto 9. Esperance cero de las perturbaciones aleatorias: no hay error sistemático E(U)=0⇒ E(ui)=0 i T TT T uE uE uE u u u EUE 0 0 0 0 )( )( )( )( 2 1 2 1 1 = ⎥ ⎥ ⎥ ⎥ ⎦ ⎤ ⎢ ⎢ ⎢ ⎢ ⎣ ⎡ = ⎥ ⎥ ⎥ ⎥ ⎦ ⎤ ⎢ ⎢ ⎢ ⎢ ⎣ ⎡ = ⎥ ⎥ ⎥ ⎥ ⎦ ⎤ ⎢ ⎢ ⎢ ⎢ ⎣ ⎡ =× MMM

- 6. 21 2- Hipótesis del modelo Supuesto 10: Varianza de las perturbaciones aleatorias es constante a lo largo de la muestra: homoscedasticidad: i)()var( 22 ∀== σii uEu Supuesto 11: Covarianzas nulas entre un par de perturbaciones aleatorias distintas: Ausencia de autocorrelación en todo instante de tiempo ji0)(),cov( ≠∀== jiji uuEuu 22 . . xix1=80 x2=100 y if(yi) Las varianzas de ui en dos niveles distintos de renta familiar, xi , son identicas. gasto Caso Homoscedastico renta 23 . xtx1 x2 y i f(yi) La varianza de ui aumenta con la renta de la familia xi. gasto Caso Heteroscedastico x3 . . renta 24 2- Hipótesis del modelo Matriz de varianzas y covarianzas del vector de perturbaciones aleatorias )( 2 121 2 2 112 121 2 1 ⎟ ⎟ ⎟ ⎟ ⎟ ⎠ ⎞ ⎜ ⎜ ⎜ ⎜ ⎜ ⎝ ⎛ =′ uuuuu uuuuu uuuuu EUUE TT T T L MOMM L L Teniendo en cuenta S10+S11 TIUUE 2 2 2 2 00 00 00 )( σ σ σ σ = ⎟ ⎟ ⎟ ⎟ ⎟ ⎠ ⎞ ⎜ ⎜ ⎜ ⎜ ⎜ ⎝ ⎛ =′ L MOMM L L Las perturbaciones que cumplen ambos supuestos se denominan esféricas matriz de varianzas y covarianzas escalar

- 7. 25 2- Hipótesis del modelo Supuesto 12. ui se distribuye como una normal U ~ ),0( 2 TIN σ Nui ≈ Teniendo en cuenta: S9+S10+S11+S12 diiN ..),0( 2 σui ~ 26 2- Hipótesis del modelo UYEUYE XUEXUXEYE =⇒+= =+=+= )(-Y)(Y )()()( βββ ),( 2 TIXNY σβ≈ Características de la variable endógena bajo el cumplimiento de las hipótesis básicas del MLG UXY += β -Media y Varianza Y es un vector de variables aleatoria - Distribución: teniendo en cuenta en supuesto 12, entonces: S.9 [ ] TIUUEYEYYEYEYV 2 )())())((()( σ=′=′−−= S5+S7 ),0( 2 TINU σ≈S.12: S10+S11 27 3- Recta de regresión poblacional y muetral Ejemplo: Función de consumo keynesiano Especificación del modelo econométrico Yi=β1+β2Xi+ui E(Yi) = α + β Xi Cada media E(Yi) es una función de Xi. diiN ..),0( 2 σui ~ Teniendo en cuenta las hipótesis básicas del MLG: Esta ecuación se conoce como la recta de regresión poblacional (RRP). 28 Yi=α+βXi+ui 80 100 120 140 160 180 200 220 + + + + + + + + + + + + + + + + + + + + + + + + + + + +150 100 50 X Y Para cada valor de X existe una distribución de probabilidad completa de valores de Y

- 8. 29 + + + + Y X E(Yi)=α+βXi 80 100 120 89 77 65 Distribución de Y dado X=120 Media: E(Yi) Recta de Regresión Poblacional+ + + + + + + + 30 Especificacion Estocastica de la RRP Dado un nivel de renta Xi, el consumo familiar se concentra alrededor del consumo medio de todas las familias con nivel de renta Xi .. Es decir alrededor de su media E(Yi). La desviacion de un individuo Yi es: ui = Yi - E(Yi) o Yi = E(Yi) + ui o Yi = α + β X i+ ui Error estocastico o Perturbación aleatoria 31 La RRP es desconocida, al ser desconocidos los valores de α y β. Al estimarlos obtenemos la recta re regresión muestral (RRM): ii XˆˆYˆ β+α= Los valores de diferirán de los de Yi. Estas diferencias reciben el nombre de residuos : iYˆ iii uˆYˆY =− iuˆ Los residuos pueden considerarse como estimaciones de las perturbaciones 3-RECTA REGRESIÓN MUESTRAL 32 Recta de Regresión Muestral (RRM) . . . . Y4 Y1 Y2 Y3 x1 x2 x3 x4 } } { { 1 2 3 4 Y = α + βX x Y ^ ^ ^ E(Y) = α + βX (RRM) (RRP) Diferentes muestras tienen diferentes RRM uˆ uˆ uˆ uˆ

- 9. 33 RRM: Yi = α + β Xi o Yi = α + β Xi + ui o Yi = b1 + b2 Xi + ei RRP: Yi = α + β Xi + ui Yi = estimador de Yi (E(Yi) β y = estimadores de β y α Residuo Término del Error ^ ^ ^^ ^ ^ ^ ^ ^ αˆ 34Relacion entre Y, u y la recta de regresión verdadera. . . Y4 Y1 Y2 Y3 x1 x2 x3 x4 } } { u1 u2 x Y (RRM) (RRP) E(Y2) u2 ^ Y2 ^ XˆˆYˆ β+α= X)Y(E β+α= 35 4) Estimación MCO de los parámetros de posición 4.1) Introducción Supongamos que queremos estimar los parámetros de la función de consumo keynesiano: Yt=β1+β2Xt+ut Para ello, se dispone de una muestra de T datos de consumo y renta que se pude representar en un plano Yt y Xt Gráfico: Nube de puntos real * * * * * * * * * * * * * * Yt Xt 36 Una estimación de los parámetros del modelo se obtiene ajustando una recta a la nube de puntos * * * * * * * * * * * * * * Yt Xt Recta de ajuste: tt XY 21 ˆˆˆ ββ += El objetivo ahora es conseguir una estimación de los parámetros de manera que se cumpla algún criterio de optimización. ¿Qué criterio?

- 10. 37 1) Un criterio sería minimizar la suma de los residuos cometidos en toda la muestra 2) Minimizar la suma de los residuos en valor absoluto 3) Minimizar la suma de los cuadrados de los residuos ∑ =iuˆmin Problemas: los errores grandes y (+) se pueden compensar con los grandes y (-) ∑ =iuˆmin Dificultad analítica de obtener una solución para ∑ 2 ˆmin iu 2 21 )ˆˆ(min tt xy ββ −−∑ 38 El criterio de optimalidad seria obtener una expresión de que minimice la suma de los cuadrados de los residuos ∑ 2 ˆmin iu 2 21 )ˆˆ(min tt xy ββ −−∑ Ventajas: - Eliminar la compensación de errores por el signo - Penalizar más los errores grandes que los pequeños - Llevar a una solución analítica sencilla. Este criterio de estimación es el más conocido enEste criterio de estimación es el más conocido en Econometría y se denomina MCO (MínimosEconometría y se denomina MCO (Mínimos Cuadrados Ordinarios)Cuadrados Ordinarios) 39 4) Estimación MCO de los parámetros de posición kikii xxy β++β+β= ˆˆˆˆ 221 K ikikii uxxy ˆˆˆˆ 221 +β++β+β= K iikikiii yyxxyu ˆˆˆˆˆ 221 −=β−−β−β−= K MCO minimiza la SR= ∑ 2 iuˆ ∑ 2 iuˆ Sxxy kikii =β−−β−β−∑ 2 221 )ˆˆˆ( Kmin = min residuos 4-2) Estimación del modelo Lineal General 40 ∑ 2 iuˆ Sxxy kikii =β−−β−β−∑ 2 221 )ˆˆˆ( Kmin = min Condiciones de primer orden:Condiciones de primer orden: 0)ˆˆˆ(2 0)ˆˆˆ(2 0)ˆˆˆ(2 221 22112 2 221 1 =β−−β−β−−= β∂ ∂ =β−−β−β−−= β∂ ∂ =β−−β−β−−= β∂ ∂ ∑ ∑ ∑ kikiiki k kikiiii kikii xxyx S xxxyx S xxy S K M K K

- 11. 41 En forma matricial: βββ ˆˆˆ2ˆˆˆ 2 XXYXYYUUui ′′+′′−′=′=∑Min S= 0ˆ22 ˆ ˆˆ ˆ =β′+′−= β∂ ′∂ = β∂ ∂ XXYX UUS β′=′ ˆXXYX Sistema de ecuaciones normales: k ecuaciones normales y k incógnitas Condiciones de primer orden: 42 Una solución, si existe, es el estimado MCO del vector de parámetros β: YX)XX(ˆ 1 ′′=β − A Solución única si B ∞ soluciones si 0≠′XX 0=′XX β′=′ ˆXXYX 0=′XX Multicolinealidad exacta (Falla S.9) Supuestos utilizados -S2. Especificación correcta -S3. Linealidad en los parámetros -S4.Grados de libertad suficientes -S5. parámetros constantes -S6. No multicolinealidad exacta 43 ⎟⎟ ⎟ ⎟ ⎟ ⎟ ⎟ ⎠ ⎞ ⎜⎜ ⎜ ⎜ ⎜ ⎜ ⎜ ⎝ ⎛ ∑∑∑∑ ∑∑∑ ∑∑ ∑∑∑∑ ∑∑∑ − −− 2 12 1 2 132 323 232 2 32 32 kikiikkiiki kiikikii i kiiiiii kiii xxxxxx xxxxx xxx xxxxxx xxxT L LM MOO L L = ⎟ ⎟ ⎟ ⎟ ⎟ ⎠ ⎞ ⎜ ⎜ ⎜ ⎜ ⎜ ⎝ ⎛ ∑ ∑ ∑ kii ii i xy xy y M 2 ⎟ ⎟ ⎟ ⎟ ⎟ ⎠ ⎞ ⎜ ⎜ ⎜ ⎜ ⎜ ⎝ ⎛ β β β k ˆ ˆ ˆ 2 1 M β′=′ ˆXXYX Las k ecuaciones normales bajo la forma matricial 4) Estimación MCO de los parámetros de posición 44 1 2 12 1 2 132 323 232 2 32 32 − − −− ⎟ ⎟ ⎟ ⎟ ⎟ ⎟ ⎠ ⎞ ⎜ ⎜ ⎜ ⎜ ⎜ ⎜ ⎝ ⎛ ∑∑∑∑ ∑∑∑ ∑∑ ∑∑∑∑ ∑∑∑ kikiikkiiki kiikikii i kiiiiii kiii xxxxxx xxxxx xxx xxxxxx xxxT L LM MOO L L ⎟ ⎟ ⎟ ⎟ ⎠ ⎞ ⎜ ⎜ ⎜ ⎜ ⎝ ⎛ ∑ ∑ ∑ kii ii i xy xy y M 2 = ⎟ ⎟ ⎟ ⎟ ⎠ ⎞ ⎜ ⎜ ⎜ ⎜ ⎝ ⎛ kβ β β ˆ ˆ ˆ 2 1 M Expresión matricial del estimador MCO (modelo con término constante) YX)XX(ˆ 1 ′′=β − 4) Estimación MCO de los parámetros de posición

- 12. 45 4) Estimación MCO de los parámetros de posición Ejemplo: ventas de una empresa de aspiradores tttt uecioGpubventas +++= Pr321 βββ ⎟ ⎟ ⎠ ⎞ ⎜ ⎜ ⎝ ⎛ = ⎟ ⎟ ⎟ ⎟ ⎟ ⎟ ⎟ ⎟ ⎟ ⎠ ⎞ ⎜ ⎜ ⎜ ⎜ ⎜ ⎜ ⎜ ⎜ ⎜ ⎝ ⎛ 135522 25053 1479 180 175 160 165 144 148 142 130 115 120 ⎟ ⎟ ⎠ ⎞ ⎜ ⎜ ⎝ ⎛ = ⎟ ⎟ ⎟ ⎟ ⎟ ⎟ ⎟ ⎟ ⎟ ⎠ ⎞ ⎜ ⎜ ⎜ ⎜ ⎜ ⎜ ⎜ ⎜ ⎜ ⎝ ⎛ ⎟ ⎟ ⎠ ⎞ ⎜ ⎜ ⎝ ⎛ =′ 8546514592923 145922977161 92316110 86241 90261 86221 88201 94161 92121 90141 95101 10291 10081 8690868894929095102100 242622201612141098 1111111111 XX ⎟ ⎟ ⎠ ⎞ ⎜ ⎜ ⎝ ⎛ =′ 8690868894929095102100 242622201612141098 1111111111 YX ⎟ ⎟ ⎠ ⎞ ⎜ ⎜ ⎝ ⎛ ⎟ ⎟ ⎠ ⎞ ⎜ ⎜ ⎝ ⎛ =′′= − − 135522 25053 1479 8546514592923 145922977161 92316110 )(ˆ 1 1 YXXXβ ⎟ ⎟ ⎟ ⎠ ⎞ ⎜ ⎜ ⎜ ⎝ ⎛ = ⎟ ⎟ ⎠ ⎞ ⎜ ⎜ ⎝ ⎛ − = ⎟ ⎟ ⎠ ⎞ ⎜ ⎜ ⎝ ⎛ ⎟ ⎟ ⎠ ⎞ ⎜ ⎜ ⎝ ⎛ − − −− = 3 2 1 ˆ ˆ ˆ 46,1 20,2 57,247 135522 25053 1479 38492683398459 26832721291449 39845929144941502841 327464 1 β β β 46 4) Estimación MCO de los parámetros de posición Ejemplo: modelo estimado de las ventas de una empresa de aspiradores tttt uecioGpubventas ˆPr46,122,257,247 +−+= Interpretación de los resultados - Las ventas esperadas independientemente del precio y los gastos en publicidad son de 247,57 miles de euros - Si se incrementan los gastos en publicidad en mil euros, manteniendo el precio constante, las ventas se incrementan en 2,2 mil euros -Si se incrementa el precio en un euro, manteniendo los gastos en publicidad constantes, disminuirán las ventas en 1,46 mil euros E(ventas)= = 247,57 siendo Gpub = precio=01 ˆβ Δventas = *ΔGpub = 2,2*ΔGpub si ΔPrecio=02 ˆβ Δventas = *ΔPrecio = -1,46*ΔPrecio si Δgpub=03 ˆβ 47 4) Estimación MCO de los parámetros de posición Ejemplo: modelo estimado de las ventas de una empresa de aspiradores Dependent Variable: VENTAS Method: Least Squares Date: 03/08/06 Time: 13:19 Sample: 2001 2010 Included observations: 10 ======================================================== Variable Coefficient Std. Error t-Statistic Prob. ========================================================= C 247.5675 67.35953 3.675315 0.0079 PUBLICIDAD 2.203809 0.545412 4.040634 0.0049 PRECIO -1.464234 0.648685 -2.257233 0.0586 ============================================================= 48 5) Propiedades de los estimadores MCO de los parámetros de posición un vector de variables aleatoria A) Propiedad en muestras finitas Los estimadores MCO son ELIO, es decir, lineales, insesgados y óptimos (en el sentido de que cualquier otro estimador lineal e insesgado tiene una matriz de varianzas y covarianzas “mayor”) Teorema de Gauss Markov βˆ

- 13. 49 1) Linealidad de El estimador MCO de β es una función lineal de las observaciones de la variable endógena Y (Vble aleatoria) Si Y aumenta al doble, se multiplica por dos. YAYXXX ′=′′=β −1 )(ˆ βˆ βˆ A′ Es una matriz (kxT) de elementos constantes que cumple la siguiente propiedad: IXA =′ TkTkkk TT TT yayaya yayaya yayaya +++= +++= +++= ...ˆ ...ˆ ...ˆ 2211 22221212 12121111 β β β M 5) Propiedades de los estimadores MCO de los parámetros de posición 50 2) Insesgadez de UXXX UXXXXXXX UXXXXYXXX ′′+= ′′+′′= +′′=′′= − −− −− 1 11 11 )( )()( )()()(ˆ β β βββ=β)ˆ(E βˆ 5- Propiedades del estimador MCO Demostración )()(]ˆ[ 1 UEXXXE ′′+= − ββ ββ =⇒= ]ˆ[0)( EuEsi Supuestos utilizados -S5. Parámetros constantes -S7. Las variables explicativas son deterministas -S9. E(U)=0 Supuestos utilizados -S5. Parámetros constantes -S7. Las variables explicativas son deterministas -S9. E(U)=0 Sesgo = 0)ˆ( =− ββE 51 3) Óptimos: Mínima varianza [ ] 12 )())ˆ(ˆ))(ˆ(ˆ()ˆvar( − ′=′−−= XXEEE σβββββ Propiedades del estimador MCO Matriz de varianzas y covarianzas del estimador MCO Demostración: UXXX UXXX ′′=− ′′+= − − 1 1 )()ˆ( )(ˆ ββ ββ [ ] [ ] [ ] 1211 11 )()()( )()( )ˆ)(ˆ()ˆ( −−− −− ′=′′′′= ′′′′= ′−−= XXXXXUUEXXX XXXUUXXXE EVar σ βββββ Supuestos utilizados - Todos los utilizados anteriormente anteriores (S5, S6 , S9) + - S10. - S11. Supuestos utilizados - Todos los utilizados anteriormente anteriores (S5, S6 , S9) + - S10. - S11. i)var( 2 ∀= σiu ji0),cov( ≠∀=ji uu T 2 I)var( σ=U 52 3) Óptimos: desarrollo de la matriz de varianzas y covarianzas del estimador MCO 12 )()ˆvar( − ′= XXσβ 1 jh 2 hj 1 jj 2 j )XX()ˆ,ˆcov(y)XX()ˆvar( −− ′σ=ββ′σ=β Matriz de varianzas y covarinzas Propiedades del estimador MCO ⎟ ⎟ ⎟ ⎟ ⎠ ⎞ ⎜ ⎜ ⎜ ⎜ ⎝ ⎛ = )ˆvar()ˆ,ˆcov()ˆ,ˆcov( )ˆ,ˆcov()ˆvar()ˆ,ˆcov( )ˆ,ˆcov()ˆ,ˆcov()ˆvar( )ˆ( 21 2212 1211 kkk k k V βββββ βββββ βββββ β L MOMM L L

- 14. 53 3) Optimalidad de Mejor: mínima varianza En el sentido de que cualquier otro estimador lineal e insesgado tiene una matriz de varianzas y covarianzas “mayor” βˆ CY=β~ [ ] CVarVar =− )ˆ() ~ ( ββ C es una matriz semidefinida positiva Propiedades del estimador MCO ββ =] ~ [EDado cualquier tal que Se cumple que: Demostración 54 Demostración Dado que las estimaciones de los parámetros β por MCO son una combinación lineal de las perturbaciones y las perturbaciones son Normales, entonces las estimaciones se distribuyen como Normales Propiedades del estimador MCO 4- Distribuciones de los estimadores MCO ( )12 )(ˆ − ′,Ν XXσββ ∼ Supuestos utilizados - S5.- Parámetros constantes - S7.- Variables explicativas son deterministas - S9+S10+S11+S12. Supuestos utilizados - S5.- Parámetros constantes - S7.- Variables explicativas son deterministas - S9+S10+S11+S12. )IN(0, T 2 σU ∼UA UXXX ′+= ′′+= − β ββ )(ˆ 1 55 Densidad )ˆ( if β iii EE βββ == )~()ˆ( iβˆ )ˆ( if β )~( if β )ˆ( if β )ˆ( if β Densidad iiE ββ =)ˆ( iβˆ Insesgadez Eficiencia Propiedades del estimador MCO Interpretación gráfica de las propiedades Por tanto, β es un vector determinista, pero su estimador por MCO es un vector de variables aleatorias normales, centradas en el valor que se quiere estimar. La insesgadez significa que esta muestra probablemente saldrá del entorno del centro de la distribución, que coincide con el verdadero valor. βˆ 56 CAT.1 Variables explicativas y residuos ortogonales entre si 6. PROPIEDADES ALGEBRAICAS DE LA ESTIMACIÓN MCO 0ˆ0)ˆ( =′⇒=−′ uXYYX 0ˆˆˆˆ ==′ UXUY β Demostración: Se deriva del sistema de ecuaciones normales CAR.2- La variable endógena estimada es ortogonal al residuo 0ˆ =′−′ βXXYX 0)ˆ( =−′ βXYX ∑ =⇒=′ 0uˆYˆ0uˆYˆ ii

- 15. 57 CAR.3. La suma de los residuos MCO es igual a cero: Si en el modelo hay término constante ⎟ ⎟ ⎟ ⎠ ⎞ ⎜ ⎜ ⎜ ⎝ ⎛ = ⎟ ⎟ ⎟ ⎟ ⎠ ⎞ ⎜ ⎜ ⎜ ⎜ ⎝ ⎛ = ⎟⎟ ⎟ ⎟ ⎠ ⎞ ⎜⎜ ⎜ ⎜ ⎝ ⎛ ⎟ ⎟ ⎟ ⎠ ⎞ ⎜ ⎜ ⎜ ⎝ ⎛ =′ ∑ ∑ ∑ 0 0 0 ˆ ˆ ˆ ˆ ˆ ˆ111 UˆX 22 1 21 22221 MMM K MOMM L L iki ii i TkTkk T ux ux u u u u xxx xxx 0ˆ =∑ iu CAR.4. La media de las variables (endógena estima) y endógena es la misma 0ˆ)ˆ(ˆ =−=−= ∑ ∑∑∑ iiiii yyyyu YYyy ii ˆˆ =⇒=∑ ∑ 6. PROPIEDADES ALGEBRAICAS DE LA ESTIMACIÓN MCO 58 CAR.5. Los residuos son combinación lineal de las perturbaciones aleatorias En todos los casos MUUXXXXXUX XUXXYU =′′−−+= −+=−= −1 )( ˆ)(ˆˆ ββ βββ UXXX ′′+= −1 )(ˆ ββ Demostración MUU =ˆ XXXXIM ′′−= −1 )( Simétrica Idempotente Semi-D.P. CAR.6. Los residuos son combinación lineal de v. endógena MYU =ˆ MYYXXXXYXYU =′′−=−= −1 )(ˆˆ β YXXX ′′= −1 )(ˆβDemostración 6. PROPIEDADES ALGEBRAICAS DE LA ESTIMACIÓN MCO 59 CAR.7 Los residuos se distribuyen En todos los casos ),0( 2 MN σ 6. PROPIEDADES ALGEBRAICAS DE LA ESTIMACIÓN MCO 60 Nota- calculo de la suma de los cuadrados de los residuos YXYYXYXYUUuSR i ′′−′=−′−=′′== ∑ βββ ˆ)ˆ()ˆ(ˆˆ 2 βββββ ˆˆ)ˆˆ(ˆˆ XXYYUXXYYYXYYSR ′′−′=+′′−′=′′−′= YYYYXXYYSR ˆˆˆˆ ′−′=′′−′= ββ βˆˆ XY = 0ˆ =′UX CAR .8 MYYMUUUUSR ′=′=′= ˆˆ Demostración MUUMUMUUUMUU ′=′′=′⇒= ˆˆˆ MYYMYMYUUMYU ′=′′=′⇒= ˆˆˆ 6. PROPIEDADES ALGEBRAICAS DE LA ESTIMACIÓN MCO

- 16. 61 22222 2222 ˆˆ'ˆˆ)ˆˆ( ')( YTYXYTYYYTYYySE YTYYYTYYyST ii ii −′′=−=−=−= −=−=−= ∑∑ ∑∑ β Con T. const YY =ˆ CAR 9. Si el modelo de regresión tiene término constante, entonces se cumple que: ST=SE+SR Demostración YYYYUUSR ˆˆˆ ′−′=′′= ˆˆˆˆˆˆ 22 YTYYUUYTYYYYUUYY −′+′′=−′⇒′+′′=′ Definiciones Restanto 2 YT 6. PROPIEDADES ALGEBRAICAS DE LA ESTIMACIÓN MCO 62 7) Estimación del parámetro de dispersión y propiedades 7-1) Estimación kT SR kT UU kT u u i i − = − ′ = − == ∑ ˆˆˆ ˆ)var( 2 2 σ kT MYY kT MUU kT YXYY − ′ = − ′ = − ′−′ = β σ ˆ ˆ 2 63 7-2) Propiedades A. En muestras finitas: 1) Insesgado [ ] [ ] [ ] [ ] [ ] )()()()( )()()()ˆˆ( 222 kTMtrIMtrUUMEtr UMUEtrUMUtrEMUUtrEMUUEuuE T −===′= ′=′=′=′=′ σσσ 22 ˆˆ )ˆ( σσ =⎥ ⎦ ⎤ ⎢ ⎣ ⎡ − ′ = kT UU EE )( )(ˆˆ )ˆ( 2 kT MUUE kT MUU E kT UU EE − ′ =⎥⎦ ⎤ ⎢⎣ ⎡ − ′ =⎥ ⎦ ⎤ ⎢ ⎣ ⎡ − ′ =σ Propiedades de la traza - tr(escalar)=escalar - tr(AB)=tr(BA) - E[tr(A)]=tr(E[A]) - tr(In)=n kTItrItrXXXXtrItr XXXXtrItrXXXXItrMtr kTT TT −=−=′′−= ′′−=′′−= − −− )()())(()( ))(()())(()( 1 11 MUUSR ′= Demostración 64 2) No lineal 3) No ELIO kT MYY kT uu − ′ = − ′ =σ ˆˆ ˆ 2 7-2) PROPIEDADES DEL PRÁMETRO DE DISPERSIÓN A. EN MUESTRAS FINITAS:

- 17. 65 )I,0(NX N 2 σ≈),0(Nx 2 i σ≈ 2 2 r AXX χ σ ≈ ′ B. PROPIEDADE ASINTÓTICAS: Teorema: Sea X=(x1,x2,...,xN) un vector de N variables aleatorias normales independientes con media cero y varianza constante Además si tenemos una matriz A simétrica e idempotente de rango r 66 Aplicando este teorema a nuestro caso se obtiene: ),0( 2 TINU σ≈ 2 2 kT MUU −≈ ′ χ σ 2 2 ˆˆ kT UU −≈ ′ χ σ 2 kT2 2ˆ)kT( −χ≈ σ σ− A partir de los supuestos s10+s11+s12 kTMrango −=)( También tenemos una matriz M simétrica idempotente y de rango (T-k) XXXXIM ′′−= −1 )( Entonces, aplicando el teorema anterior obtendremos: Demostración: kT MUU kT UU − ′ = − ′ = ˆˆ ˆ 2 σ 2 ˆ)( σkTMUU −=′ 67 kT 2 )ˆvar( 4 2 − σ =σ -Asintóticamente insesgado -Consistente 0 kT 2 lim)var(lim 4 T 2 T = − σ =σ ∞→∞→ B. PROPIEDADE ASINTÓTICAS: Para demostrara la consistencia, tenemos que calcular primero la varianza: Demostración: 2 kT2 2ˆ)kT( −χ≈ σ σ− Propiedades de )(2)( )( 2 2 kTV kTE kT kT −= −= − − χ χ )(2)ˆvar( )(ˆ)( var 2 4 2 2 2 kT kTkT −= − =⎟⎟ ⎠ ⎞ ⎜⎜ ⎝ ⎛ − σ σσ σ 68 A modo de resumen, concluimos que el estimador MCO de σ2 es asintóticamente insegado y consistente, si bien por lo que respecta a las propiedades para muestras finitas solamente podemos afirmar que es un estimador insesgado

- 18. 69 Finalmente sustituyendo por su estimador obtenemos los estimadores de las varianzas y covarianzas de los estimadores MCO del vector β: 2 σ 2ˆσ 12 )(ˆ)ˆ(ˆ − ′= XXV σβ ⎪⎩ ⎪ ⎨ ⎧ ′== ′== ⇒ − − 12 ˆ,ˆ 122 ˆ )(ˆ)ˆ,ˆcov(ˆ )(ˆ)ˆvar(ˆ ijjiji jjj XX XXj σββσ σβσ ββ β Es un estimador insesgado 70 8- Estimación por Máxima Verosimilitud (MV) de los parámetros • El método de MV se basa en la función de verosimilitud de la muestra. • La función MV se define como la probabilidad de que se den las observaciones muestrales. • Intuitivamente viene a proporcionar la probabilidad de que para unos determinados parámetros de β y σ2 obtengamos una muestra en concreta. 71 8- Estimación por Máxima Verosimilitud (MV) de los parámetros • El método de MV consiste en encontrar aquellos valores de los parámetros que maximizan la función de verosimilitud, es decir la probabilidad conjunta de las observaciones de la variable endógena ),,,( 2 k21 σβββ K La función de verosimilitud se puede expresar: ),(),...,,( 2 21 σβ== fyyyfL T 72 • Sabemos que: • Por tanto la función de densidad conjunta del vector U será: • Recordar que: U = Y-Xβ ),0( 2 TIN σU∼ ( ) ⎭ ⎬ ⎫ ⎩ ⎨ ⎧ ′ σ − πσ = UUUf T 22/2 2 1 exp 2 1 )( La estimación MV Requiere distribución del error (1)

- 19. 73 En la función de verosimilitud (1) sustituyendo el vector U como función de las variables observables obtenemos la función de verosimilitud de la muestra Y: ( ) ⎭ ⎬ ⎫ ⎩ ⎨ ⎧ β−′β− σ − πσ =σβ= XYXYYfL T ()( 2 1 exp 2 1 ),|( 22/2 2 Los parámetros que maximizan L son los mismos que maximizan Lln=l )()( 2 1 )ln( 2 )2ln( 2 ln 2 2 ββ σ σπ XYXY TT L −′−−−−==l Maximizamos lnL con respecto a β y σ2 )2( 2 1 )ln( 2 )2ln( 2 ln 2 2 β′β′+β′− σ −σ−π−== XXXYYY TT Ll 74 [ ] )()( 2 1 2 )(2 2 1 422 2 β−′β− σ + σ −= σ∂ ∂ β−′− σ −= β∂ ∂ XYXY T XYX l l Igualando a cero (1 y 2) y llamamos los estimadores máxima verosimilitud de los parámetros, obtenemos 2~y ~ σβ 2~~~~ 2 ~ σ=β′β′+′β′−′ β′=′ TXXYXYY XXYX 1 2 3 4 YXXX ′′=β −1 )( ~ A partir de 3 y 4 la estimación MV de T XXYXYY β′β′+′β−′ =σ ~~~ 2~2 β=β ˆ~ T uu ˆˆ′ = kT uu − ′ =σ ˆˆ ˆ 2 22 ~ˆ σ≠σ Condiciones de primer orden UXYYYU ˆ~~~ =−=−= β 75 Propiedad de los estimadores MV de los parámetros de posición Dado que los estimadores MV de β son iguales a los MCO, cumplen las mismas propiedades Lineales Insesgados Óptimos ELIO Eficientes + Son los de menor varianza entre todos los estimadores insesgados Su varianza alcanza el límite inferior de la Cota de Cramer-Rao 76 Propiedad del estimadores MV del parámetros de dispersión 1) Para muestras pequeñas No ELIO T k T kT T uuE E 2 2 2 2 )()ˆˆ( )~( σ −σ= −σ = ′ =σ -No lineal: - Sesgado: Sesgo negativo: MV infraestima el parámetro de dispersión T MYY′ =2~σ T k ESesgo 2 222 )~()~( σ σσσ −=−=

- 20. 77 Propiedad del estimadores MV del parámetros de dispersión 2) Propiedad asintóticas a) Insesgadez asintótica 22 )~(lim σσ = ∞→ E T b) Consistencia 2 4 2 )(2 )~var( T kT σ− =σ 0 )(2 lim)~var(lim 2 4 2 = σ− =σ ∞→∞→ T kT TT Recordar Bajo el supuesto de normalidad 2 k-T2 χ σ MUU′ Propiedades de )(2)( )( 2 2 kTV kTE kT kT − −= − − χ χ ∼ 78 Análisis de la eficiencia de los estimadores MV:Cota de Cramer-Rao Para obtener la desigualdad de Cramer-Rao, partimos de la Matriz de Información, que el caso del MLG será ⎟ ⎟ ⎟ ⎟ ⎠ ⎞ ⎜ ⎜ ⎜ ⎜ ⎝ ⎛ σ∂σ∂ ∂ σ∂β∂ ∂ σ∂β∂ ∂ β′∂β∂ ∂ −= 22 2 2 2 2 22 lnln lnln LL LL EMI Cota CR:menor varianza que pueda tener un estimador insesgado 79 A partir de las expresiones de las primeras derivadas de la lnL, obtenemos las segundas derivas: 24 22 ln ) σσ σ ββ XXXXL a ′ −= ′ −= ′∂∂ ∂ = −′ −= ∂∂ ∂ 42 2 )(ln ) σ β σβ XYXL b 6 2 6422 2 2 2 )()( 1 2 ln ) σ σ ββ σσσσ UUT XYXY TL c ′− = −′−−= ∂∂ ∂ 80 Aplicando la esperanza a cada uno de estos elementos (a,b y c): 2 1 2 )( σTuEUUE T i i =⎟ ⎠ ⎞ ⎜ ⎝ ⎛ =′ ∑= 22 )() σσ XXXX Ea ′ −= ′ − 0 )()( E) 444 = ′ −=⎥⎦ ⎤ ⎢⎣ ⎡ ′ −=⎥⎦ ⎤ ⎢⎣ ⎡ −′ − σσσ β UEXUX E XYX b 46 22 6 2 6 2 22 2 2 )(2 2 2 E) σσ σσ σ σ σ σ TTTUUETUUT c − = − = ′− =⎥ ⎦ ⎤ ⎢ ⎣ ⎡ ′− Demostración

- 21. 81 Obtenemos la matriz de información: ⎟⎟ ⎟ ⎟ ⎠ ⎞ ⎜⎜ ⎜ ⎜ ⎝ ⎛ σ σ ′ = 4 2 2 0 0 T XX MI La cota de C-R es la inversa de la matriz de información: ⎟⎟ ⎟ ⎠ ⎞ ⎜⎜ ⎜ ⎝ ⎛ ′ == − − T XX MICR 4 12 1 2 0 0)( σ σ 82 Denominamos ahora: )( 2 )()( 2 4 12 σ σ βσ CR T CRXX = =′ − - Eficiencia del estimador de β Tanto los estimadores MV como MCO tienen la varianza mínima que puede alcanzar un estimador insesgado de : 12 )()()~()ˆ( − ′=== XXCRVV σβββ Eficiencia del estimador de σ2 )( )(2 )~var( 2 2 4 2 σ σ σ CR T kT < − = )( )( 2 )ˆvar( 2 4 2 σ σ σ CR kT > − = Menor que la cota de Cramer- Rao, pero es sesgado 83 Resumen • Estimación MV • Estimación MCO YXXX ′′=β −1 )( ~ YXXX ′′=β −1 )(ˆ β=β ˆ~ T UU ˆˆ~2 ′ =σ Lineales, Insesgados, Óptimos (ELIO) y eficientes Asintóticamente insesgados y Consistentes 22 ~ˆ σ≠σ No lineal, sesgado y no eficiente No lineal, Insesgado, no eficiente No ELIO Asintóticamente insesgados y Consistentes βˆ~ˆ XYY == UYYYYU ~~ˆˆ =−=−= kT UU − ′ = ˆˆ ˆ 2 σ 84 9. Mediad de ajuste: DESCOMPOSICIÓN DE LA VARIANZA: Si entre las variables explicativas se tiene un término constante, La variación muestral de la variable endógena (ST) se puede descomponer en la variación debida a la regresión (SE) (influencia de X2 , X 3 ,...,X k ) y en variación debida a los residuos (SR): ST=SE+SR

- 22. 85 EXPRESIONES: YXYYUUuSR YTYXYTYSE YTYYYTYST i i i ′β′−=′== −′β′=−= −=−= ∑ ∑ ∑ ˆ'ˆˆ ˆˆ ' 2 222 222 86 El coeficiente de determinación El coeficiente de determinación es una medida del poder explicativo (bondad de ajuste del modelo). En el MLG con término independiente el R2 puede calcularse: El mide el porcentaje de la variación de Y que puede atribuirse a las variaciones de todas las explicativas X. == ST SE R2 2 2 ' ˆ YTYY YTYX − −′β′ 2 2 ' ˆ 11 YTYY YXYY ST SR R − ′′−′ −=−= β R2 87 Yˆ 0yˆ0 i 2 i 2 =⇒ =⇒= ∑ Y R 0uˆ1 2 i 2 =⇒= ∑R El aumenta de valor al aumentar el número de regresores sean estos relevantes o no. Para eliminar este fenómeno se define el ajustado de grados de libertad” Características: 10 2 ≤≤ R R2 R2 88 El Coeficiente de determinación corregido )( 2 R 1/)( /ˆˆ 1 1/ / 1 2 2 −−′ −′ −= − − −= TYTYY KTuu TST KTSR R )1( 1 1 22 R KT T R − − − −=

- 23. 89 2) si k ↑ y las variables son muy explicativas SR ↓ T-k↓ SR T-k↓ 3) 4) si k=1 5) el puede tomar valores negativos ↓⇒↑ − − 2 R 1/ / TST kTSR Características 1) si k ↑ y las variables son pocas explica 22 RR ≤ 22 RR = 2 R ↑⇒↓ − − 2 R 1/ / TST kTSR