Este documento presenta una introducción a la psicometría en tres partes. La primera parte cubre los fundamentos de la medición en psicología, incluyendo la problemática de la medición psicológica, la clasificación de tests y una reseña histórica. La segunda parte describe normas técnicas como la confiabilidad, validez, interpretación de puntuaciones y construcción de tests. La tercera parte revisa las teorías clásicas y modernas de los tests psicológicos. El libro provee una guía básica pero completa

![Los autores ...................................................................................... 9

Prólogo, Prof. Livio Grasso ............................................................. 11

Prefacio ........................................................................................... 13

Primera Parte

Fundamentos de la medición en psicología

1. Problemática de la medición psicológica................................... 19

1.1. La medición en psicología ................................................. 19

1.2. Psicometría y tests psicológicos........................................ 21

1.3. Reseña histórica ................................................................ 28

2. Clasificación de los tests............................................................ 39

2.1. Tests de ejecución máxima: inteligencia, aptitudes

y habilidades...................................................................... 40

2.2. Tests de comportamiento típico: motivación,

actitudes y personalidad .................................................. 49

Segunda Parte

Normas técnicas

Introducción..................................................................................... 69

3. Confiabilidad.............................................................................. 71

3.1. Introducción....................................................................... 71

3.2. El concepto de confiabilidad en la teoría clásica

de los tests ......................................................................... 72

3.3. Principales factores que afectan la confiabilidad............. 76

3.4. Dimensiones de la confiabilidad ....................................... 80

Introducción a la psicometría / Silvia Tornimbeni...[et.al.]. - 1a ed. - Buenos Aires : Paidós,

2008.

288 p. ; 22x16 cm. (Evaluación Psicológica; 21085)

ISBN 978-950-12-6085-4

1. Psicología. 2. Psicometría.

CDD 153.9

Cubierta de Gustavo Macri

1ª edición, 2008

Queda rigurosamente prohibida, sin la autorización escrita de los titulares del

copyright, bajo las sanciones establecidas en las leyes, la reproducción parcial

o total de esta obra por cualquier medio o procedimiento, comprendidos la

reprografía y el tratamiento informático.

© 2008 de todas las ediciones

Editorial Paidós SAICF

Defensa 599, Buenos Aires

e-mail: difusion@areapaidos.com.ar

www.paidosargentina.com.ar

Queda hecho el depósito que previene la ley 11.723

Impreso en la Argentina. Printed in Argentina

Impreso en Primera Clase, California 1231, Ciudad de Buenos Aires

en febrero de 2008

Tirada: 3.000 ejemplares

ISBN: 978-950-12-6085-4

ÍNDICE](https://image.slidesharecdn.com/introduccionalapsicometria-220901190527-ec2ed264/85/INTRODUCCION_A_LA_PSICOMETRIA-pdf-3-320.jpg)

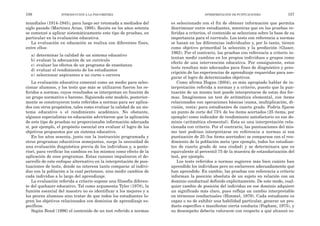

![Donde X e Y representan los pares ordenados de puntuacio-

nes correspondientes a la variable X y a la variable Y, y N es el

número total de casos examinados. En un estudio de estabili-

dad, por ejemplo, X equivale a la puntuación de un individuo

en la primera administración, Y a la puntuación del mismo in-

dividuo en la segunda administración y N el número total de

personas evaluadas en ambas administraciones. Como puede

verse en la fórmula, para el cálculo de este coeficiente trabaja-

mos con la sumatoria (∑

∑) de estas puntuaciones, no con los

puntajes individuales.

Cuando un coeficiente de correlación es utilizado para esti-

mar la estabilidad de las puntuaciones de un test, también sue-

le denominarse coeficiente de estabilidad.

A modo de ejemplo del método test-retest, describimos el es-

tudio de estabilidad realizado en la Escala de Inteligencia para

Niños de Wechsler. Se administró el test a una muestra de 353

niños de los Estados Unidos, de 6 a 15 años de edad, estando

representados ambos sexos y diferentes etnias. Se dejó transcu-

rrir un tiempo que osciló entre los 12 y los 63 días (con un in-

tervalo mediano de 23 días) y se aplicó nuevamente la prueba.

Se correlacionaron los puntajes con el coeficiente de Pearson

obteniéndose los siguientes resultados:

Tabla 3.1. Resultados de un estudio test-retest en el WISC III

Grupos de edad Escala completa Subtests de ejecución Subtests verbales

6-7 0, 92 0,86 0,90

10-11 0,95 0,88 0,94

14-15 0,94 0,87 0,94

De acuerdo con estos resultados, el WISC III evidencia una

adecuada estabilidad de sus puntuaciones en esta muestra (to-

dos los valores son superiores a 0,80).

Si bien la lógica del método test-retest es sencilla, su aplica-

ción presenta algunos inconvenientes. En primer lugar, casi

siempre es incómodo para los examinados someterse a un mis-

CONFIABILIDAD 83

cias. Por una parte es necesario administrar el instrumento a

una muestra según un diseño de investigación específico y, por

otro lado, los datos que resulten de tal aplicación deben ser

analizados mediante procedimientos apropiados para obtener

un estadístico que represente la confiabilidad de las puntuacio-

nes del test (Cortada de Kohan, 1999).

a) Test-retest:

Este método consiste en administrar un test en dos oportu-

nidades a la misma muestra de sujetos, con un determinado in-

tervalo entre las dos administraciones, y calcular la correlación

entre los puntajes obtenidos en la primera y segunda vez.

Como se explicó previamente, todos los métodos utilizados

para valorar la confiabilidad de un test se interesan por el gra-

do de consistencia entre dos conjuntos de puntuaciones obteni-

das independientemente, y por lo tanto pueden ser expresados

en función de un coeficiente de correlación que exprese el grado

de correspondencia o relación entre dos conjuntos de puntuacio-

nes (Anastasi y Urbina, 1998).

El coeficiente de correlación se expresa en un valor que varía

entre -1 y 1, donde 0 representa la ausencia total de correlación

entre los puntajes, 1 la correlación positiva perfecta (cuando

una variable aumenta la otra también lo hace en forma pro-

porcional) y -1 la correlación negativa perfecta (cuando una va-

riable aumenta la otra disminuye en forma proporcional). El

coeficiente más comúnmente utilizado es el de correlación mo-

mento-producto de Pearson, pero la elección del coeficiente a

utilizar depende del nivel de medición empleado por una prue-

ba (nominal, ordinal o intervalar, por ejemplo).

Una de las fórmulas para estimar el coeficiente de Pearson

(r) es:

82 INTRODUCCIÓN A LA PSICOMETRÍA

N x x N y y

. ( ) . ( )

2 2 2 2

∑ ∑ ∑

∑

−

[ ] −

[ ]

N xy x y

± ( ).( )

∑

∑ ∑

r =

√](https://image.slidesharecdn.com/introduccionalapsicometria-220901190527-ec2ed264/85/INTRODUCCION_A_LA_PSICOMETRIA-pdf-41-320.jpg)

![rrectas (en el caso de tests de ejecución máxima) o clave (en los

tests de respuesta típica) emitidas ante el mismo. Este supues-

to es muy controversial, puesto que si un test es “difícil” (sus

ítems son dificultosos) el examinado obtendrá un puntaje que

expresará “poca aptitud”, pero si un test que mide el mismo

rasgo es “fácil” (sus ítems son más fáciles) el mismo examinado

parecerá tener “mucha aptitud”, aunque posea el mismo nivel

de aptitud o rasgo. Consideremos dos individuos que responden

correctamente el 50% de los ítems de dos tests de inteligencia

que difieren en dificultad, ¿podrían ser calificados como igual-

mente inteligentes? Claramente, la respuesta es no. Por otra

parte, dos personas pueden responder correctamente al mismo

número de ítems en un test (y por consiguiente obtener el mis-

mo puntaje total) pero diferir en su aptitud. La persona que hu-

biese acertado los ítems más difíciles tendría un puntaje más

elevado en el rasgo latente que el individuo que hubiese acerta-

do el mismo número de ítems pero más fáciles.

Todas las fuentes potenciales de variabilidad (diferentes del

nivel real en el rasgo) de los puntajes se asumen constantes en

la TCT o bien tienen un efecto no sistemático (aleatorio). Sin

embargo, como afirmamos antes, los puntajes de dos tests cons-

truidos para medir el mismo rasgo suelen ser distintos aunque

se hayan estandarizado cuidadosamente. Esto se debe a que ca-

da test tiene su propio conjunto de ítems y cada ítem tiene dife-

rentes propiedades. En efecto, las propiedades de los ítems son

variables de error que evaden la estandarización del test en la

TCT.

La teoría clásica ha sido muy útil y aún continúa vigente,

coexistiendo con la TRI, pero se ha señalado que posee algunas

limitaciones importantes (Baker, 2001; Hambleton y Rogers,

1991; Muñiz, 2000; Embretson y Reise, 2000):

a) Las propiedades psicométricas de los ítems (por ejemplo,

los índices de dificultad y de discriminación) y del test en

su conjunto (confiabilidad y validez) dependen de las ca-

racterísticas de la muestra de estandarización del test.

b) El rendimiento de las personas en dos tests diferentes

que miden un mismo rasgo no es estrictamente compara-

ble (por ejemplo, si poseen ítems de diferente dificultad).

TEORÍA DE RESPUESTA AL ÍTEM 219

muchos los esfuerzos para desarrollar nuevas teorías y técnicas

que permitieran su identificación y estimación. Algunos de es-

tas teorías pueden considerarse extensiones y refinamientos de

la TCT (por ejemplo, la teoría de la generalizabilidad); sin em-

bargo, entre los años sesenta y la década de los ochenta, surge

y se consolida un nuevo modelo dentro del campo de la teoría

de los tests, la teoría de respuesta al ítem (TRI) que permite

superar algunos de los inconvenientes de la teoría clásica de los

tests (Van der Linden y Hambleton, 1997).

Los diferentes desarrollos de la TRI se deben fundamental-

mente a varias líneas de investigación independientes. Una de

ellas se desprende del texto clásico de Lord y Novick, Statisti-

cal theories of mental test scores [Teorías Estadísticas de los

Puntajes de los Tests Mentales], de 1968, comparable en su im-

pacto al texto de Gulliksen Theories of mental tests de los años

cincuenta. Por otra parte, el matemático danés Georg Rasch

desarrolló una serie de modelos teóricos TRI para tests de lec-

tura y para uso militar en la década del sesenta. Finalmente,

los avances en la informática posibilitaron la extensión y difu-

sión de los complejos cálculos requeridos en los diferentes pro-

cedimientos TRI.

En la actualidad, varios tests han sido construidos con méto-

dos de la TRI, tales como la batería psicoeducacional Woodcock-

Johnson, el test de aptitudes académicas (SAT), la batería de

aptitudes vocacionales de las fuerzas armadas (ASVAB) y la ac-

tual versión del test de inteligencia Stanford-Binet, todos men-

cionados en las páginas precedentes de este texto (Embretson y

Reise, 2000).

Como mencionamos repetidamente en este libro, la TCT se

apoya en un supuesto fundamental (O=V+E), según el cual la

puntuación empírica (observada) de una persona en un test es-

tá integrada por su puntuación verdadera en el rasgo medido

(inobservable) y el error de medición. A partir de este supuesto,

y otros adicionales, se deducen postulados que fundamentan las

estimaciones empíricas de la confiabilidad y validez de los tests,

así como los indicadores de las propiedades psicométricas de

sus ítems (índices de discriminación o dificultad, por ejemplo).

La TCT asume que la aptitud de un examinado se define en

términos de un test particular y en el número de respuestas co-

218 INTRODUCCIÓN A LA PSICOMETRÍA](https://image.slidesharecdn.com/introduccionalapsicometria-220901190527-ec2ed264/85/INTRODUCCION_A_LA_PSICOMETRIA-pdf-110-320.jpg)