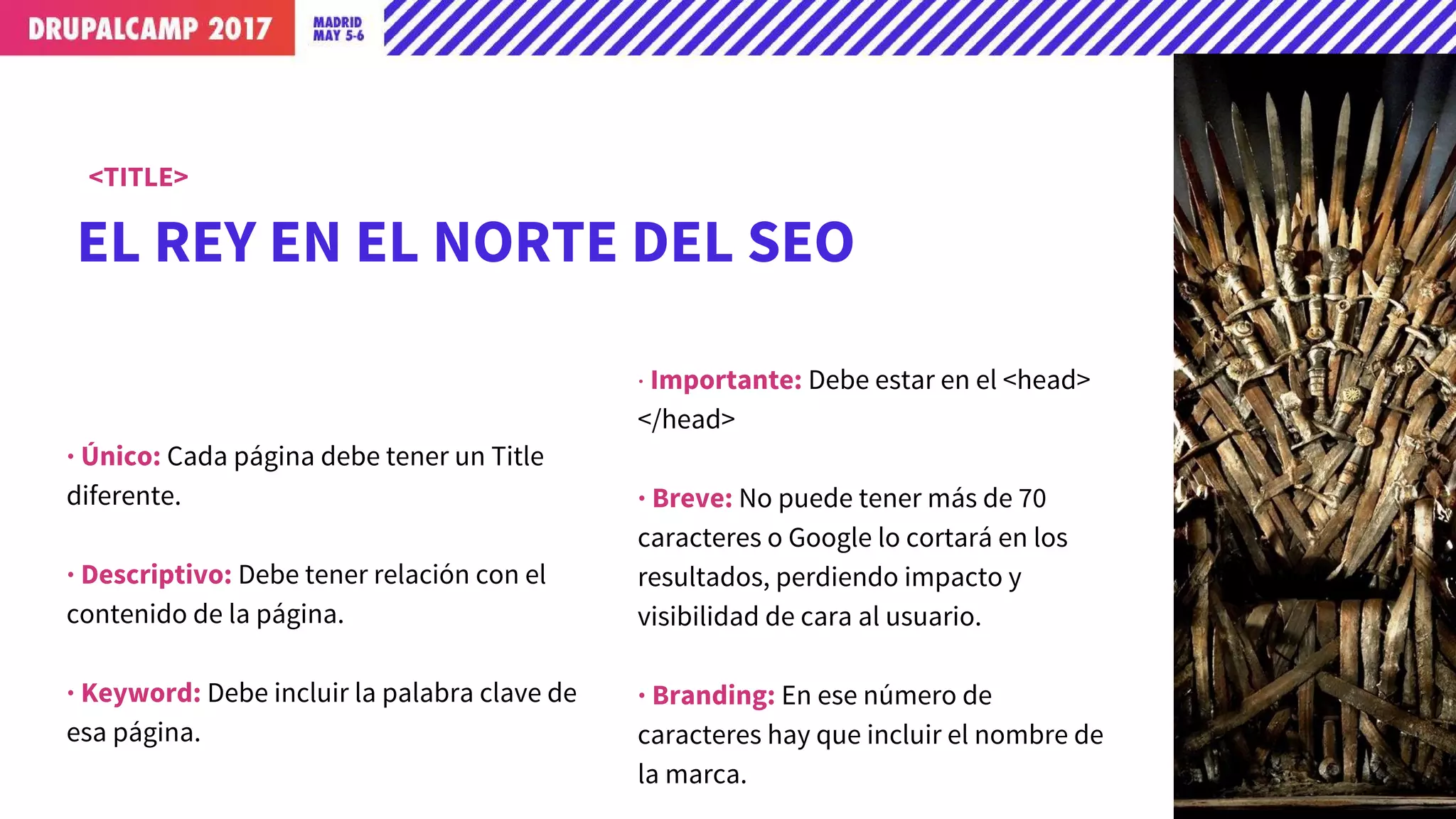

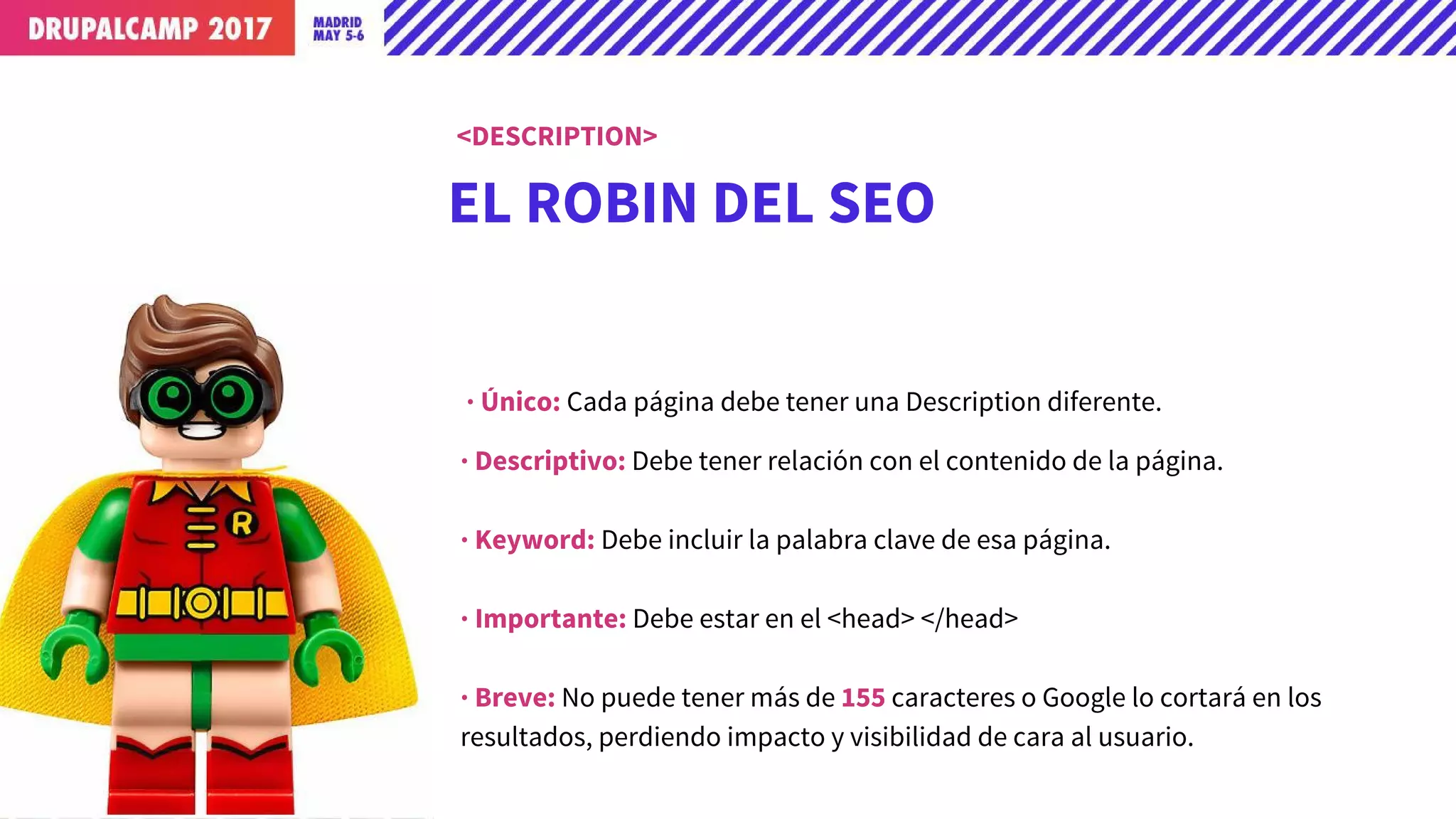

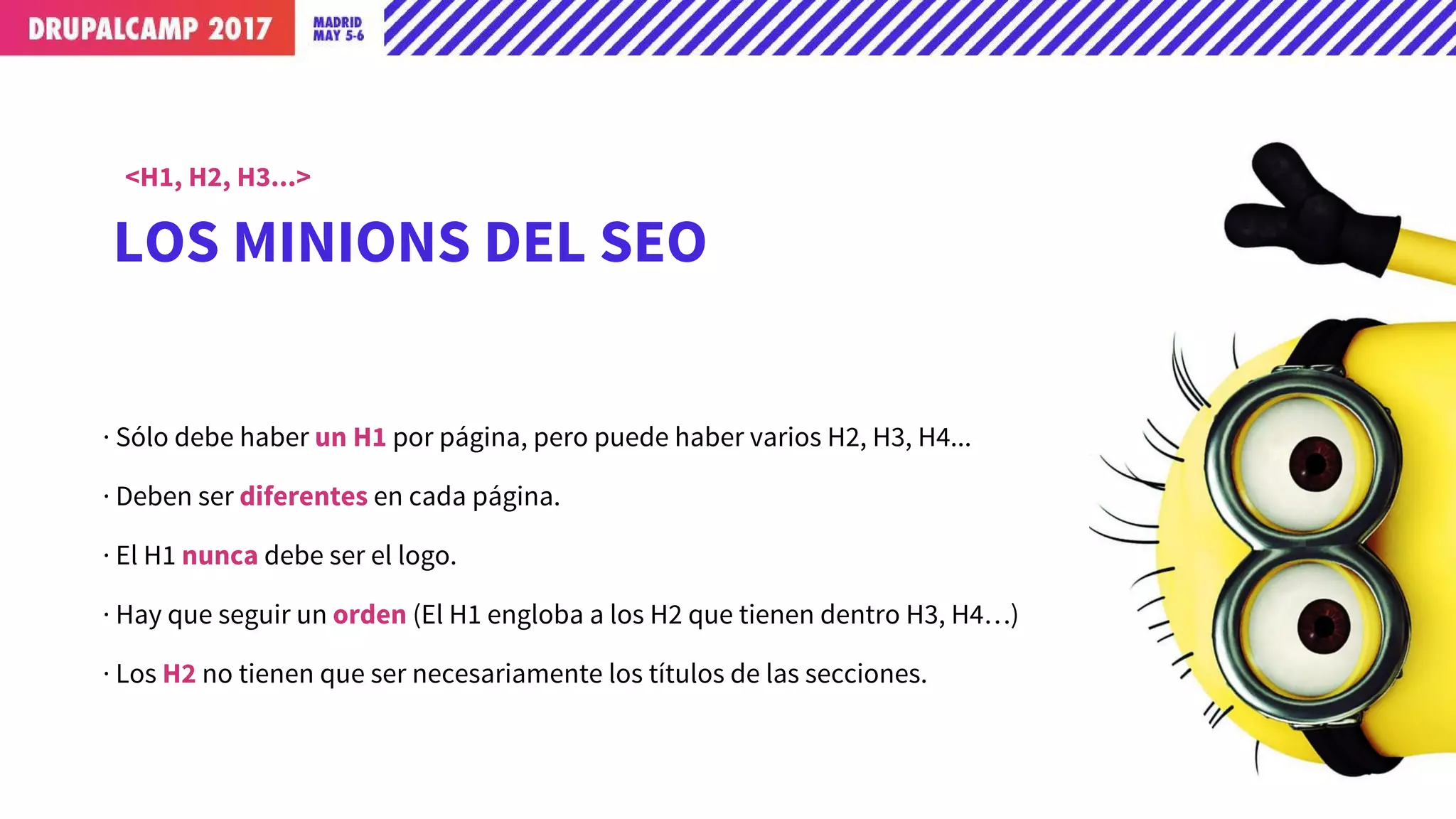

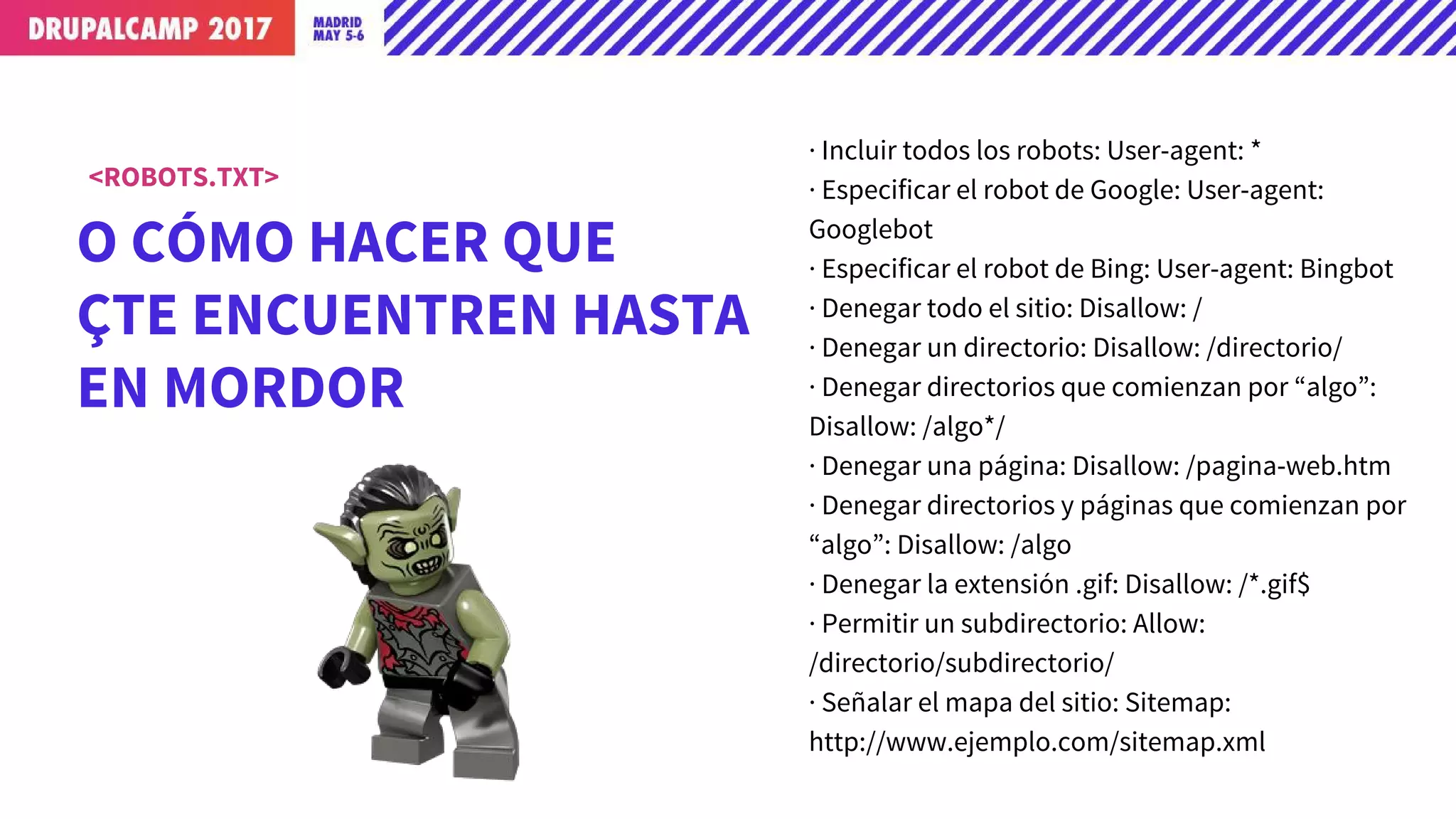

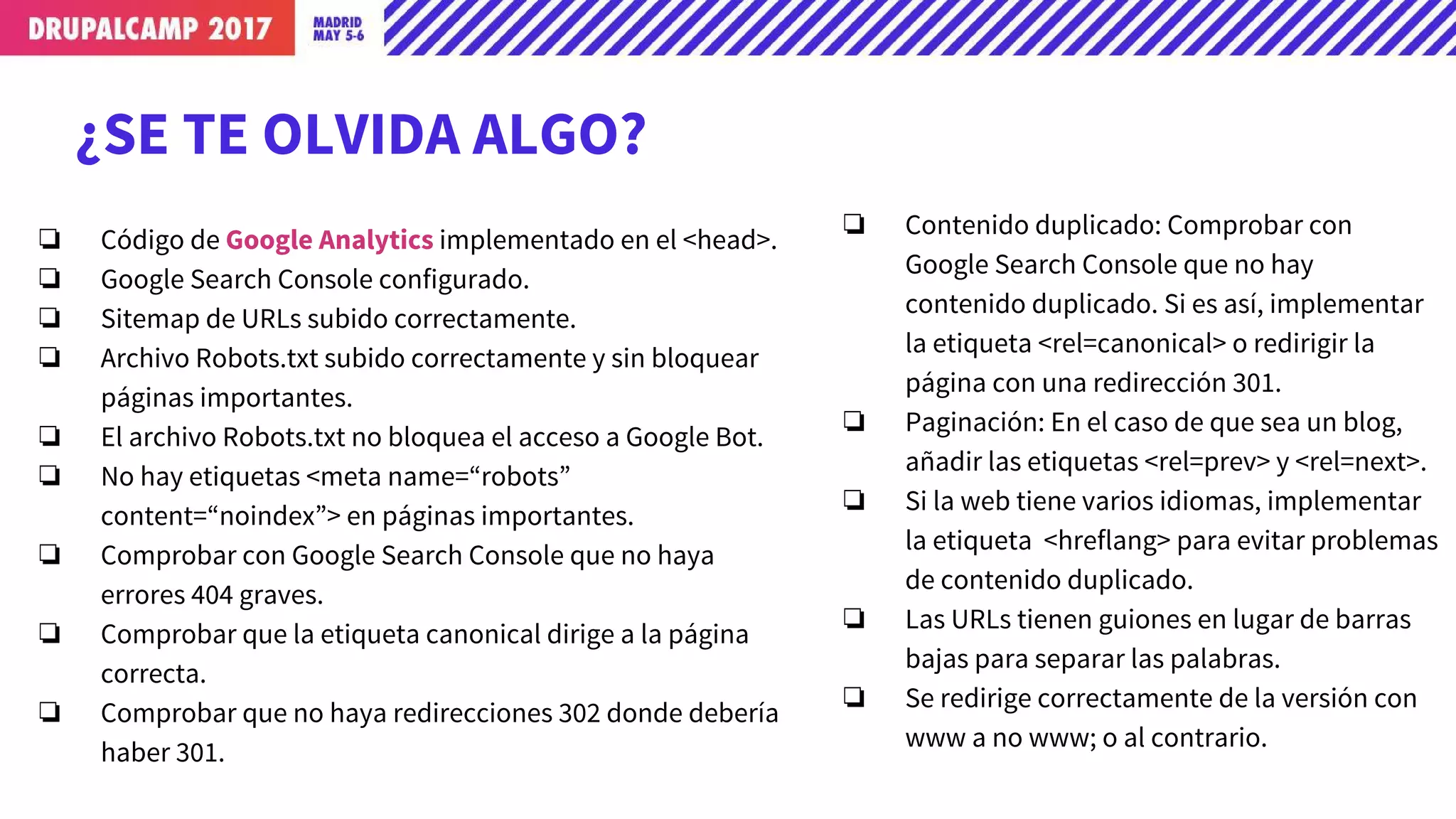

Este documento ofrece consejos sobre optimización para motores de búsqueda (SEO) durante el desarrollo de un sitio web con Drupal. Explica la importancia de implementar el archivo robots.txt, códigos únicos de Google Analytics para cada entorno, y optimizar elementos como el título, la descripción y los encabezados H1-Hn en cada página. También recomienda verificar las URLs, etiquetas, mapa del sitio y accesibilidad antes de pasar el sitio a producción.