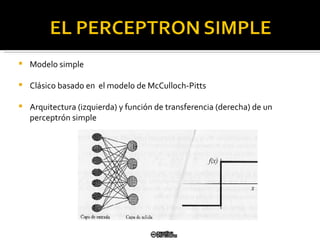

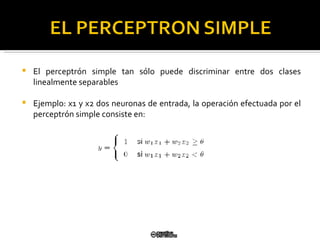

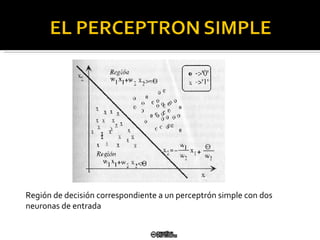

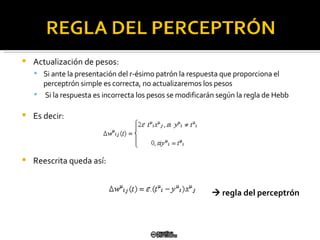

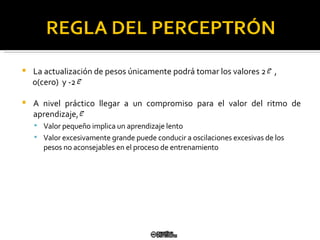

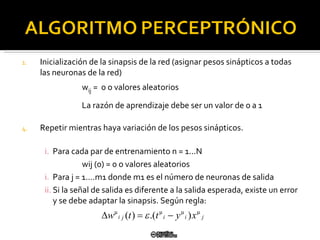

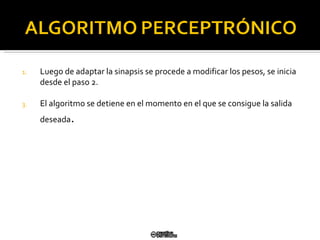

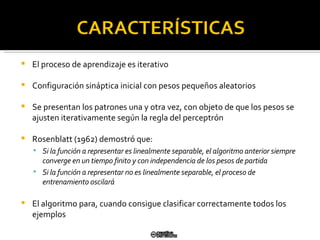

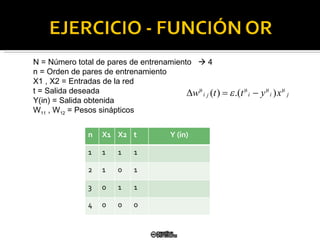

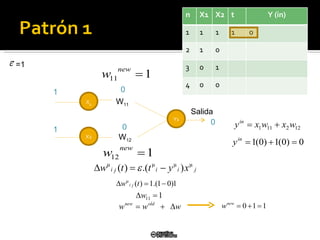

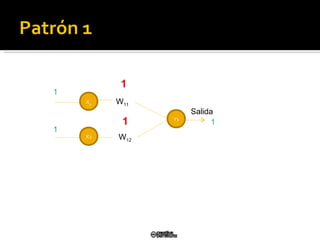

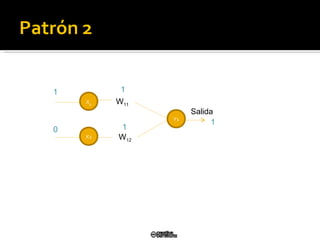

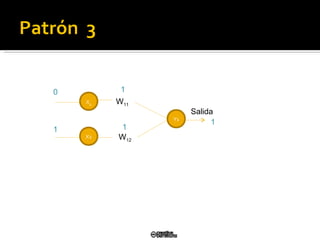

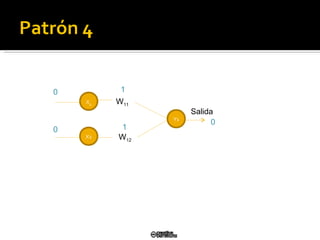

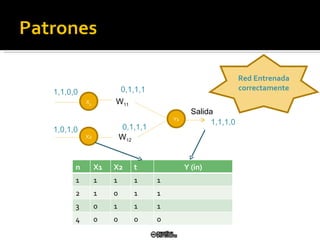

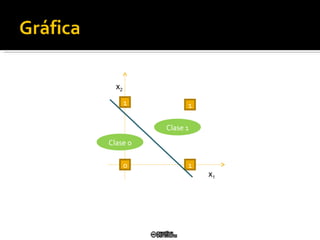

El documento describe el modelo de perceptrón simple desarrollado por Frank Rosenblatt en 1958. El perceptrón puede clasificar patrones de entrada de manera binaria (0/1) dependiendo de los pesos sinápticos. El algoritmo de aprendizaje actualiza los pesos para minimizar el error entre la salida del perceptrón y la salida deseada, convergiendo en un tiempo finito si los patrones son linealmente separables.

![Roberth Gustavo Figueroa Díaz -- Camilo Javier Solís Álvarez rgfigueroa@utpl.edu.ec -- [email_address] Universidad Técnica Particular de Loja Escuela de Ciencias de la Computación LOJA - ECUADOR](https://image.slidesharecdn.com/perceptron-simple-y-regla-aprendizaje4818/85/Perceptron-Simple-y-Regla-Aprendizaje-1-320.jpg)