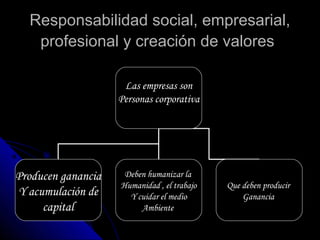

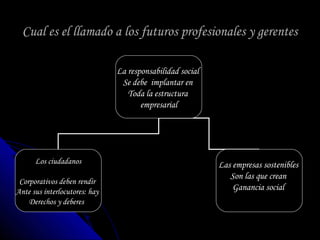

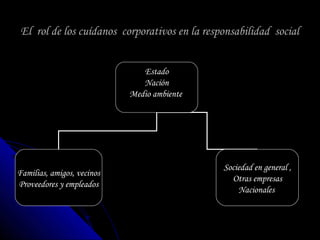

La responsabilidad social se refiere a la obligación de los individuos y grupos de asegurar que sus acciones tengan un impacto positivo en la sociedad y promuevan los derechos humanos. Las empresas, como ciudadanos corporativos dirigidos por profesionales, deben crear valor para la sociedad mediante la instauración de principios axiológicos y de dignidad humana, y responder a problemas sociales y ambientales creados por sus actividades económicas.