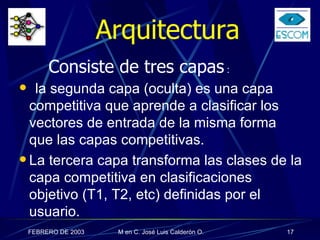

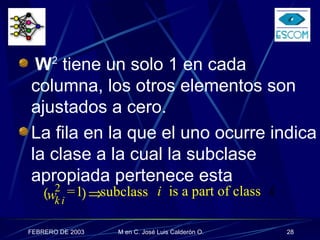

LVQ (Learning Vector Quantization) es un método de aprendizaje supervisado para capas competitivas. La red LVQ consiste en una capa competitiva oculta que aprende a clasificar vectores de entrada en subclases, y una capa lineal de salida que combina las subclases en clases objetivo definidas por el usuario. El algoritmo de aprendizaje actualiza los pesos de la neurona ganadora dependiendo de si su clasificación es correcta o no, moviéndolos hacia o alejándolos del vector de entrada respectivamente.

![Existen diferentes variantes al algoritmo básico de LVQ (LVQ1, LVQ2 y LVQ3). Las diferentes variantes de LVQ descritas en [ Kohonen , 1995 , McDermott , 1990 , Makino et al., 1992 ] las cuales tienen propiedades ligeramente diferentes.](https://image.slidesharecdn.com/1lvq-090922021344-phpapp01/85/Learning-Vector-Quantization-LVQ-47-320.jpg)

![Por ejemplo LVQ2 [ Kohonen et al., 1996b ], la cual es eficiente para sintonia fina de las fronteras de decisión entre las clases en competencia. LVQ3 [ Kohonen et al., 1996b ] la cual agrega un termino de estabilidad a LVQ2 para mejorar su comportamiento a largo plazo.](https://image.slidesharecdn.com/1lvq-090922021344-phpapp01/85/Learning-Vector-Quantization-LVQ-48-320.jpg)

![Sintaxis de initlvq [W1,W2] = initlvq (P,S1,T); donde: P es el vector de entradas T es el vector objetivo S1 es el numero de neuronas en la capa oculta.](https://image.slidesharecdn.com/1lvq-090922021344-phpapp01/85/Learning-Vector-Quantization-LVQ-52-320.jpg)

![Sintaxis trainlvq [W1,W2] = trainlvq(W1,W2,P,T,tp); donde: W1 es el peso de la capa competitiva W2 es el peso de la capa lineal P es el vector de entradas T es el vector de valores objetivo tp son parámetros de entrenamiento](https://image.slidesharecdn.com/1lvq-090922021344-phpapp01/85/Learning-Vector-Quantization-LVQ-54-320.jpg)

![Función simulvq Ejemplo: P= [-1 2 3 2 ...; 2 -1 1 -3 ...]; T= [0 0 0 1 ...; 1 1 1 0 ...]; [W,b]= initlvq (p,7,T); a= simulvq ([1; -1], W1, W2);](https://image.slidesharecdn.com/1lvq-090922021344-phpapp01/85/Learning-Vector-Quantization-LVQ-57-320.jpg)

![Código para el Ejemplo 1 P=[0 0 1 1; 0 1 0 1]; T=[1 0 0 1; 0 1 1 0]; [W1,W2]= initlvq(P,4,T); [W1,W2]= trainlvq(W1,W2,P,T,[10 100 0.5]); a = simulvq(P, W1,W2);](https://image.slidesharecdn.com/1lvq-090922021344-phpapp01/85/Learning-Vector-Quantization-LVQ-60-320.jpg)