El documento presenta el algoritmo EM (Expectation-Maximization) utilizado para estimar parámetros en modelos probabilísticos con variables no observables, explicando su funcionamiento a través de un proceso iterativo que alterna entre dos pasos. Se menciona el experimento Weldon-Pearson de 1894 como base histórica y se exploran aplicaciones de este algoritmo en la simulación de mixturas de distribuciones normales y gamma, así como en el ajuste de series de tiempo financieras. Finalmente, se discuten los resultados de diversas pruebas y ajustes estadísticos, destacando la evidencia sobre la consistencia de las hipótesis nulas en varios escenarios.

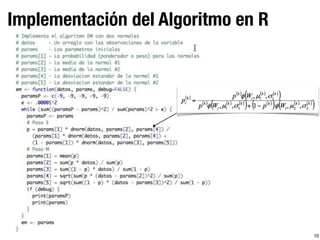

![Generalización

X- Muestra completa ~ f(x; θ)

Y - Muestra observada (incompleta) ~ f(y;θ) tal que y(x) = y

Se define Q(θ;θp) = E[lnf(x;θ)|Y, θp]

Se obtiene θp+1,

= 0

Se itera hasta que |θp+1 - θp| o |Q(θp+1;θp) - Q(θp;θp)| son

suficientemente pequeñas, es decir se obtienen valores óptimos

para Q(θ;θp) y θ

Se espera que la verosimilitud no decrezca en cada iteración

Q(θp+1;θp) ≥ Q(θp;θp)

9](https://image.slidesharecdn.com/algoritmo-em-160113021618/85/Algoritmo-EM-11-320.jpg)