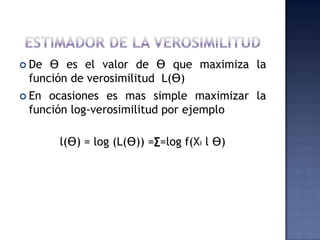

El documento detalla el método de máxima verosimilitud, introducido por Bernoulli y revisado por Euler, que se utiliza para estimar parámetros en modelos estadísticos maximizando la función de verosimilitud. Se discuten sus propiedades asintóticas, su relación con métodos de mínimos cuadrados y su aplicación en modelos lineales y análisis de datos. A pesar de su eficiencia, se señala que requiere tamaños de muestra grandes para evitar sesgos en las estimaciones.

![ Se tienen 2 maquinas distintas para producir un

producto.

En donde la maquina A produce el 60% de la

producción total y la maquina B produce el

restante 40%

Se determina la productividad de la maquina

según sus especificaciones

Producción

Maq. A PE[0,1] La probabilidad esta o pertenece

al intervalo cerrado de 0,1

producción 0

Maq.B

T0 T1](https://image.slidesharecdn.com/maxmaverosimilitud-130302080016-phpapp01/85/Maxima-verosimilitud-10-320.jpg)

![En muchos casos, el estimador obtenido por

máxima verosimilitud posee un conjunto de

propiedades asintóticas como son:

M1. Consistencia: Plim ƟML = Ɵ

M2. Normalidad asintótica: ƟML N[Ɵ, {I(Ɵ)} ]

siendo I(Ɵ)=-E[∂² ln L/ ∂Ɵ ∂ Ɵ’]

M3. Eficiencia Asintótica: ƟML es

asintóticamente eficiente y alcanza la cota

de Cramer-Rao para estimadores

consistentes, dada en M2

M4 Invarianza: El estimador de máxima

verosimilitud de y= c(Ɵ) es c (ƟML)](https://image.slidesharecdn.com/maxmaverosimilitud-130302080016-phpapp01/85/Maxima-verosimilitud-18-320.jpg)