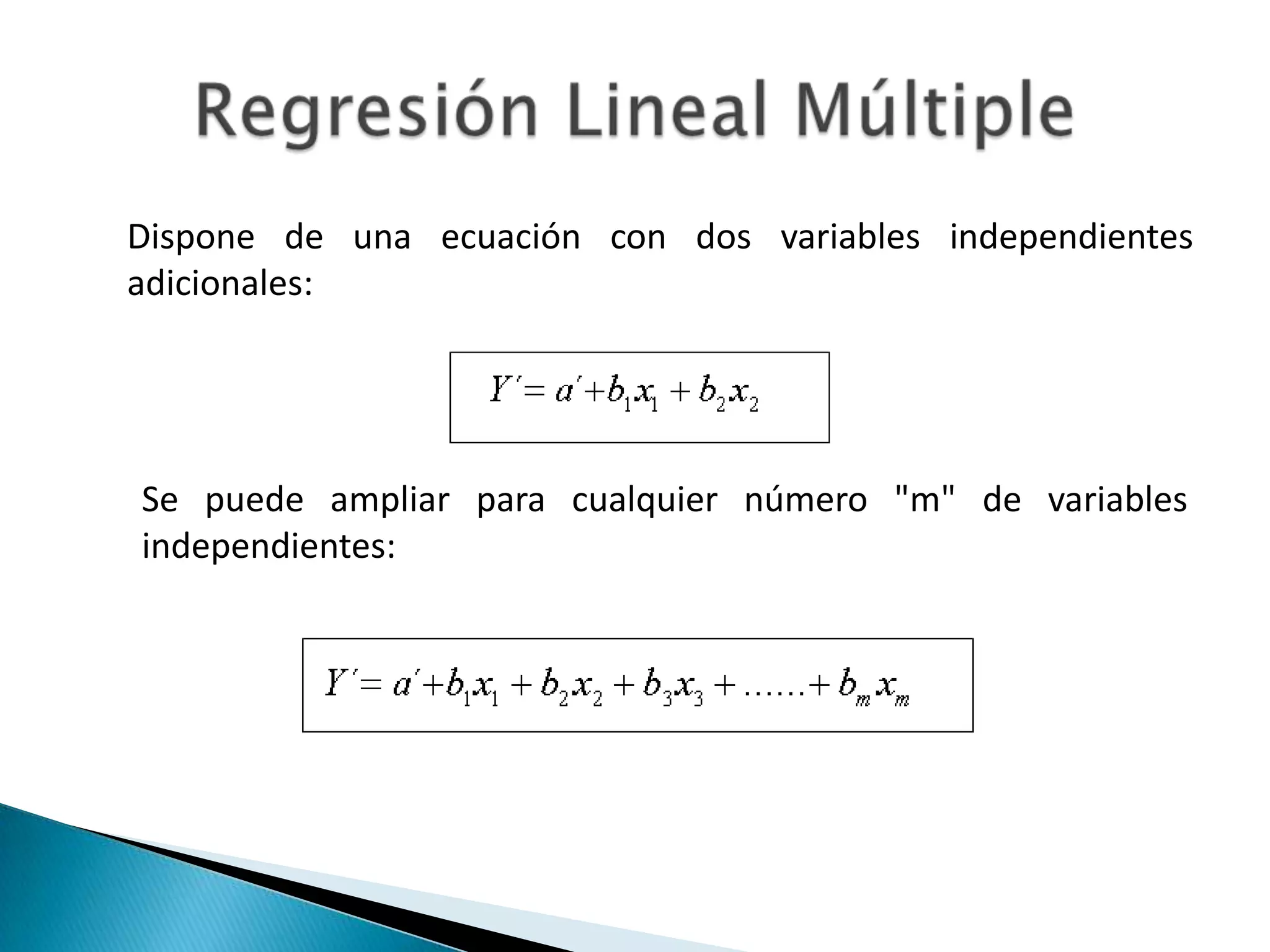

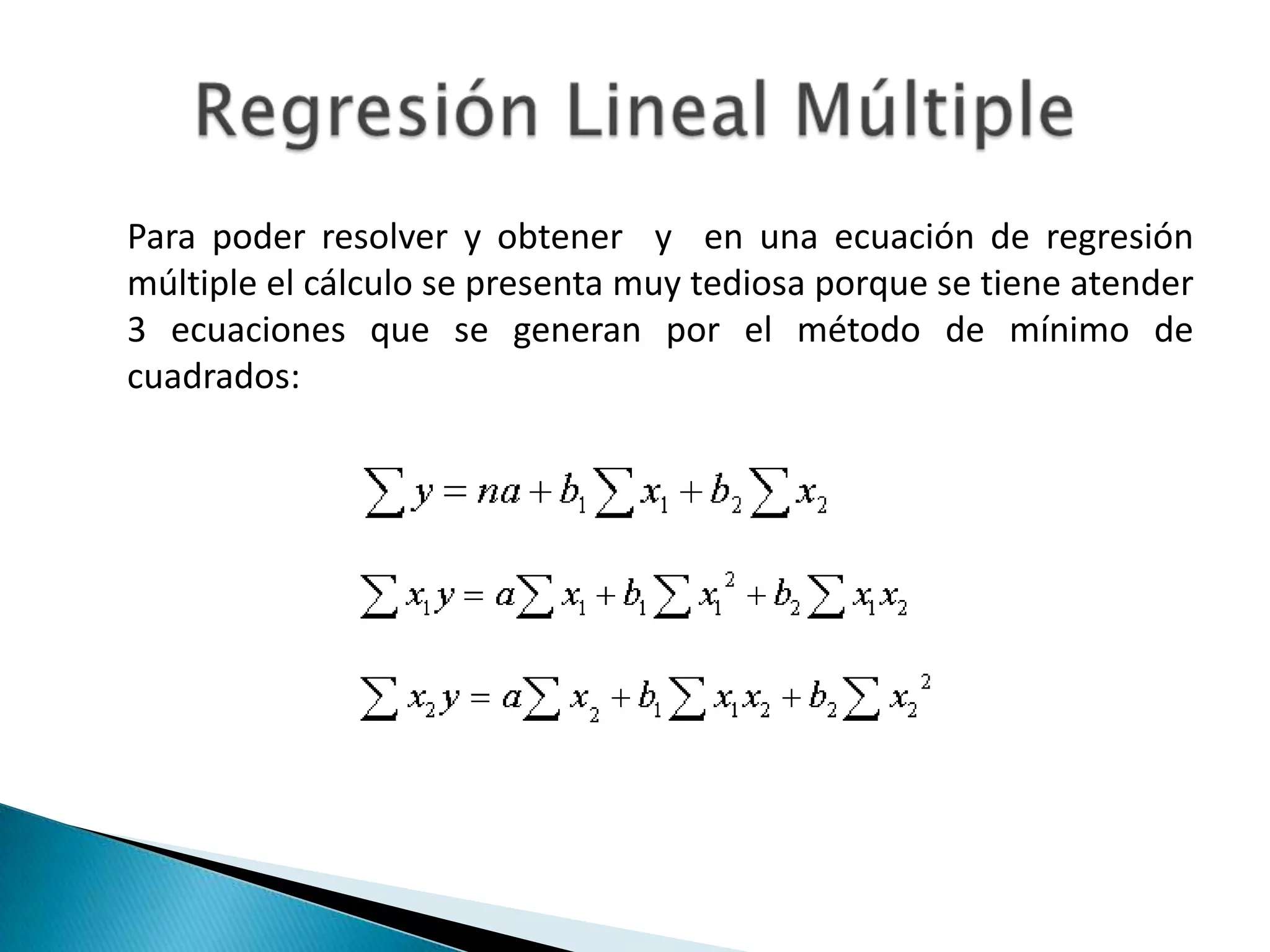

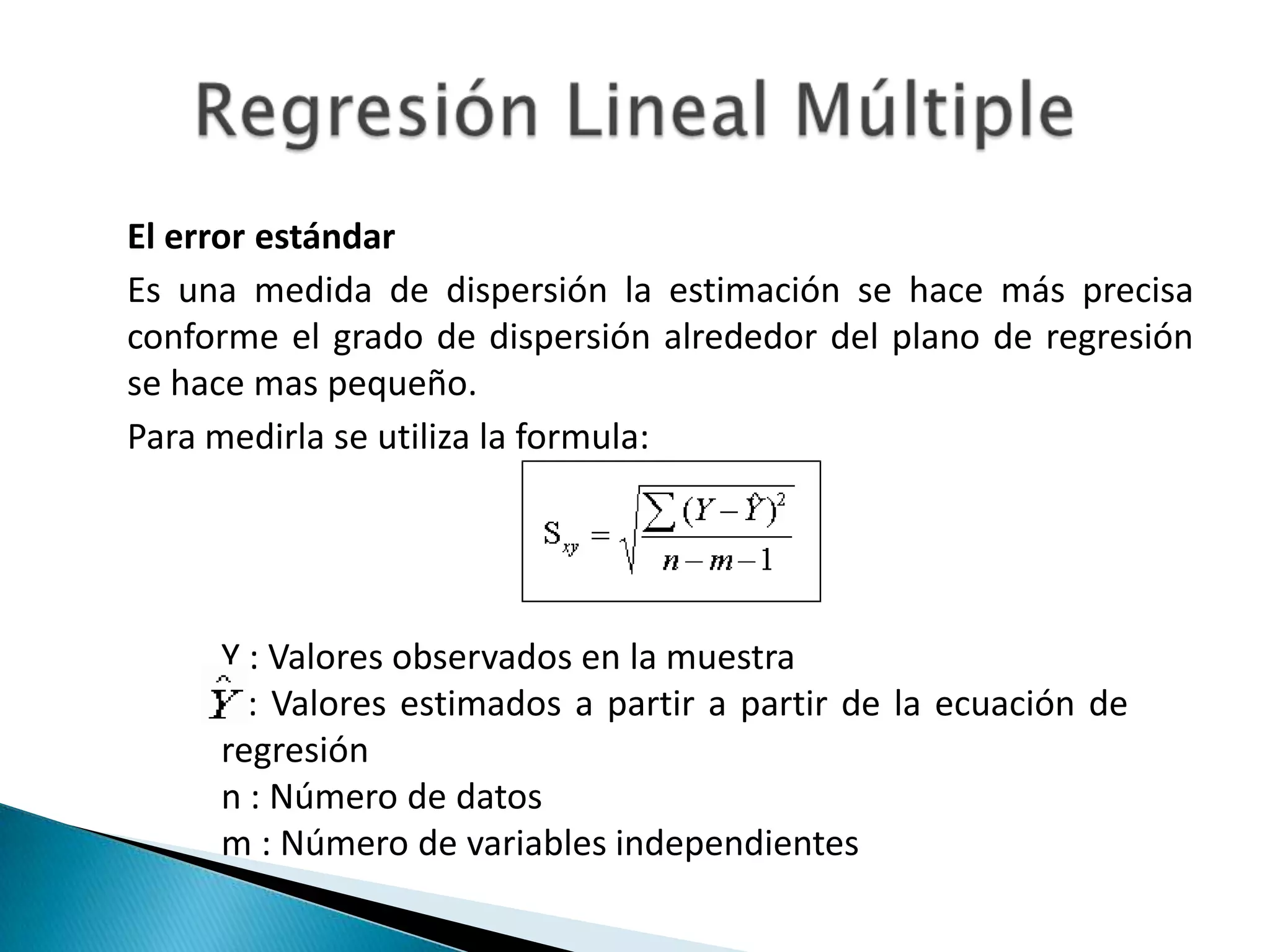

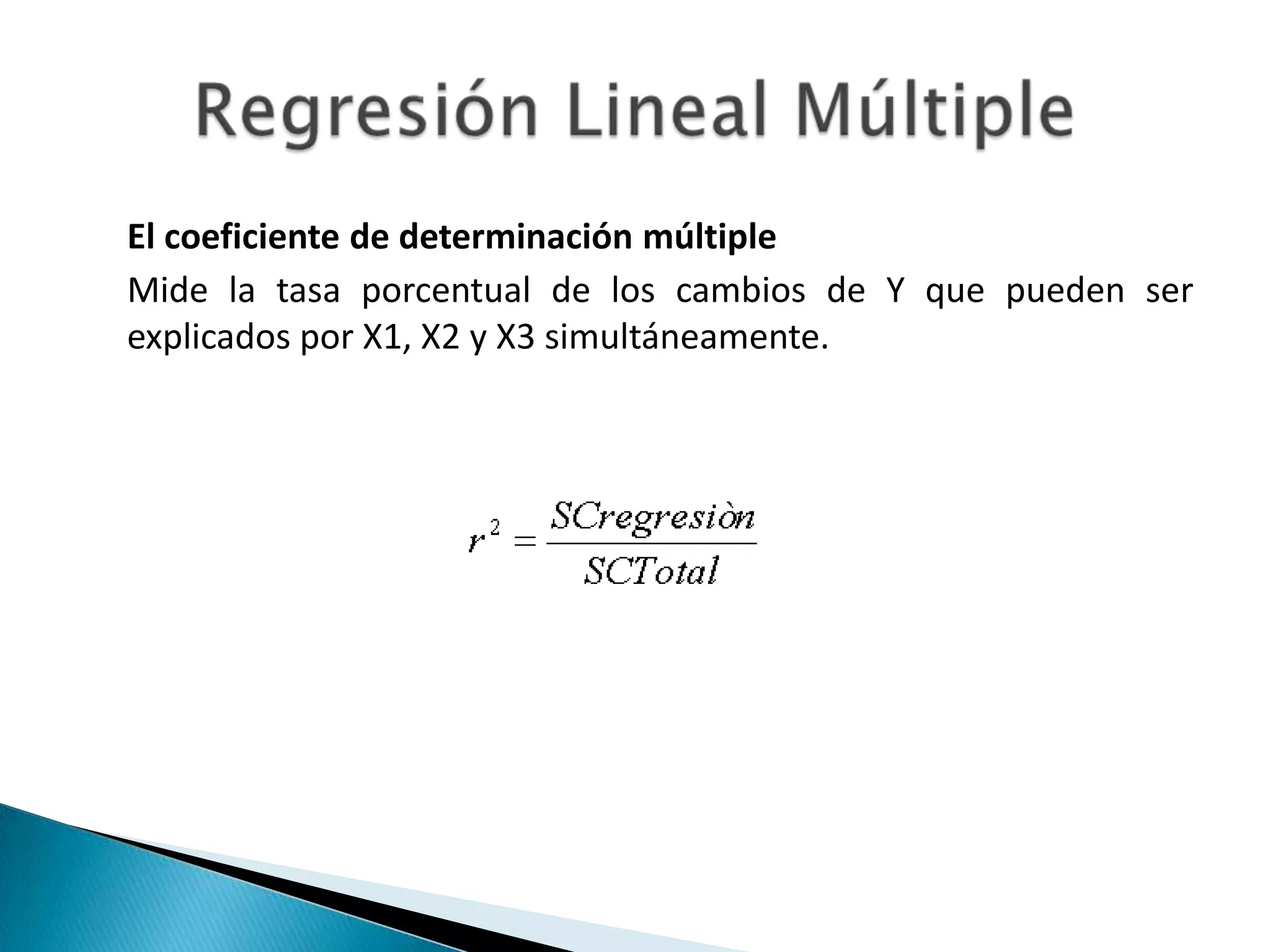

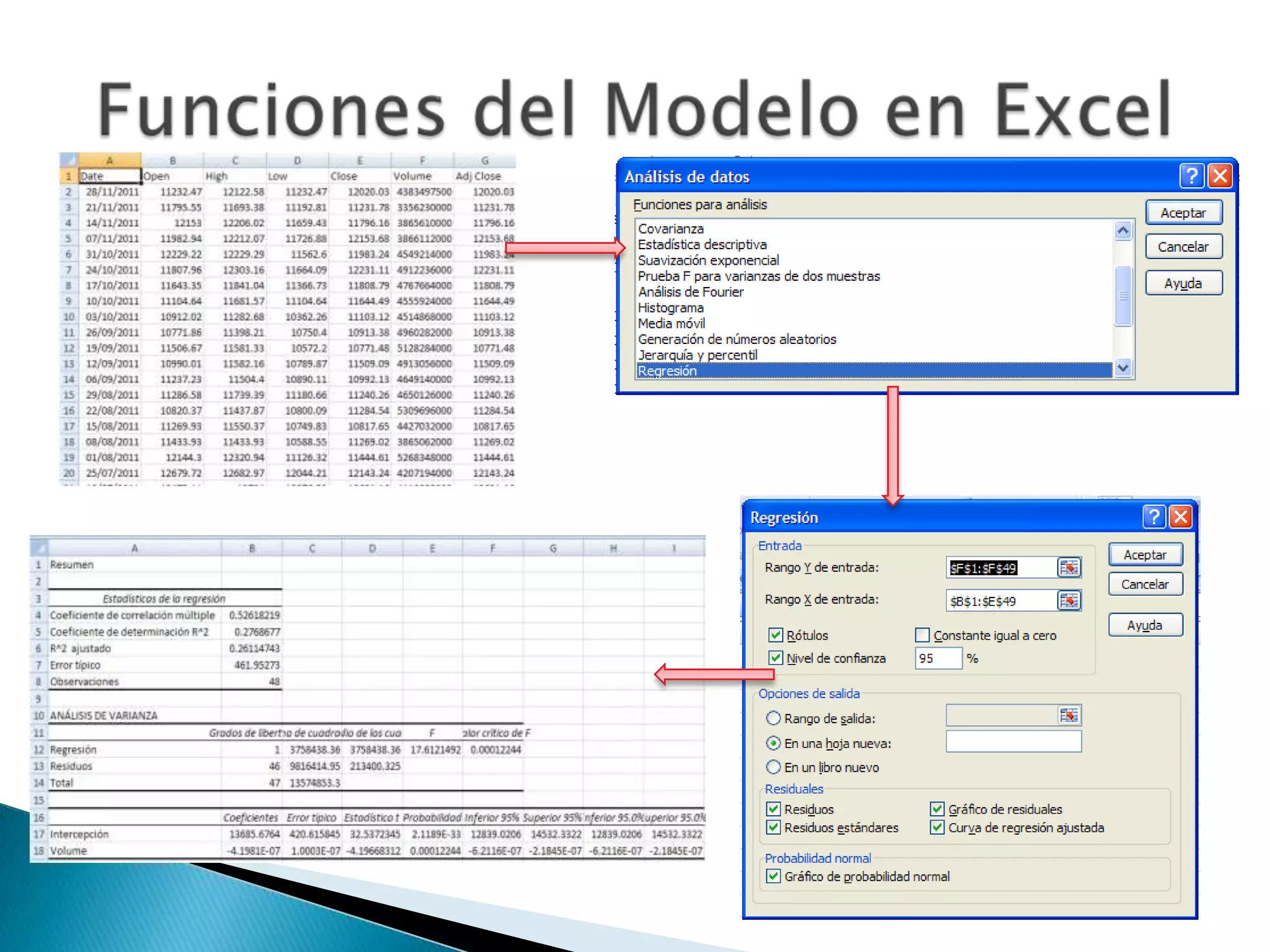

Este documento describe el análisis de regresión múltiple, incluyendo la ecuación de regresión múltiple y el error estándar múltiple de estimación. También cubre el coeficiente múltiple de determinación, las hipótesis de normalidad, homocedasticidad e independencia de errores, y cómo detectar cuando estas hipótesis no se cumplen. Finalmente, explica cómo predecir valores utilizando un modelo de regresión múltiple.