Este documento presenta un proyecto final sobre programación paralela para la Universidad Autónoma de Sinaloa. Explica brevemente conceptos de computación paralela y luego se enfoca en dos APIs para programación paralela: OpenMP y OpenMPI. Describe las características, historia, ejemplos y uso de OpenMP y OpenMPI para construir programas paralelos que aprovechen múltiples procesadores y núcleos.

![Proyecto Final

Uni versidad Autónoma de Sinaloa

2013

{

printf("Thread %d, contador %d n",iam,i);

}

}

}

Sección

#pragma omp parallel private(iam, np,i)

{

#pragma omp sections

{

#pragma omp section

printf("Soy el thread %d, en solitario en la seccion 1ª n",iam);

#pragma omp section

printf("Soy el thread %d, en solitario en la sección 2ª n",iam);

#pragma omp section

printf("Soy el thread %d, en solitario en la seccion 3ª n",iam);

}//sections

}//parallel

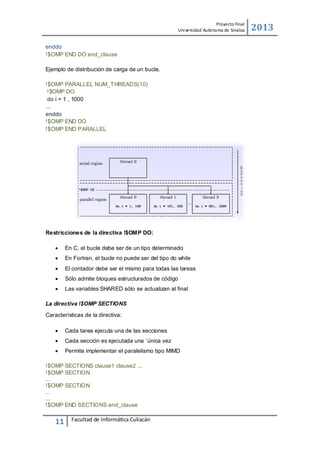

Compilación y ejecución

Para compilar y ejecutar programas con OpenMP use: gcc -fopenmp -0 <ejecutable>

<fuente> donde ejecutable es el nombre del archivo de salida y fuente es el archivo a

compilar o programa fuente con extension .c.

#include <omp.h>

#include <stdio.h>

int main (int argc, char *argv[]) {

int th_id, nthreads;

#pragma omp parallel private(th_id)

{

th_id = omp_get_thread_num();

printf("Hello World from thread %dn", th_id);

#pragma omp barrier

if ( th_id == 0 ) {

nthreads = omp_get_num_threads();

printf("There are %d threadsn",nthreads);

}

}

return 0;

}

Así para compilar este programa llamado hola_openmp.c seria.

[ah.escalante10@uas ~]$ gcc -fopenmp -o hola_openmp hola_openmp.c

14

Facultad de Informática Culiacán](https://image.slidesharecdn.com/computoenparalelo-131223230405-phpapp01/85/Computo-en-paralelo-con-OpenMP-y-OpenMPI-14-320.jpg)

![Proyecto Final

Uni versidad Autónoma de Sinaloa

2013

Si se requiere agregar funciones matemáticas agregue la librería con: mpicc -lm -fopenmp

-o <ejecutable> <fuente>.

Ejecución de trabajos con OpenMP. Ejecute el programa de forma normal como cualquier

otro programa hecho en C.

[ah.escalante10@uas ~]$ ./hola_openmp

Hello World from thread 1

Hello World from thread 0

There are 2 threads

Observe que no se está usando algún nodo del Clúster ya que esta autentificado en

gridmorelos.uaem.mx que es el front-end o nodo maestro, para usar los nodos del Clúster

se requiere lanzar los programas uno a uno ya que no es un programa MPI, si por ejemplo

se desea usar un nodo en especifico podría lanzarlo de la siguiente manera, primero

observando los nodos disponibles.

[ah.escalante10@uas ~]$ rocks list host

HOST

Uas

MEMBERSHIP CPUS RACK RANK RUNACT ION INSTALLATION

:

Frontend

2

0

0

os

install

compute-0-0: Compute

2

0

0

os

install

compute-0-1: Compute

2

0

1

os

install

...

Al seleccionar el nodo llamado compute-0-0 el comando seria:

[ah.escalante10@uas ~]$ ssh compute-0-0 ./hola_openmp

Hello World from thread 0

Hello World from thread 1

There are 2 threads

Si requiere lanzar los programas OpenMP a lo largo de todo el Cluster podría implementar

un Script que realice esta misma tarea por cada nodo disponible. 6

15

Facultad de Informática Culiacán](https://image.slidesharecdn.com/computoenparalelo-131223230405-phpapp01/85/Computo-en-paralelo-con-OpenMP-y-OpenMPI-15-320.jpg)