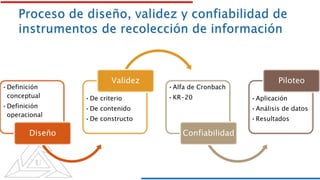

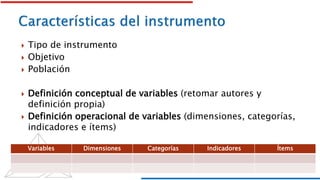

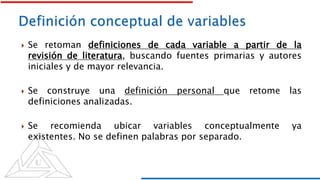

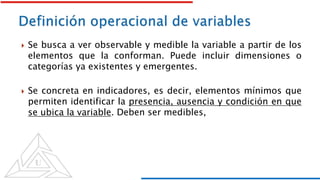

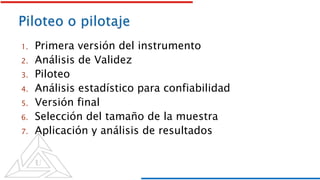

Este documento presenta las etapas para el diseño y validación de instrumentos de recolección de información, incluyendo la definición conceptual y operacional de variables, el diseño del instrumento, y los métodos para evaluar la validez y confiabilidad como el alfa de Cronbach y KR-20. El proceso comprende varias iteraciones que incluyen el piloteo y análisis estadístico para generar la versión final del instrumento.