Este documento describe el algoritmo de razón de aprendizaje variable (LVBP), el cual adapta dinámicamente la tasa de aprendizaje durante el entrenamiento de una red neuronal. Aumenta la tasa de aprendizaje cuando el error desciende constantemente y la reduce cuando el error aumenta, acelerando la convergencia. También presenta variantes como Delta-bar-delta y SuperSAB, y provee ejemplos de su implementación en Matlab/NNToolbox.

![traingda Es una funcion que entrena redes multicapa con retropropagación, actualizando W y b de acuerdo al gradiente descendente con razón de aprendizaje adaptable. Sintaxis [net, tr] = traingda (net, P,T,A,Q,Ts,VV) Algoritmo de Retropropagación con Aprendizaje Adaptable (LVBP)](https://image.slidesharecdn.com/4lvbp-090922013438-phpapp02/85/Razon-de-Aprendizaje-Variable-lvbp-20-320.jpg)

![Donde: net = Define la red neuronal net = netff([0 5 ] [3 1] {tansig purelin} traingda ) P patrones de entrada T valores objetivo Ai Condiciones iniciales Q Tamaño del lote Ts Tamaño del paso VV Estructura de vectores de validación](https://image.slidesharecdn.com/4lvbp-090922013438-phpapp02/85/Razon-de-Aprendizaje-Variable-lvbp-21-320.jpg)

![trainbpx Entrena redes multicapa con retropropagación rápida. Se puede usar para redes de una,dos o tres capas. Ejemplo use la funcion trainbpx para una red de dos capas. [W1,b1,W2,b2,epochs,tr] = trainbpx (W1,b1,’tansig’, W2,b2,’purelin’,p,t,tp) Método del Momento y Aprendizaje Variable](https://image.slidesharecdn.com/4lvbp-090922013438-phpapp02/85/Razon-de-Aprendizaje-Variable-lvbp-24-320.jpg)

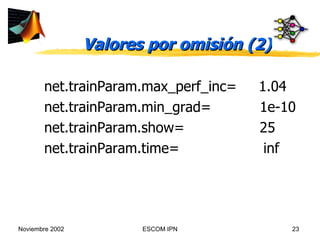

![Valores por omisión para tp tp= [disp-freq = 25 max-epoch= 100 err-goal= 0.02 lr= 0.01 momentum= 0.9 lr-inc= 1.05 lr-dec= 0.7 err-ratio= 1.04 ]](https://image.slidesharecdn.com/4lvbp-090922013438-phpapp02/85/Razon-de-Aprendizaje-Variable-lvbp-25-320.jpg)

![%EJEMPLO: OR EXCLUSIVA clear;echo on;clc;NNTWARN OFF; P = [0 0 1 1 ;0 1 0 1]; T = [0 1 1 0 ]; [w1,b1,w2,b2]=initff(P,2, 'tansig' ,1, 'purelin' ) [w1, b1,w2,b2,epochs,tr]= trainbpx(w1,b1, 'tansig' ,w2,b2, 'purelin' ,P,T)](https://image.slidesharecdn.com/4lvbp-090922013438-phpapp02/85/Razon-de-Aprendizaje-Variable-lvbp-26-320.jpg)

![[a1,a2]=simuff(P,w1,b1, 'tansig' ,w2,b2, 'purelin' ) pause %Pulse una tecla para graficar la solución plotpv(P,T); plotpc(w1,b1); plotpc(w2,b2); echo off](https://image.slidesharecdn.com/4lvbp-090922013438-phpapp02/85/Razon-de-Aprendizaje-Variable-lvbp-27-320.jpg)