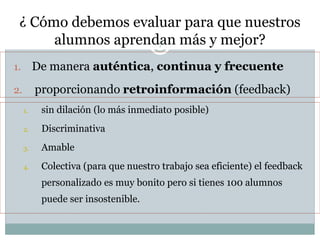

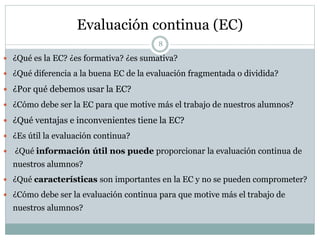

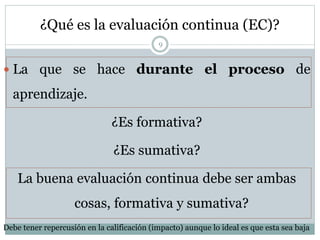

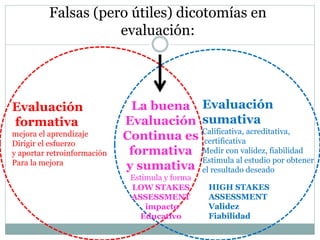

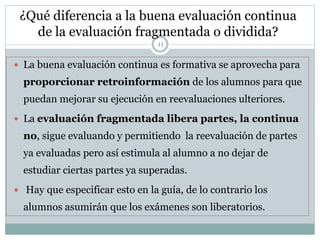

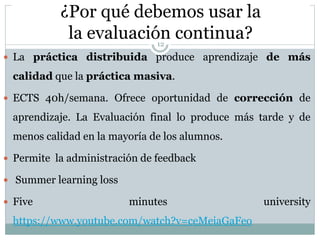

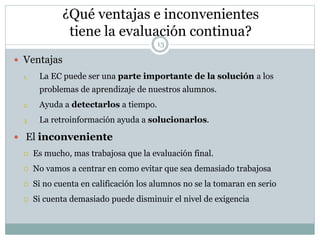

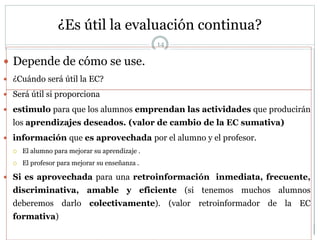

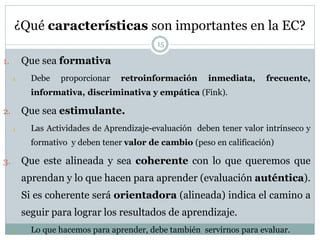

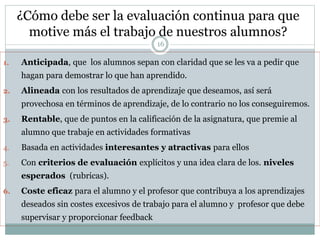

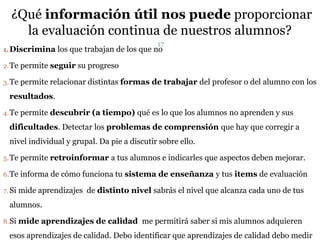

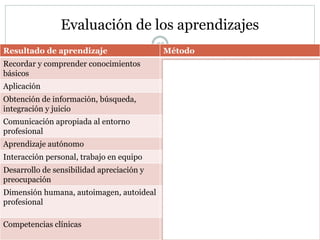

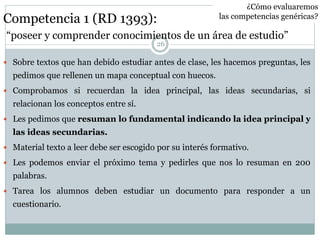

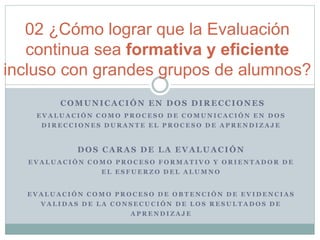

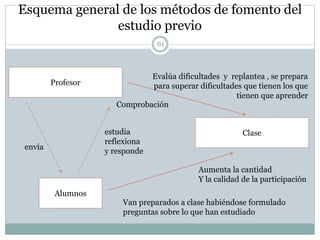

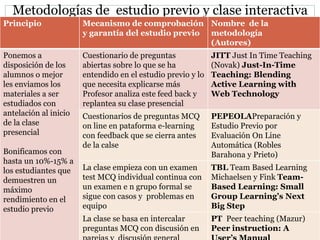

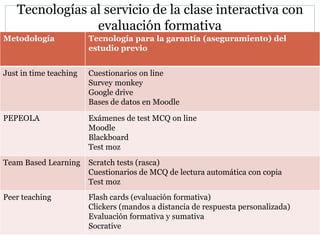

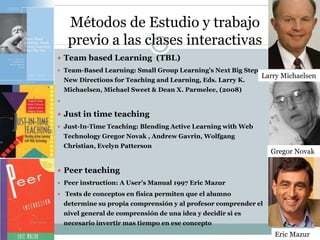

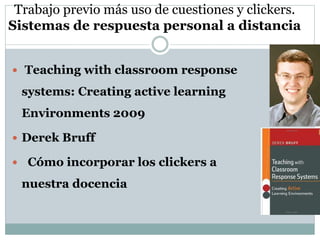

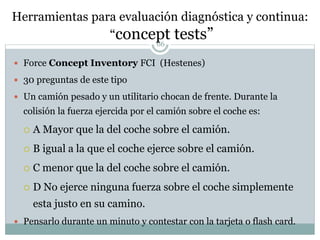

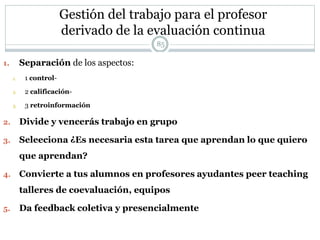

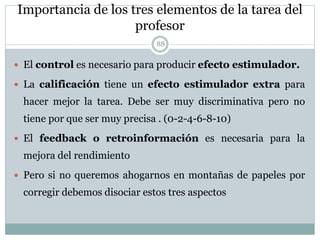

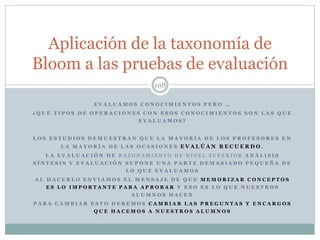

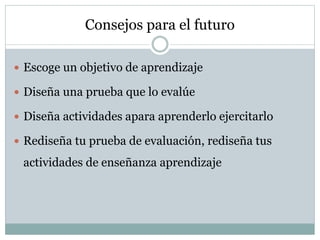

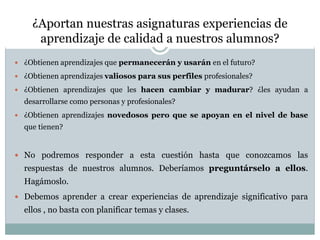

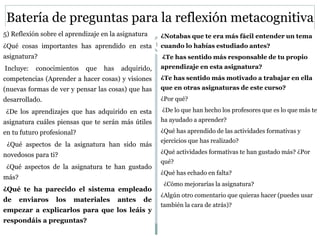

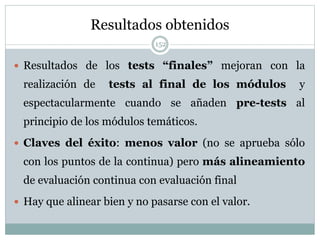

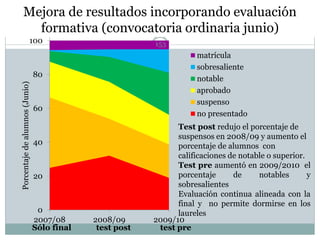

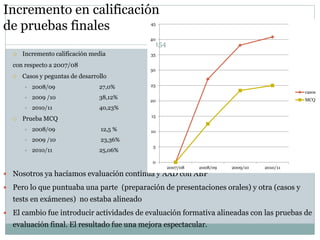

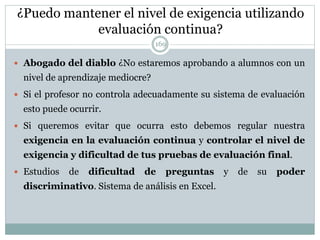

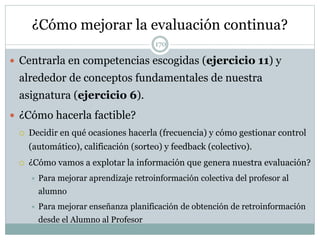

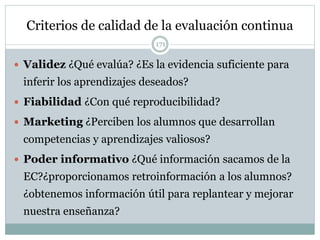

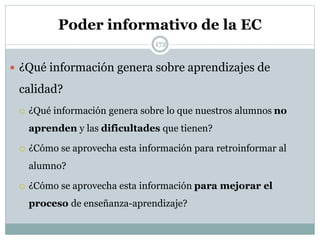

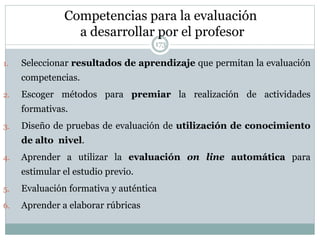

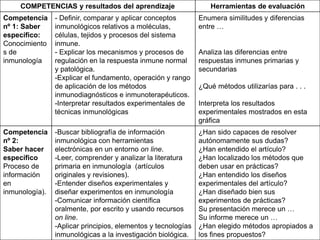

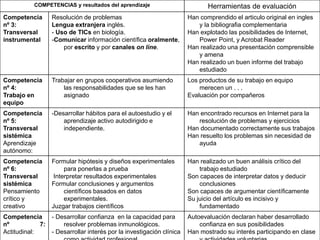

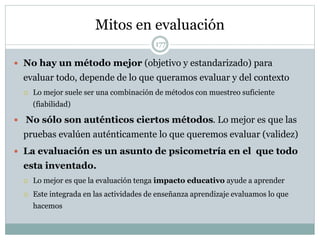

La evaluación continua es importante porque es la herramienta más poderosa que tienen los profesores para estimular y orientar el aprendizaje de los estudiantes. Debe ser formativa, continua y frecuente, y proporcionar retroalimentación oportuna para mejorar el aprendizaje. La evaluación debe alinearse con los objetivos y métodos de aprendizaje para asegurar que los estudiantes aprendan lo que se pretende.