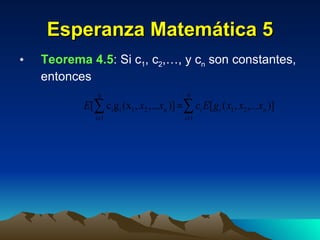

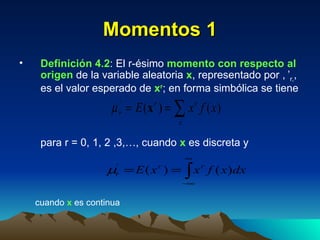

El documento presenta los conceptos básicos de la esperanza matemática, los momentos y la covarianza de variables aleatorias discretas y continuas. Define la esperanza matemática, los momentos de orden r con respecto al origen y la media, la varianza y la desviación estándar. También introduce la función generatriz de momentos, los momentos producto, y los teoremas relacionados con combinaciones lineales de variables aleatorias. Finalmente, explica la técnica de transformación de variables y la función generatriz de momentos para sumas de variables aleatorias independientes.

![Esperanza Matemática 2 Teorema 4.1 : Si x es una variable aleatoria discreta y f(x) es el valor de su distribución de probabilidad en x, el valor esperado de la variable aleatoria g( x ) es E[g( x )] = x g(x) f(x) En forma correspondiente, si x es una variable aleatoria continua y f(x) es el valor de su densidad de probabilidad en x, el valor esperado de la variable aleatoria g( x ) es](https://image.slidesharecdn.com/0prob4-1286629895-phpapp02/85/0-Prob4-3-320.jpg)

![Esperanza Matemática 4 Teorema 4.4 : Si x y y son variables aleatorias discretas y f(x,y) es el valor de su distribución de probabilidad conjunta en (x,y), el valor esperado de la variable aleatoria g( x , y ) es E[g( x,y )] = x y g(x,y)f(x,y) En forma correspondiente, si x y y son variables aleatorias continuas y f(x,y) es el valor de su densidad conjunta en (x,y), el valor esperado de la variable aleatoria g( x,y ) es](https://image.slidesharecdn.com/0prob4-1286629895-phpapp02/85/0-Prob4-5-320.jpg)

![Técnica de Transformación: una variable Teorema 4.16 : Sea f(x) el valor de la densidad de probabilidad de la variable aleatoria continua x en x. Si la función dada por y = u(x) es diferenciable y creciente o decreciente para todos los valores contenidos en el rango de x para los cuales f(x) 0, entonces, para estos valores de x, la ecuación y = u(x) puede resolverse de manera única para cada x con el fin de producir x = w(y) y para los valores de y correspondientes la densidad de probabilidad de y = u( x ) está dada por g(y) = f[w(y)][w’(y)] siempre que u’ (x) 0. En cualquier parte, g(y) = 0](https://image.slidesharecdn.com/0prob4-1286629895-phpapp02/85/0-Prob4-21-320.jpg)

![Técnica de Transformación: dos variables 1 Teorema 4.17 : Sea f(x 1 ,x 2 ) el valor de la densidad de probabilidad conjunta de las variables aleatorias continuas x 1 y x 2 en (x 1 ,x 2 ) . Si las funciones dadas por y 1 = u 1 (x 1 ,x 2 ) y y 2 = u 2 (x 1 ,x 2 ) son parcialmente diferenciables con respecto a x 1 y x 2 y representan una transformación biunívoca de todos los valores contenidos en el rango de x 1 y x 2 para los cuales f(x 1 ,x 2 ) = 0, entonces, para estos valores de x 1 y x 2 , las ecuaciones y 1 = u 1 (x 1 ,x 2 ) y y 2 = u 2 (x 1 ,x 2 ) pueden resolverse de manera única para cada x 1 y x 2 con el fin de producir x 1 = w 1 (y 1 , y 2 ) y x 2 = w 2 (y 1 , y 2 ), y para los valores correspondientes de y 1 y y 2 la densidad de probabilidad conjunta de y 1 = u 1 ( x1 , x 2 ) y y 2 = u 2 ( x1 , x 2 ) está dada por g (y 1 , y 2 ) = f [w 1 (y 1 , y 2 ), w 2 (y 1 , y 2 )] IJI](https://image.slidesharecdn.com/0prob4-1286629895-phpapp02/85/0-Prob4-22-320.jpg)