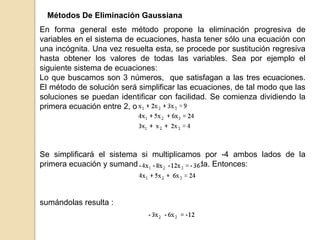

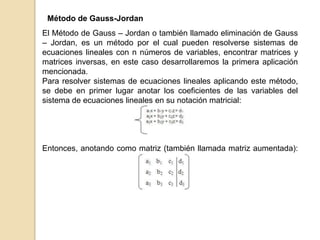

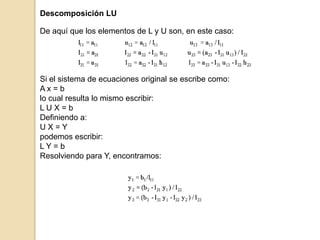

Este documento presenta varios métodos para resolver sistemas de ecuaciones lineales, incluyendo el método de eliminación de Gauss, descomposición LU, factorización de Cholesky, y métodos iterativos como Gauss-Seidel y Jacobi. Explica los pasos matemáticos involucrados en cada método y cuándo cada uno es más adecuado para ciertos tipos de sistemas.

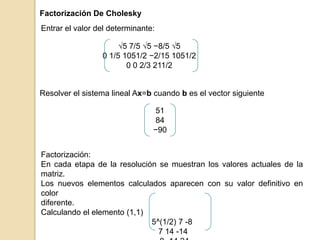

![Factorización De Cholesky

Una matriz simétrica es aquella donde Aij = Aji para toda i y j, En otras

palabras, [A] =[A] T. Tales sistemas ocurren comúnmente en problemas

de ambos contextos: el matemático y el de ingeniería. Ellos ofrecen

ventajas computacionales ya que sólo se necesita la mitad de

almacenamiento y, en la mayoría de los casos, sólo se requiere la

mitad del tiempo de cálculo para su solución. Al contrario de la

Descomposición LU, no requiere de pivoteo. El método de

Factorización de Cholesky se basa en demostrar que si una matriz A

es simétrica y definida positiva en lugar de factorizarse como

LU, puede ser factorizada como el producto de una matriz triangular

inferior y la traspuesta de la matriz triangular inferior, es decir los

factores triangulares resultantes son la traspuesta de cada uno.

Ejemplo:

Obtener la factorización de Cholesky de la siguiente matriz (entrar sólo

los elementos de U, la triangular superior)

5 7 −8

7 14 −14

−8 −14 24](https://image.slidesharecdn.com/analisisnumerico-130628194125-phpapp01/85/Solucion-de-Sistemas-de-Ecuaciones-Lineales-Analisis-numerico-9-320.jpg)