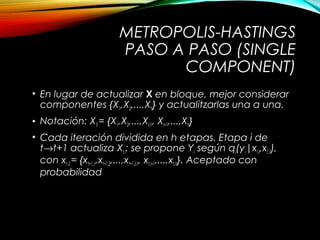

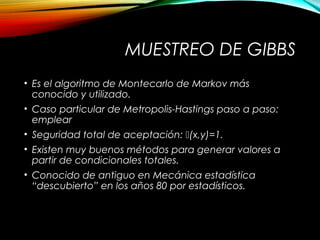

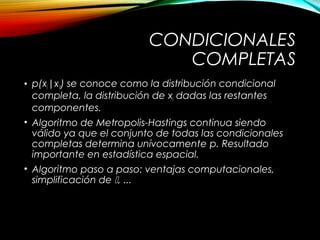

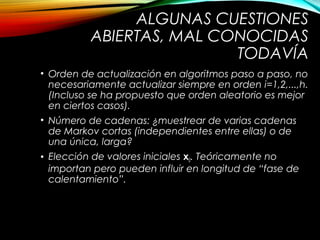

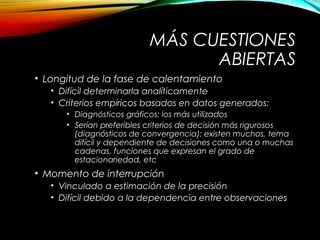

Este documento presenta un resumen de los métodos de Montecarlo basados en cadenas de Markov. Explica el algoritmo general de Metropolis-Hastings y métodos específicos como el algoritmo de Metrópolis, el muestreador de independencia y el muestreo de Gibbs. También discute cuestiones abiertas como la longitud de la fase de calentamiento y el momento de interrupción de los algoritmos.