El documento detalla los conceptos fundamentales del álgebra lineal, incluyendo espacios vectoriales, combinaciones lineales, independencia y dependencia lineal, así como definiciones relacionadas con bases y dimensiones. Se discuten ejemplos de subespacios y las propiedades de matrices, incluyendo el espacio columna y el espacio fila. Además, se exploran teoremas sobre la representación de vectores, el rango de matrices y transformaciones relevantes en el contexto de cambios de base.

![Dependencia e independencia lineal Sea S={v1,v2,...vn} un conjunto de vectores. Para mostrar si es linealmente independiente se resuelve la ecuación: [v1 v2 ... vn] =0 1 2 ... n](https://image.slidesharecdn.com/espaciosvectorialesdiapositivas-100519000040-phpapp02/85/Espacios-vectoriales-13-320.jpg)

![Dependencia e independencia lineal Entonces ya podemos aplicar Gauss para resolver el sistema y ver su solución Si la matriz [v1 ...vn] es de rango n entonces tiene solución única Si la matriz [v1 ... vn] es de rango menor a n, entonces tiene más de una solución.](https://image.slidesharecdn.com/espaciosvectorialesdiapositivas-100519000040-phpapp02/85/Espacios-vectoriales-14-320.jpg)

![Bases, Dimensión y coordenadas El concepto fácilmente se puede generalizar a cualquier par de bases Lo que es más chido... (P [x] 2 ,R) una posible base es B={1, x, x 2 } v1=1 en la base 1 0 0](https://image.slidesharecdn.com/espaciosvectorialesdiapositivas-100519000040-phpapp02/85/Espacios-vectoriales-35-320.jpg)

![Pausa: Cosas de una Matriz Demostración caso 1.- Sea F=E 1 E 2 ...E n la secuencia de matrices elementales que realizan las operaciones elementales que transforman a A en B. F tiene inversa=no singular FA=B Fx=0 x=0 (solución única) Si las columnas de A son L.D. entonces 1 a 1 + 2 a 2 +...+ n a n =A[ ] FA[ ]=B[ ] Si A es LD hay muchas combinaciones ](https://image.slidesharecdn.com/espaciosvectorialesdiapositivas-100519000040-phpapp02/85/Espacios-vectoriales-42-320.jpg)

![Pausa: Cosas de una Matriz que dan cero esas mismas combinaciones en B dan cero y sus columnas son LI. Si A tiene una sola combinación que da cero, entonces en B será la única posibilidad de dar cero, ya que sólo es este caso FA[ ]=0 Apliquemos esto a cualquier colección de columnas de A y se tendrá la demostración de la primera parte. Demostración caso 2.- Un matriz renglón y es una CL de los renglones de A ssi y =xA para alguan matriz renglón x, pero y =xF -1 FA=x’B, para x’=xF -1](https://image.slidesharecdn.com/espaciosvectorialesdiapositivas-100519000040-phpapp02/85/Espacios-vectoriales-43-320.jpg)

![c1=[0 4 8] c2=[1 5 9] c3=[2 6] c4=[3 7] 0 4 8 1 5 9 2 6 3 7 X 0 1 2 3 Y X/Ker A Aquí está A Ejem. A(x)=x módulo 4 -es el residuo de la división, no la congruencia Como X/Ker A y la imagen de A tienen la misma cantidad de elementos, entoces hay un isomorfismo entre X/Ker A y Im(A) [X/Ker A Im(A)] Significado geométrico de esta relación](https://image.slidesharecdn.com/espaciosvectorialesdiapositivas-100519000040-phpapp02/85/Espacios-vectoriales-68-320.jpg)

![c1=[0 4 8] c2=[1 5 9] c3=[2 6] c4=[3 7] 0 4 8 1 5 9 2 6 3 7 X 0 1 2 3 Y X/Ker A Aquí está A Significado geométrico de esta relación Proposición. Sea A:X Y y sea P A :X X/Ker A su proyección canónica, entonces g:X/ker A im(A) tal que A=g P A , donde g es un isomorfismo. P A](https://image.slidesharecdn.com/espaciosvectorialesdiapositivas-100519000040-phpapp02/85/Espacios-vectoriales-69-320.jpg)

![Significado geométrico de esta relación Estamos en los límites... Si los conjuntos tienen estructura matemática, p.e. X, Y son espacios vectoriales y la función A resulta ser un operador lineal. Ax1=Ax2 es la relación Ker A. Un caso particular es para la imagen cero. En este caso todos los x, tales que Ax=0 formarán una clase de equivalencia. Las demás clases de equivalencia las obtendremos al estudiar las otras imágenes de A. Sin embargo, este proceso puede resultar muy lento, sobre todo porque Y tiene un número infinito de elementos. Una forma más adecuada es estudiarlos a través de la clase de equivalencia del 0 [0].](https://image.slidesharecdn.com/espaciosvectorialesdiapositivas-100519000040-phpapp02/85/Espacios-vectoriales-73-320.jpg)

![Significado geométrico de esta relación Estamos en los límites... Por ejemplo, si queremos estudiar el caso para la imagen y, entonces debemos encontrar todos los x tales que Ax=y. x1, x2 [x], Ax1=Ax2=y, entonces A(x1-x2)=0. Entonces si x1 [x], se tiene que x2 [x] ssi (x1-x2) [0]. Como la clase [0] es un subespacio de X De hecho si Ax=0 y Ay=0, entonces A(x+ y)=0 y por tanto es un subespacio entonces (x1-x2) span[0], o (x1-x2) = 1 e 1 + 2 e 2 +...+ n e n Si x1 está fijo, entonces x2= x1- 1 e 1 - 2 e 2 -...- n e n .............................(1) Como con la clase de equivalencia [0] se generan todas las demás, a está clase la llamaremos genéricamente Kernel de A.](https://image.slidesharecdn.com/espaciosvectorialesdiapositivas-100519000040-phpapp02/85/Espacios-vectoriales-74-320.jpg)

![Significado geométrico de esta relación Estamos en los límites... Como se observa, la ecuación (1) es un método para calcular todas las clases de equivalencia [x2]. Se puede ver que es un un espacio vectorial (el del Kernel) desplazado por x1 (cualquier vector de la clase). A esta clase de equivalencia, y sólo cuando hablamos de operadores lineales en espacios vectoriales, le llamaremos una variedad lineal. No es un espacio, ya que en general, el cero no está incluído en dicha variedad, pero si será un espacio vectorial vía módulo algún vector de la clase. Ejemplos](https://image.slidesharecdn.com/espaciosvectorialesdiapositivas-100519000040-phpapp02/85/Espacios-vectoriales-75-320.jpg)

![Significado geométrico de esta relación Estamos en los límites... A: 2 2 tal que A([x y] T )=[x–y y-x] T . Claramente A es un operador lineal y un vector de la forma [k k] T está en la clase de equivalencia [0] o Kernel de A. El vector [2 1]T no está en la clase [0], pero si está en la clase [[2 1] T ]. Los vectores que pertenecen a esta clase, de acuerdo a la ecuación (1) son: X=[2 1] T - [1 1] T](https://image.slidesharecdn.com/espaciosvectorialesdiapositivas-100519000040-phpapp02/85/Espacios-vectoriales-76-320.jpg)

![Significado geométrico de esta relación Estamos en los límites... Clase [0] Clase [2 1] T](https://image.slidesharecdn.com/espaciosvectorialesdiapositivas-100519000040-phpapp02/85/Espacios-vectoriales-77-320.jpg)

![Significado geométrico de esta relación Si tenemos un operador lineal A:V W, entonces el Kernel de A será un subespacio de V, y cada una de las clases de equivalencia será una variedad lineal paralela al Kernel de A. Más aún, el conjunto de las clases de equivalencia se denotará en la forma común V/Ker A y será llamado el espacio cociente V/Ker A. Proposición. Sea un operador lineal A:V W, entonces el conjunto V/Ker A es un espacio vectorial. Demo. En este espacio, el vector nulo es la clase [0]. De hecho se tiene](https://image.slidesharecdn.com/espaciosvectorialesdiapositivas-100519000040-phpapp02/85/Espacios-vectoriales-79-320.jpg)

![Significado geométrico de esta relación [v1]=[v1]+[0] para cualquier v1 V. De la ecuación (1) x2= v1- 1 e 1 - 2 e 2 -...- n e n se observa que esto es cierto, ya que x2 [v1]. Los escalares, son los del campo definido en V. La suma de vectores [v1]+[v2]=[v3] se define como x1 [v1], x2 [v2] y x1+x2 [v3]. Note que está bien definida ya que cualquier x1 [v1] y x2 [v2] sirven. De hecho v1- 1 [0]+v2- 2 [0]=v1+v2- [0]=[v3] Todas las propiedades se pueden demostrar y resulta un espacio vectorial](https://image.slidesharecdn.com/espaciosvectorialesdiapositivas-100519000040-phpapp02/85/Espacios-vectoriales-80-320.jpg)

![Norma Definición.- Para vectores x=[x 1 x 2 ... x p ]T, las normas || || 1 , || || 2 , || || son llamadas norma 1, norma 2 y norma infinito respectivamente y se definen como: || || 1 =|x 1 |+|x 2 |+...+|x p | || || 2 =(|x 1 | 2 +|x 2 | 2 +...+|x p | 2 ) 1/2 || || =max{|x 1 |, |x 2 |, ...,|x p |}](https://image.slidesharecdn.com/espaciosvectorialesdiapositivas-100519000040-phpapp02/85/Espacios-vectoriales-85-320.jpg)

![Norma Definición.- Sea || || una norma en (V,F). Una secuencia de vectores vi se dice que converje al vector v ssi la secuencia de número reales ||vi-v || Para vectores x=[x 1 x 2 ... x p ]T, las normas || || 1 , || || 2 , || || son llamadas norma 1, norma 2 y norma infinito respectivamente y se definen como: || || 1 =|x 1 |+|x 2 |+...+|x p | || || 2 =(|x 1 | 2 +|x 2 | 2 +...+|x p | 2 ) 1/2 || || =max{|x 1 |, |x 2 |, ...,|x p |}](https://image.slidesharecdn.com/espaciosvectorialesdiapositivas-100519000040-phpapp02/85/Espacios-vectoriales-86-320.jpg)

![Transformaciones lineales Más propiedades de las transformaciones lineales T(u-v)=T[u+(-1)v]=T(u)+T[(-1)v]=T(u)+(-1)T(v)=T(u)-T(v) T( 1 v 1 +...+ n v n )= 1 v 1 +...+ n v n Esto se puede ver por asociatividad e inducción Teorema. Sea (V,F) un espacio vectorial de dimensión finita con base B={v 1 ,...v n } y T1, T2 dos transformaciones lineales. Si T1(vi)=T2(vi) para todo vi en B, entonces T1(v)=T2(v) para v en (V,F). Demo, como cualquier vector de (V,F) se escribe como v= 1 v 1 +...+ n v n , entonces T1(v)=T1( 1 v 1 +...+ n v n )= T1( 1 v 1 )+...+T1( n v n )=T2( 1 v 1 )+...+T2( n v n )=T2(v)](https://image.slidesharecdn.com/espaciosvectorialesdiapositivas-100519000040-phpapp02/85/Espacios-vectoriales-104-320.jpg)

![Transformaciones lineales Teorema. Sea (V,F) un espacio vectorial de dimensión finita con base B={v 1 ,...v n } y (W,G) un espacio vectorial que contiene a los vectores w1,...,wn, entonces existe una única transformación lineal tal que T(vi)=wi, para vi en B. Demo. Como cualquier vector de (V,F) se escribe como v= 1 v 1 +...+ n v n , entonces T se define como T(v)= 1 w 1 +...+ n w n T será una transformación lineal T(u+v)=T[( 1 v 1 +...+ n v n )+( 1 v 1 +...+ n v n )]= =T[( 1 + 1 ) v 1 +...+( n + n ) v n ] Por la definición de T, = ( 1 + 1 ) w 1 +...+( n + n ) w n =T(u)+T(v)](https://image.slidesharecdn.com/espaciosvectorialesdiapositivas-100519000040-phpapp02/85/Espacios-vectoriales-105-320.jpg)

![Transformaciones lineales De igual forma T( u)=T[( 1 v 1 +...+ n v n )] Por la definición de T, 1 w 1 +...+ n w n = T(u) Por teorema anterior se tiene la unicidad Tarea: Sean (V,F) y (W,G) dos espacios vectoriales y T:(V,F) (W,G) una transformación lineal. Demsotrar que el kernel de T es un subespacio de (V,F) y que la imagen de T es un subespacio de (W,G).](https://image.slidesharecdn.com/espaciosvectorialesdiapositivas-100519000040-phpapp02/85/Espacios-vectoriales-106-320.jpg)

![Transformaciones lineales Sean (V,F) y (W,G) dos espacios vectoriales y T:(V,F) (W,G) , entonces existe una única matriz A (dim(v), dim(W)) tal que T(x)=Ax A est la matriz de transformación correspondiente a T. Demo sea B={e1,...,en} la base canónica en (V,F) T(ei)=wi Se puede formar la matriz A=[w1 wn] entonces Aei=wi (T(ei)=wi) En general T(x)=T( 1 e 1 + ... + n e n )= 1 w 1 + ... + n w n También Ax=A[ 1 e 1 + ... + n e n ]= 1 w 1 + ... + n w n =T(x)](https://image.slidesharecdn.com/espaciosvectorialesdiapositivas-100519000040-phpapp02/85/Espacios-vectoriales-110-320.jpg)

![Transformaciones lineales Teorema. Sean (V,F), (W,G) dos espacios vectoriales de dimensiones n y m respectivamente. Sea T(V,F) (W,G) una transformación lineal. Sean B1={v1,...,vn} y B2={w1,...,wm} las bases de los espacios respectivamente. Entonces existe una única matriz A (m,n) tal que: [T(x)] B2 =A(x B1 ) [T(x)] B2 la representación de T(x) en B2 T(x)= 1 w 1 + ... + m w m [T(x)] B2 =[ 1 ... m ] T x B1 es la representación del vector en B1 La matriz A se conoce como la matriz de transformación correspondiente a T con respecto a las bases B1 y B2](https://image.slidesharecdn.com/espaciosvectorialesdiapositivas-100519000040-phpapp02/85/Espacios-vectoriales-112-320.jpg)

![Transformaciones lineales Considere los vectores T(v1, ...,T(vn), escríbase A=[[T(v 1 )] B2 ... [T(v n )] B2 ] Como Avi B1 =Ae i = [T(v i )] B2 y x B1 es la representación del vector en B1, i.e. [ 1 ... n] T entonces A x B1 =[[T(v 1 )] B2 ... [T(v n )] B2 ] x B1 = 1[T(v 1 )] B2 +...+[T(v n )] B2 ] n Por otro lado T(x B1 )=T( 1 v 1 +...+ n v n )= 1 T(v 1 )+...+ n T(v n ) Al poner cada uno de estos vectores en la representación de la base B2 se obtiene que: A x B1 = T(x B1 ) La unicidad es similar al teorema anterior](https://image.slidesharecdn.com/espaciosvectorialesdiapositivas-100519000040-phpapp02/85/Espacios-vectoriales-113-320.jpg)

![Transformaciones lineales Demo. Sabemos que [T(x)] B2 =Ax B1 Ahora, x B1 =Qx B1’ y [T(x)] B2 =P[T(x)] B2’ Por tanto P[T(x)] B2’ =A Qx B1’ [T(x)] B2’ =P -1 A Qx B1’ A’=P -1 AQ es la matriz de transformación](https://image.slidesharecdn.com/espaciosvectorialesdiapositivas-100519000040-phpapp02/85/Espacios-vectoriales-115-320.jpg)

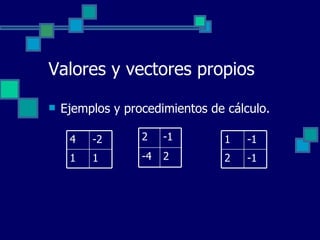

![Valores y vectores propios Se dice que F( ) es de orden n; y si F m 0, entonces F( ) es de grado m. Además F( ) se dice regular si det(F m ) 0 Definicion. Sean F( ) y G( ) matrices polinomiales de orden n., y G( ) es regular. Las matrices polinomiales Q( ) y R( ) se conocen como cociente derecho y residuo derecho respectivamente de F( ) dicidida por G( ) si F( )= Q( ) G( ) + R( ) y si el grado de R( ) es menor que el grado de G( ) [R( ) puede ser cero]](https://image.slidesharecdn.com/espaciosvectorialesdiapositivas-100519000040-phpapp02/85/Espacios-vectoriales-142-320.jpg)

Lo cual puede verse como P( )=( I-A)Q( )=Q( )( I-A) donde Q( )=adj( I-A) es una matriz polinomial en y P( )=det( I-A)I=a 0 I+a 1 I+...+ n I como P( ) es divisible por la derecha y por la izquierda por ( I-A) sin residuos, entonces P(A)=a 0 I+a 1 AI+...+A n I](https://image.slidesharecdn.com/espaciosvectorialesdiapositivas-100519000040-phpapp02/85/Espacios-vectoriales-146-320.jpg)

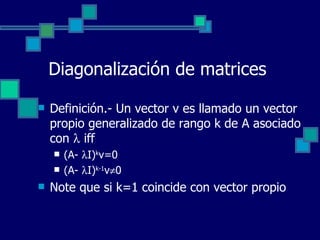

![Diagonalización de matrices Teorema. La matriz A (n,n) es diagonalizable ssi tiene n vectores propios linealmente independientes Si 1 , 2 , ..., n son los valores propios de A y los vectores propios x 1 , x 2 , ..., x n correspondientes a estos valores propios son linealmente independientes, entonces P -1 AP=diag{ 1 , 2 , ..., n }, donde P=[x 1 x 2 ... X n ]](https://image.slidesharecdn.com/espaciosvectorialesdiapositivas-100519000040-phpapp02/85/Espacios-vectoriales-149-320.jpg)

![Diagonalización de matrices Demostración. (si) Suponga que A tiene n vectores propios L.I. x 1 x 2 ... x n correspondientes a los valores propios 1 , 2 , ..., n (algunos pueden ser repetidos). Sea P la matriz [x 1 x 2 ... x n ], entonces AP= [Ax 1 Ax 2 ... Ax n ]= [ 1 x 1 2 x 2 ... n x n ] = [x 1 x 2 ... x n ]diag{ 1 , 2 , ..., n } =Pdiag{ 1 , 2 , ..., n } Como P es no singular tiene inversa P -1 AP=diag{ 1 , 2 , ..., n }](https://image.slidesharecdn.com/espaciosvectorialesdiapositivas-100519000040-phpapp02/85/Espacios-vectoriales-150-320.jpg)

![Diagonalización de matrices Suponer que vi es L.D. en {u1,...,ul} v i = 1 u 1 + 2 u 2 +...+ l u l Aplicando (A- 1 I) i 0= (A- 1 I) i [ 1 u 1 + 2 u 2 +...+ l u l ] Ahora aplicando (A- 2 I) l-1 y observando que (A- 2 I) l-1 (A- 1 I) i = (A- 1 I) i (A- 2 I) l-1 y el hecho de que (A- 2 I) l-1 u j =0, j=1,2,..., l-1 0= l (A- 1 I) i (A- 2 I) l-1 u l = l (A- 1 I) i u 1 Como (A- 2 I)u1=0 o Au1= 2 u1, la ecuación anterior se reduce a l ( 2 - 1 ) i u 1 =0](https://image.slidesharecdn.com/espaciosvectorialesdiapositivas-100519000040-phpapp02/85/Espacios-vectoriales-165-320.jpg)

![Matrices unitarias Si P es no singular B=P -1 AP transformación de similaridad Sirven para cambio de bases Más conveniente si las bases son ortogonales y ortonormales Si {x 1 ,...,x p } es un conjunto ortonormal x i T x i =1 y x i T x j =0 Si hacemos que P=[x 1 ,...,x p ] P T P=I o P T =P -1](https://image.slidesharecdn.com/espaciosvectorialesdiapositivas-100519000040-phpapp02/85/Espacios-vectoriales-169-320.jpg)

![Matrices unitarias 1 es el propio valor asociado a x 1 , podemos normalizar este vector para que ||x 1 || 2 =1 Entonces x1 entra a la base que ya teníamos de propiovectores ortonormalizados {w 1 ,...,w k } si no es otronormal a esta base, aplicamos Gram-Schmidt y tenemos la nueva base {x 1 ,w 1 ,...,w k } U= [x 1 ,w 1 ,...,w k ]=[x 1 ,W] A’=U T AU=[x 1 ,W] T A[x 1 ,W]=[x 1 ,W] T [Ax 1 AW]= = 1 x 1 T AW 0 W T AW 1 b T 0 C](https://image.slidesharecdn.com/espaciosvectorialesdiapositivas-100519000040-phpapp02/85/Espacios-vectoriales-173-320.jpg)

![A= A T A propiovalores 18 y 0. 1=18 (1/2) y 2=0 Un par de vectores propios de A T A normalizados son v1=[1.71/2 1.71/2] T y v2=[1.71/2 -1.71/2] T Entonces V=[V1 v2] 1 1 2 2 2 2 9 9 9 9](https://image.slidesharecdn.com/espaciosvectorialesdiapositivas-100519000040-phpapp02/85/Espacios-vectoriales-178-320.jpg)

![A= AA T = propiovalores 18 y 0. 1=18 y 2=0 Vectores propios de AA T normalizados son u1=[1/3 2/3 2/3] T u2=[(-2)5 1/2 /5 5 1/2 /5 0] T u3 =[(2)5 1/2 /15 (4)5 1/2 /15 (-1)5 1/2 /3 ] T Entonces U=[u1 u2 u3] 1 1 2 2 2 2 2 4 4 4 8 8 4 8 8](https://image.slidesharecdn.com/espaciosvectorialesdiapositivas-100519000040-phpapp02/85/Espacios-vectoriales-179-320.jpg)