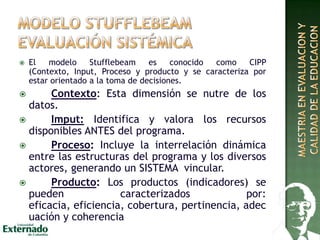

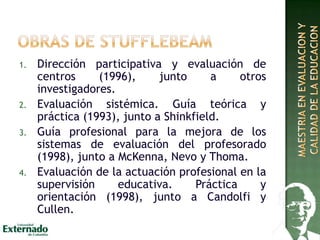

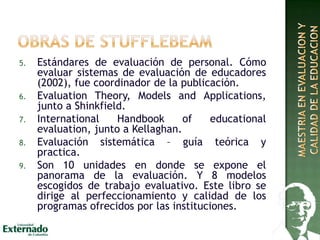

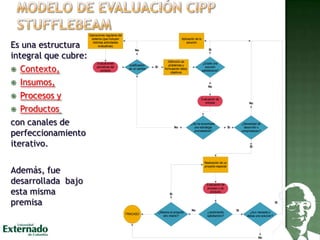

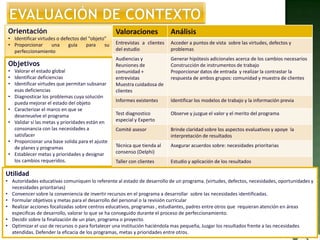

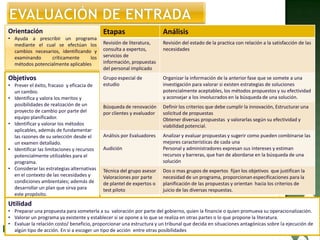

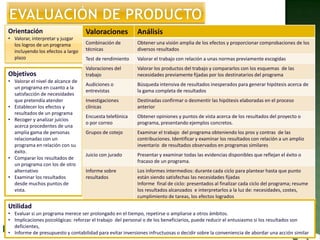

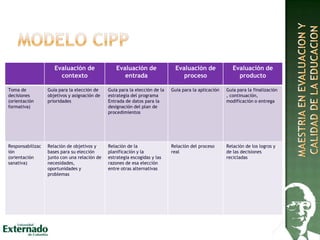

1) El documento presenta información sobre un seminario de fundamentos de evaluación impartido por Daniel L. Stufflebeam en Bogotá, Colombia en 2013. 2) Se describe el modelo de evaluación CIPP de Stufflebeam, el cual se enfoca en evaluar el contexto, los insumos, los procesos y los productos de un programa para orientar la toma de decisiones. 3) El documento incluye una lista de libros escritos por Stufflebeam sobre evaluación y modelos de evaluación.